Menschengemachte Klimahysterie –basierend auf computergestützen Modellen

von Prof. Dr. Thomas Rießinger

Österreichischer Humor neigt gelegentlich zur Morbidität. Mancher erinnert sich vielleicht noch an das Lied „Regen“ des österreichischen Liedermachers Ludwig Hirsch, in dem mit aller Gelassenheit die Verse

„Es regnet, es regnet, es regnet seinen Lauf.

Und wenn sie alle ersoffen sind, dann hört es wieder auf“

vorgetragen werden. Bekannter sind vermutlich Georg Kreislers Zeilen

„Der Frühling, der dringt bis ins innerste Mark

Beim Taubenvergiften im Park“,

ganz zu schweigen von manchen Aussagen des berufsmäßigen Grantlers Helmut Qualtinger, wie beispielsweise „In Wien mußt‘ erst sterben, bevor’s dich hochleben lassen. Aber dann lebst‘ lang.“

Es scheint also zumindest stellenweise ein etwas eigentümlicher Humor im Alpenland zu herrschen und ganz besonders eigentümlich wird er, wenn er mit politischem Aktivismus in Verbindung gerät. Beispiele sind leicht zu finden. Nachdem vor kurzem ein von den Aktionen der sogenannten „Letzten Generation“ nicht eben begeisterter Twitter-Benutzer seine Meinung äußerte, der totalitäre und wirre Geist, der auf den Unis herrsche, sei schon während der Corona-Zeit gut zur Schau gestellt worden, antwortete Reinhard Steurer, seines Zeichens Professor für Klimapolitik in Wien, im heiligen Zorn: „Wir werden euch alle einsperren. Lockdown forever. Jetzt fürchtet euch vor dieser totalitären Wissenschaft.“ Und als man es wagte, ihn per Twitter für seine Äußerung zu kritisieren, warf er seinen Kritikern Humorlosigkeit vor und meinte: „Ab sofort antworte ich Klimakrisen-Verleugnern und -Schwurblern einfach so, wie sie es hören wollen. … Ob es sie auch so amüsiert wie mich?“

Welch ein feinsinniger Humor! Fast ist man versucht, ihn mit den büttenrednerischen Bemühungen von Marie-Agnes Strack-Zimmermann zu vergleichen, bei deren Ausführungen so manchem die Tränen gekommen sein dürften, wenn schon nicht vor Lachen, dann doch wenigstens aus Verzweiflung. Aber beim Klima, bei der Rettung des Planeten vor der drohenden Katastrophe, hört eben der Spaß auf, zumal Steurer ja nicht irgendein Professor ist, sondern Professor für Klimapolitik. Nicht für Klimaforschung, nicht für Klimaphysik, sondern für Klimapolitik, weshalb er sich auch „seit vielen Jahren mit der politischen Dimension der Klimakrise im Allgemeinen bzw. mit der politischen Bedeutung von Ausreden und Schein-Klimaschutz in allen Bereichen der Gesellschaft im Speziellen“ beschäftigt. Ja, man muss den Mann verstehen, schließlich darf man nicht einfach die Klimapanik in Zweifel ziehen, da sich sonst jede Grundlage seiner Professur in Luft auflösen würde, und das will ihm doch sicher niemand zumuten.

Präventive Todesstrafe

Immerhin hat sich Scheurer im Vergleich zu anderen Klimabewegten eher zurückhaltend geäußert. Zehn Jahre sind ins Land gezogen, seit Richard Parncutt, ein aus Australien stammender Professor für Musikpsychologie in Graz, die Todesstrafe für Klimaleugner gefordert hat. Gewöhnliche Massenmörder wollte er nicht hinrichten, die waren ihm wohl zu harmlos, aber bei Klimawandelleugnern sei das etwas ganz anderes. „Ich möchte behaupten, dass es prinzipiell in Ordnung ist, jemanden umzubringen, um eine Million andere Menschen zu retten.“ Und: „Die Todesstrafe ist angemessen für einflussreiche Leugner der Erderwärmung.“ Eine interessante juristische Variante: die präventive Todesstrafe, ausgesprochen auf der Basis einer Theorie, die vor allem auf computergestützen Modellen beruht. Man sollte sie vielleicht einmal dem deutschen Bundesverfassungsgericht vorlegen, dem ja bekanntlich der Klimaschutz noch stärker am Herzen liegt als die Rechtsstaatlichkeit, von der Freiheit des Individuums gar nicht zu reden. Darf man sich für einen Augenblick vorstellen, ein deutscher Professor hätte Ähnliches über ein anderes Thema geäußert? Wenn es zum Beispiel nicht um Leugner der Erderwärmung ginge, sondern um einflussreiche Leugner der Impfnebenwirkungen? Die Reaktionen würden sich gewaltig unterscheiden. Hassrede! Hetze! Volksverhetzung! Hausdurchsuchung! Verhaftung! Doch auch Parncutt wurde hart gemaßregelt: Er musste ein Gespräch mit seinem Universitätsrektor und seinem Dekan überstehen. In Amt und Würden ist er nach wie vor. Nicht nur für einen großen Teil der politischen Elite gilt Helmut Qualtingers Diktum: „Es gibt kaum etwas Schöneres, als dem Schweigen eines Dummkopfes zuzuhören.“

Globale Durchschnittstemperatur

Aber werfen wir doch einmal einen Blick auf das, was diese Menschen, ob Professoren oder nicht, so sehr aus der Bahn wirft. Es ist, wie sollte es auch anders sein, die Hitze, die unerträglich ansteigende Hitze, die sich in Form einer steigenden globalen Durchschnittstemperatur zeigt. Daher hat man das bekannte und beliebte 1,5-Grad-Ziel ersonnen, das im Rahmen des Pariser Klimaabkommens 2015 beschlossen wurde: Im Vergleich zu den Temperaturen von 1850 darf und soll die globale Durchschnittstemperatur um nicht mehr als 1,5 Grad Celsius steigen, sonst kann man das Klima nicht retten und die Menschheit schwitzt sich ihrem eigenen Untergang entgegen.

Nun entsteht dabei aber das eine oder andere Problem. Was soll man beispielsweise unter der globalen Durchschnittstemperatur verstehen? Hier kann das Wetter- und Klimalexikon des Deutschen Wetterdienstes weiterhelfen. „Unter der globalen Durchschnittstemperatur,“ lesen wir dort, „versteht man die über die gesamte Erdoberfläche (Land/Wasser) gemittelte Temperatur in einem bestimmten Zeitraum.“ Man muss also den Durchschnittswert über alle Temperaturen eines Jahres und alle Weltgegenden ermitteln. Prinzipiell ist die Berechnung eines Durchschnitts kein Problem; hat man beispielsweise drei Messwerte zur Verfügung, so addiert man diese Messwerte, um die Summe anschließend durch drei zu teilen und so den Durchschnitt zu erhalten. Es geht hier aber nicht nur um drei Messwerte. Zur Bestimmung der tatsächlichen globalen Durchschnittstemperatur eines Jahres müsste man nichts weiter tun, als für jeden Punkt der Erdoberfläche die Temperatur zu jedem beliebigen Zeitpunkt des Jahres festzuhalten und dann mithilfe von ein wenig Integralrechnung den Mittelwert zu bilden. Das dürfte schwierig werden und das weiß man auch beim Deutschen Wetterdienst. „Da klimatologische Messungen über längere Zeiträume nur punktuell vorliegen, lassen sich Zeitreihen der globalen Mitteltemperatur nur annähernd bestimmen.“

Man kann immer nur endlich viele Orte und endlich viele Zeitpunkte auswerten und wird somit immer mehr oder weniger weit von der Realität entfernt sein. Ein einfaches fiktives Beispiel kann das verdeutlichen. Hat man etwa eine gerade verlaufende Strecke von einem Kilometer Länge und eine Messgröße, die sich wie das Quadrat der Strecke verhält, so wird man am Punkt 0 den Messwert 0 finden, am Punkt 0,5 den Messwert 0,5*0,5=0,25 und am Punkt 1 den Messwert 1*1=1. Wieder kann man nicht alle möglichen Punkte auswerten, man muss annähern. Die einfachste Näherung besteht darin, nur den Anfangs- und den Endwert zu betrachten und ihr Mittel zu bilden: das wäre der Durchschnitt aus 0 und 1, also 0,5. Sehr einfache Integralrechnung, die ich aus humanitären Gründen hier nicht vorführe, zeigt jedoch einen echten Mittelwert in Höhe von 0,33. Bezogen auf den echten Mittelwert habe ich durch die näherungsweise Durchschnittsbildung also einen Fehler von 50 % erzielt. Nimmt man noch einen Punkt hinzu, beispielsweise den Punkt auf halber Strecke mit dem Messwert 0,25, so findet man aus den jetzt vorhandenen drei Messwerten den gerundeten Mittelwert 0,42. Das ist schon besser, aber immer noch beträgt die Abweichung 25 %. Es ist also keineswegs selbstverständlich, dass ein angenäherter Mittelwert große Ähnlichkeiten mit dem tatsächlichen Mittelwert hat.

Manches andere kommt noch hinzu, denn aus dem Mittelwert, also der globalen Durchschnittstemperatur alleine kann man noch nicht auf die tatsächlichen klimatischen Verhältnisse schließen. Nehmen wir wieder ein fiktives Beispiel. In einem bestimmten Bereich der Welt gehe ich davon aus, dass zum Jahresbeginn eine Temperatur von 0 Grad Celsius herrscht, die sich im Verlauf des ersten Vierteljahres stetig und gleichmäßig auf 30 Grad Celsius erhöht, um dann wieder bis zum Ende des ersten Halbjahres auf 0 Grad abzusinken. Das Gleiche geschieht im zweiten Halbjahr, nur mit umgekehrtem Vorzeichen: Die Temperatur sinkt auf -30 Grad ab und erreicht pünktlich zum Jahresende wieder den Gefrierpunkt. Offenbar beträgt die jährliche Durchschnittstemperatur dieses Bereichs 0 Grad Celsius. Vergleicht man das mit einem anderen fiktiven Bereich, dessen Temperatur durchgängig bei 0 Grad liegt, so fällt auf, dass zwar beide Bereiche mit der gleichen jährlichen Durchschnittstemperatur geschlagen sind, aber offensichtlich sehr verschiedene klimatische Verhältnisse aufweisen. Die Durchschnittstemperatur alleine sagt nicht allzu viel aus.

Schon deshalb nicht, weil man zusätzlich den sogenannten Wärmeinseleffekt berücksichtigen muss: Städtische Regionen heizen sich aufgrund der Bebauung stärker auf als das ländliche Umland und man kann nicht davon ausgehen, dass diese Unterschiede weltweit angemessen berücksichtigt werden. Und selbstverständlich muss man gemessene Rohdaten gelegentlich nachbearbeiten – ein Prozess, der einen weiten Ermessensspielraum beinhaltet und gelegentlich dazu führt, dass nach der Bearbeitung der Daten eine stärkere Erwärmung vorliegt als vorher, je nach persönlicher Vorliebe und klimapolitischer Ausrichtung des Bearbeiters.

Das alles ist aber nicht weiter wichtig, denn entscheidend ist ja nicht die konkrete globale Durchschnittstemperatur, sondern nur die Änderungen der Temperatur, und um die festzustellen, braucht man die absoluten Temperaturen gar nicht, wie uns das Wissenschaftsmagazin „Quarks“ berichtet.

Es sei viel sinnvoller, „sich statt der absoluten Temperaturen die Temperaturveränderungen über längere Zeiträume anzusehen. Denn Veränderungen sind mit wissenschaftlichen Methoden viel genauer zu messen als absolute Werte. Zur Veranschaulichung: Wer auf dem Gipfel des Mount Everest eine Hütte baut, kann mit einem Zollstock exakt ausmessen, um wie viele Zentimeter der höchste Berg der Welt dadurch „gewachsen“ ist, wohingegen die Angabe der absoluten Höhe mit einem viel größeren Fehler behaftet ist, denn der Meeresspiegel schwankt und die Erdkruste schwingt.“

Ich lasse gern die Frage außer Acht, warum ausgerechnet der Mount Everest als Standort der Hütte herhalten musste, da man nur selten etwas vom Hüttenbau auf seinem Gipfel gehört hat. Doch auch unabhängig davon ist das Beispiel etwas seltsam. Übertragen auf die Temperaturmessung würde das bedeuten, dass man an einem bestimmten Punkt nicht die Temperatur zu zwei verschiedenen Zeitpunkten messen muss, um dann die Differenz zu bestimmen, sondern dass die Temperatur zum ersten Zeitpunkt – das entspricht der eigentlichen Höhe des Mount Everest – völlig egal ist, weil man am untersuchten Punkt zum zweiten Zeitpunkt irgendeine Wärmemenge – das entspricht der Höhe der gebauten Hütte – zur Anwendung bringt und somit die Temperaturdifferenz ohnehin kennt. Eine Wärmemenge ist aber keine Hütte, die man irgendwo aufbaut, man bringt sie nicht in einem Rucksack mit und freut sich an der gestiegenen Temperatur. Diese Veranschaulichung hinkt ähnlich stark wie Annalena Baerbocks außenpolitische Ideen.

Der Sünder ist identifiziert

Ob Differenzen oder nicht, man muss auch der Frage nachgehen, warum die – in welcher Form auch immer – gemessenen Durchschnittstemperaturen gestiegen sind. Und die Antwort ist klar. „Hauptverursacher des Klimawandels,“ erklärt das Bundesumweltministerium seinen jüngeren Lesern, „sind die Menschen, vor allem in den Industriestaaten. Fabriken, Autos, Flugzeuge, die Beleuchtung der Häuser und Städte – all das braucht Energie in Form von Strom, Gas oder Benzin. Und wo Strom aus Kohle erzeugt oder Benzin und Gas verbrannt werden, entsteht das Treibhausgas Kohlendioxid.“ Da haben wir es. Es ist das Kohlendioxid, der Sünder ist identifiziert. Wenn beispielsweise der europäische Kontinent nicht im Sinne der Europäischen Union bald zum klimaneutralen Kontinent wird, also „so viele CO₂-Emissionen beseitigt, wie er produziert“, dann ist die Klimakatastrophe nicht mehr aufzuhalten und es bleibt uns nichts anderes übrig, als uns an den Straßen festzukleben und darauf zu warten, dass die Erhitzung den Asphalt zum Schmelzen bringt. Eine andere Möglichkeit gibt es nicht, denn andere Ursachen für die Entwicklung des globalen Klimas muss man nicht in Betracht ziehen.

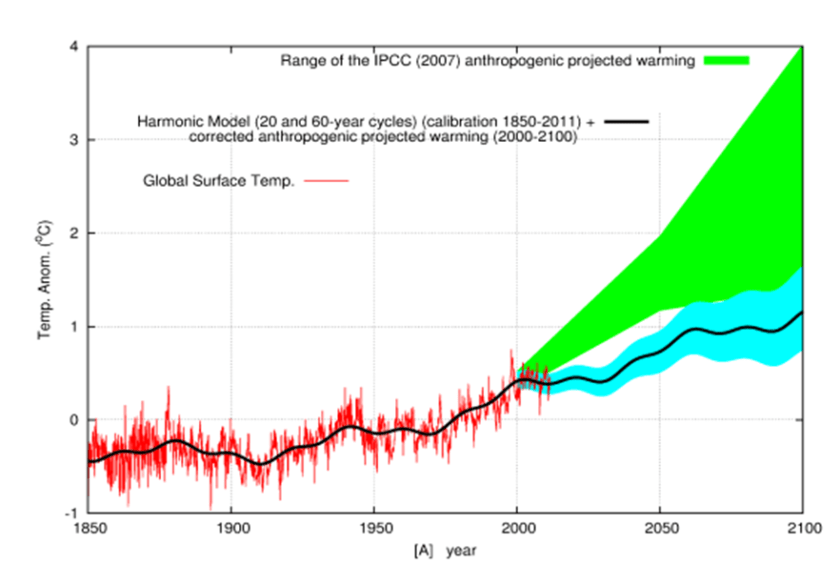

Wo sollten sie auch sein? Niemanden muss es bedenklich stimmen, dass das Basisjahr für das bereits erwähnte 1,5-Grad-Ziel gerade das Jahr 1850 ist – genau das Jahr, das man üblicherweise mit dem Ende der Kleinen Eiszeit identifiziert. Dass es während einer Eiszeit, und sei es nur eine kleine, kälter sein dürfte als danach, kann außer Politikern und Journalisten des öffentlich-rechtlichen Rundfunks jeder verstehen und diese Erwärmung zählt zu den natürlichen Klimaphänomenen, nicht zu den menschengemachten. Niemanden muss stören, dass es so etwas wie Ozeanzyklen gibt, zu nennen wären vor allem die Pazifische Dekaden-Oszillation, abgekürzt PDO, die Atlantische Multidekaden-Oszillation, AMO, und die Nordatlantische Oszillation mit der Abkürzung NAO. Es handelt sich um langfristige natürliche Ozeanzyklen, deren Auswirkungen auf die Temperatur- und Klimaentwicklung nicht zu unterschätzen sind und die mit CO₂-Emissionen nichts zu tun haben. Selbstverständlich muss auch niemand die Bedeutung der Sonnenaktivität für das irdische Klima zur Kenntnis nehmen, denn wir haben ja die CO₂-Erklärung, wozu soll man sich dann noch mit empirischer Wissenschaft plagen? Und ohne Frage ist es hilfreich, die Existenz von Warmzeiten in der Vergangenheit einfach zu ignorieren, zu einer Zeit, in der die CO₂-Emissionen vernachlässigt werden konnten, wie zum Beispiel während des Holozänen Thermischen Maximums, einer Zeitspanne von etwa 3000 Jahren, deren Ende 5500 Jahre zurückliegt und in der es wärmer war als heute. Ganz zu schweigen von der Römischen Warmzeit zur Zeit des antiken Rom oder der Mittelalterlichen Wärmeperiode während des Hochmittelalters um das Jahr 1000 n. Chr.. Nichts davon hatte etwas mit CO₂-Emissionen zu tun. Wer sämtliche Klimaveränderungen auf nur eine einzige Ursache schieben will, darf mit Recht als Klimawandelleugner bezeichnet werden, da er die Existenz eines Klimawandels vor dem Jahr 1850 bestreiten muss.

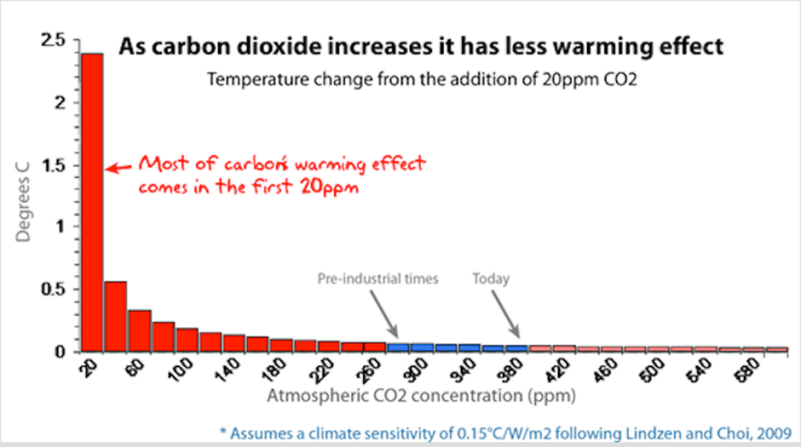

Doch wenigstens weiß man ganz genau, welche Auswirkungen die Steigerung der CO₂-Emissionen auf die globale Durchschnittstemperatur hat, auch wenn diese Temperatur mit leichten Ungewissheiten behaftet ist. Denn zu diesem Zweck bestimmt man die sogenannte Klimasensitivität als „die Veränderung der globalen mittleren Erdoberflächentemperatur im Gleichgewicht, das durch eine Verdoppelung der atmosphärischen CO₂-Konzentration bewirkt wird,“ wie man in einem Bericht des IPCC auf Seite 14 lesen kann. Doch wie seltsam: Diese Sensitivität liegt nach Angaben der obersten Klimabewegten wahrscheinlich in einer Spanne zwischen 1,5 und 4,5 Grad Celsius, niemand weiß es genau. „Aufgrund fehlender Übereinstimmung der Werte aus den beurteilten Anhaltspunkten und Studien kann kein bester Schätzwert für die Gleichgewichts-Klimasensitivität angegeben werden,“ heißt es im gleichen Bericht; man weiß also nicht, welchen Mittelwert man hier sinnvollerweise annehmen muss. So klar sind die Grundlagen der Klimapolitik.

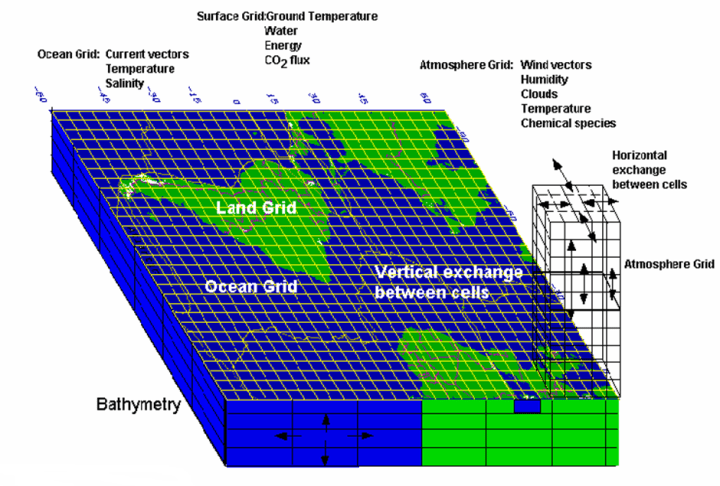

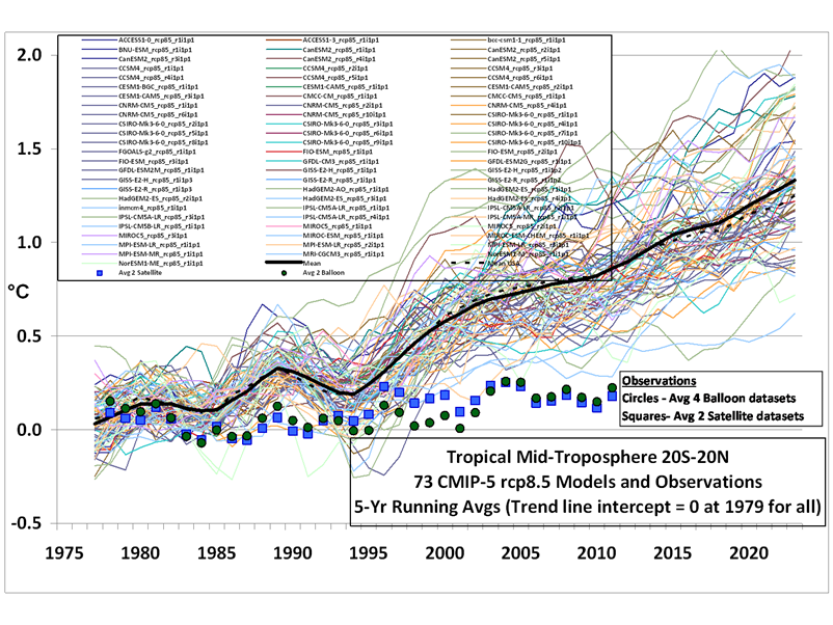

Und wie gelangt man nun zu Aussagen über die zukünftige Klimaentwicklung? Mit einem einfachen Hilfsmittel, das schon im Verlauf der sonderbaren Covid-Pandemie seine Durchschlagskraft bewiesen hat, zumindest im Hinblick auf politische Fehlentscheidungen: Die computerbasierten Modelle sind das Mittel der Wahl. Allerdings soll es auch Forscher wie Bjorn Stevens vom Max-Planck-Institut für Meteorologie geben, der gegenüber dem Spiegel seine Frustration über die Qualität der Vorhersagen der globalen Erwärmung zum Ausdruck brachte: Sie seien so unpräzise wie eh und je. „Unsere Computer sagen nicht einmal mit Sicherheit voraus, ob die Gletscher in den Alpen zu- oder abnehmen werden.“ Das nenne ich Genauigkeit, und Stevens sah das nicht anders – allerdings mit einer weitgeöffneten Hintertür: „Die Genauigkeit der Vorhersagen ist nicht besser geworden, aber unser Vertrauen in sie ist gewachsen.“ Wir wissen zwar nicht mehr als früher, aber dafür glauben wir jetzt umso fester daran.

Wir haben also die Zielgröße der globalen Durchschnittstemperatur, sei es in absoluten Werten oder in Form von Temperaturdifferenzen, die zwangsläufig mit starken Ungenauigkeiten behaftet ist und zudem noch von interessierten Klimawissenschaftlern nachkorrigiert werden muss und kann. Wir haben mit den CO₂-Emissionen eine einzige Ursache für die Klimaerwärmung, die alle anderen jahrtausendealten Klimafaktoren außer Kraft gesetzt hat. Und wir haben Klimamodelle, die zu keinen brauchbaren Voraussagen in der Lage sind, denen man aber unbedingt vertrauen soll. Das sind beruhigende Verhältnisse.

‚Die Ära des Klimatodes‘

Ich will aber nicht kleinlich sein und für einen Moment all das glauben, was man uns immer und immer wieder erzählt, denn schließlich gilt: „The science is settled“. Wenn nun allerdings erhöhte Temperaturen eine so schlimme Wirkung haben und die Lebensqualität so sehr und so negativ beeinflussen, dass man sich im Vorfeld auf Straßen kleben muss, dann sollten auch heute schon temperaturbedingte Unterschiede in den Lebensverhältnissen zu bemerken sein. Insbesondere dürften sich diese Unterschiede in den verschiedenen Lebenserwartungen widerspiegeln. Immerhin schrieb man in der Frankfurter Rundschau schon im letzen Sommer, „dass wir uns bereits in der Ära des Klimatodes und der Klimazerstörung befinden“.

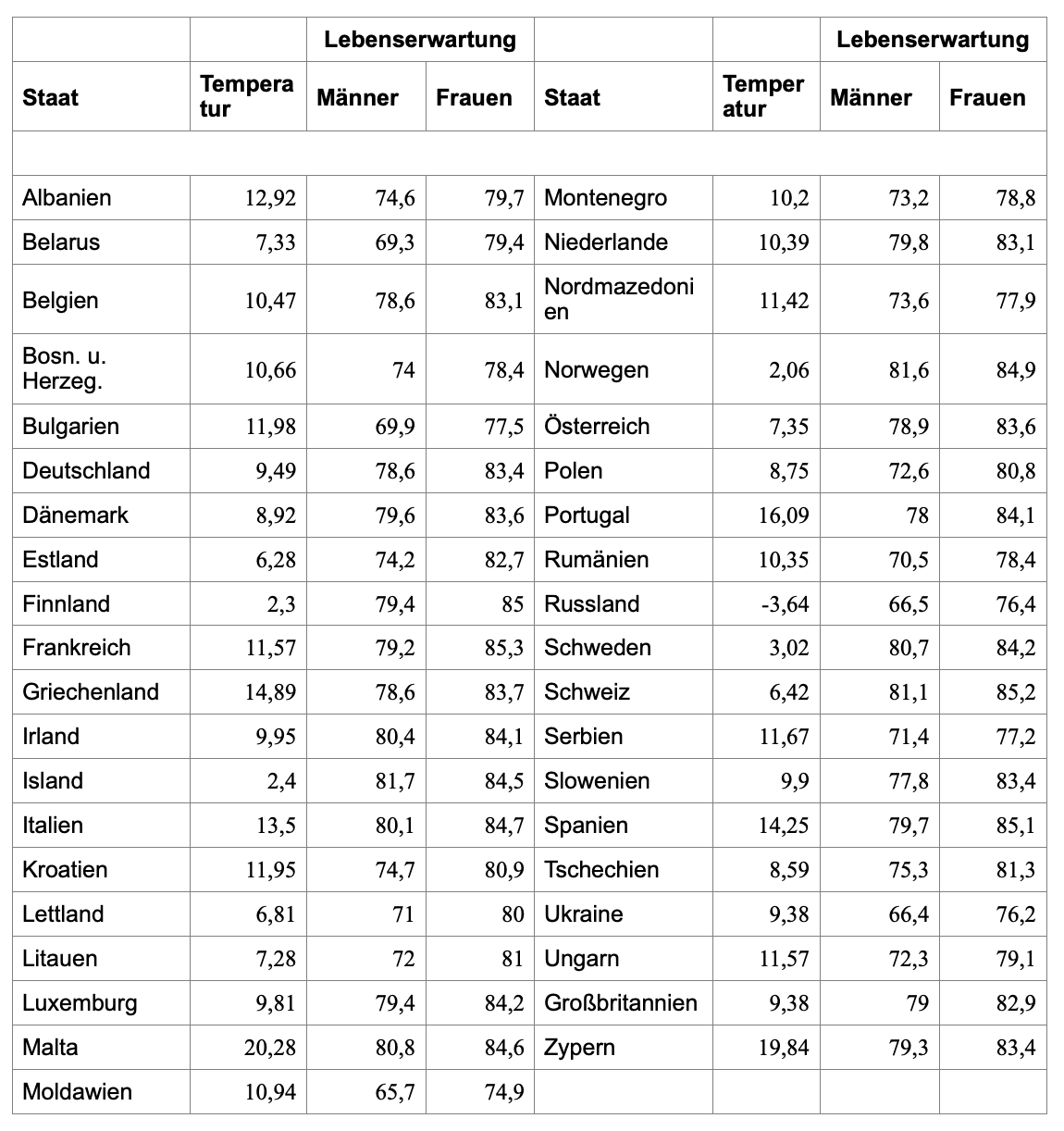

Nun kann man aber, da es offenbar möglich ist, eine globale Durchschnittstemperatur zu bestimmen, sich auch an die nationalen Durchschnittstemperaturen wagen. Eine Auflistung dieser Temperaturen von 2021, erstellt auf der Basis von Daten der Weltbank, kann man leicht finden. Und diesen jährlichen Durchschnittstemperaturen kann man nun die Lebenserwartung der Menschen in den einzelnen Ländern, aufgeteilt nach Frauen und Männern, gegenüberstellen – zu Diversen waren leider keine Daten verfügbar. Die folgende Tabelle zeigt die Werte von 39 europäischen Staaten. Man muss sie nicht im Einzelnen studieren, sie werden anschließend graphisch aufbereitet.

Ich erlaube mir, die Klimaproblematik für kurze Zeit beiseite zu lassen und ein völlig anderes Problem ins Auge zu fassen. Oft wird gesprochen vom Gender Pay Gap, also von der Lohnschere zwischen Männern und Frauen. Wie die Tabelle zeigt, ist aber das Phänomen des Gender Life Gap sehr real, denn in allen 39 Staaten haben Frauen eine deutlich höhere Lebenserwartung als Männer, im Durchschnitt sind es zwischen fünf und sechs Jahren. Wie kann man das dulden? Hier besteht offenbar Handlungsbedarf: Karl Lauterbach, übernehmen Sie!

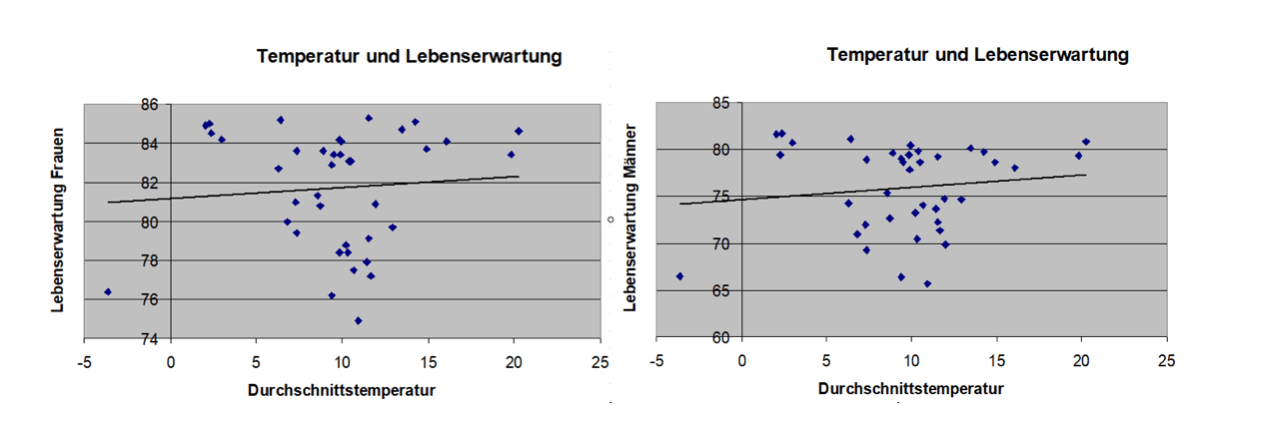

Zurück zum Klima! In den folgenden beiden Abbildungen sind die Daten veranschaulicht, jeder Punkt entspricht einer der Kombinationen aus Temperatur und Lebenserwartung.

Wie man sieht, hält sich die Deutlichkeit des Zusammenhangs in engen Grenzen. Bei Frauen und bei Männern sind hohe Lebenserwartungen sowohl im niedrigen als auch im hohen Temperaturbereich zu verzeichnen, und zwischen 5 Grad und 15 Grad haben wir eine völlig ungeregelte Punktwolke: Es gibt keinen Zusammenhang. Das sieht man noch deutlicher, wenn man die sogenannten Trendgeraden einzeichnet. Ihre Steigungen sind ausgesprochen gering, im Falle der Männer liegt sie bei 0,13, für die Frauen hat man sogar nur 0,04. Man könnte auf die Idee verfallen, dass ein zwar leichter, aber immerhin vorhandener positiver Einfluss der Durchschnittstemperatur auf die Lebenserwartung besteht, doch das wäre nur eine Illusion. Es ist nämlich möglich, mit dem sogenannten Korrelationskoeffizienten ein Maß für die Stärke des Zusammenhangs zu berechnen, und dieser Koeffizient liegt in der Riege der Männer bei 0,13, in der Klasse der Frauen sogar nur bei 0,07. Ein Koeffizient in der Nähe von 1 beschreibt einen sehr starken Zusammenhang, während man bei dem Wert 0 überhaupt keinen Zusammenhang feststellen kann. Hier liegen wir sehr nah bei 0, man darf daher nicht davon ausgehen, dass die Temperatur einen nennenswerten Einfluss auf die Lebenserwartung hat.

Dass bei einer Erhöhung der Durchschnittstemperatur die Lebenserwartung sinken muss, lässt sich also nicht zeigen. Immerhin liegt beispielsweise die maltesische Durchschnittstemperatur mehr als 10 Grad über der deutschen, und auch die maltesischen Lebenserwartungen übersteigen die der Deutschen. Doch man könnte einwenden, dass die Lebenserwartung nicht nur von der Temperatur abhängen kann, sondern auch noch von anderen Faktoren wie zum Beispiel der Qualität des Gesundheitssystems und dem Geisteszustand des Gesundheitsministers. Wie wahr! Genau deshalb ist es nicht übermäßig sinnvoll, sich nur und ausschließlich auf klimatische Faktoren zu konzentrieren, und genau deshalb ist es auch nicht sinnvoll, die klimatischen Betrachtungen selbst mit heiliger Entschlossenheit auf den einen Faktor der CO₂-Emissionen zu fokussieren. Es handelt sich um komplexe Phänomene, die sich nicht monokausal erklären lassen, auch dann nicht, wenn man sich jeden Tag auf eine neue Straße klebt.

Und die Gletscher?

Weitere Einwände kann man schon hören, bevor sie geäußert werden. Wir wissen doch, dass durch die Erhöhung der CO₂-Emissionen extreme Wetterereignisse gefördert werden, was dann wieder seinen Niederschlag in der Lebenserwartung finden muss. Das ist einleuchtend, vor allem dann, wenn man bedenkt, dass Björn Lomborg kürzlich die deutliche Abnahme der Todesopfer bei Extremwetter im Verlauf der letzten einhundert Jahre gezeigt hat: „Um mehr als 90 Prozent sind die Opferzahlen zurückgegangen, obwohl die Weltbevölkerung sich in der gleichen Zeit vervierfacht hat,“ weiß die „Welt“ zu berichten, und die jämmerlichen Versuche der Tagesschau-Faktenfinder, diese Aussage zu entkräften, haben nur dazu beigetragen, den Ruf der Tagesschau noch weiter zu unterminieren.

Und die Gletscher? Was ist mit den Gletschern? Die werden doch ohne Frage stetig kleiner! Das bestreitet kaum jemand, es ist aber nichts Besonderes, wie der Schweizer Geologe Christian Schlüchter herausgefunden hat. „Unsere Gletscher, so Schlüchters zentrale Erkenntnis, waren in den letzten 10 000 Jahren die meiste Zeit kleiner als 2005. Es gab mindestens zwölf Wärmephasen seit der letzten Eiszeit. … Seine Forschungen zeigen zudem: Die Klimaerwärmung ist kein linearer, sondern ein exponentieller Prozess mit vielen Faktoren, über deren Wechselwirkung wir zu wenig wissen.“ Und das sind Erkenntnisse, die auf empirischer Wissenschaft beruhen, nicht auf Modellrechnungen.

Aber die Wissenschaft ist sich doch zu 97 % über den vollständigen Einfluss des Menschen auf den Klimawandel einig! Das wird immer gern behauptet. Barack Obama hat diese Zahl vor zehn Jahren verbreitet und diese Quelle macht die Aussage keineswegs besser. Sie geht zurück auf eine Arbeit des australischen Psychologen John Cook, die darauf beruhte, dass er alle untersuchten wissenschaftlichen Artikel, die sich gar nicht über den menschlichen Einfluss geäußert haben, ignorierte und ansonsten jeden Artikel, der irgendeinen menschlichen Einfluss bejahte, egal in welcher Größenordnung, zu seinen 97 % zählte. Das war Voodoo-Wissenschaft vom Feinsten.

„I don’t want you to be hopeful, I want you to panic,“ sagte einst Greta Thunberg, der lebende Beweis dafür, dass pures Schuleschwänzen, verbunden mit Nichtwissen, einer Karriere nicht im Weg stehen muss, solange man die nötigen Phrasen beherrscht. Und sie hatte recht. In Panik verfallen müssen wir allerdings nicht, weil uns der Boden unter den Füßen verbrennen wird, sondern weil eine modellbasierte Ideologie sich zur alles beherrschenden Religion aufschwingen konnte, die katastrophale Auswirkungen auf das Leben der Menschen und auf ihren in der Regel bescheidenen Wohlstand hat. Und „How dare you?!“ rief sie den Politikern zu. Auch diese Frage ist berechtigt, aber nicht etwa, weil man ihr, wie sie sagte, ihre Träume und ihre Kindheit gestohlen hat; das haben sie und ihre Eltern schon ganz alleine geschafft. „Wie könnt ihr es wagen?“, muss man alle die fragen, die sich anmaßen, über unser Leben, über unsere Lebensweise zu entscheiden, und alle, die seit Jahr und Tag nichts anderes tun, als ihre Propaganda zum Untergang der Welt zu verbreiten. Ich darf dieser Propaganda einen Ausspruch des bereits angeführten Geologen Christian Schlüter entgegen halten: „Die Erfindung des Teufels war die grandioseste Erfindung, die die Menschheit je gemacht hat. Man kann viel Geld verdienen, wenn man ihn an die Wand malt.“ Es wird Zeit, die Wände wieder von diesen Bemalungen zu befreien.

Der Beitrag erschien zuerst bei Reitschuster.de hier