Messung der globalen Temperatur – Satelliten oder Thermometer?

Zuverlässig sind nur die Satellitendaten ab 1979 und da war das wärmste Jahr das Jahr 1998. Allerdings geben auch diese Rätsel auf, da 1998 aufgrund eine EL-Nino-Sprunges zustande gekommen war, aber danach blieben die Temperaturen auf einem etwas höheren Niveau als im Zeitraum davor von 1979 bis 1997.

2015 das weltweit wärmste Jahr, ich frage immer, ja wie warm war das Jahr denn, gebt mir mal eine Gradzahl an, und wie warm war das zweitwärmste davor. Bei jedem Weltrekord in jeder Sportdisziplin muss die Größe doch gemeldet werden. – Josef Kowatsch

von Dr. Roy Spencer

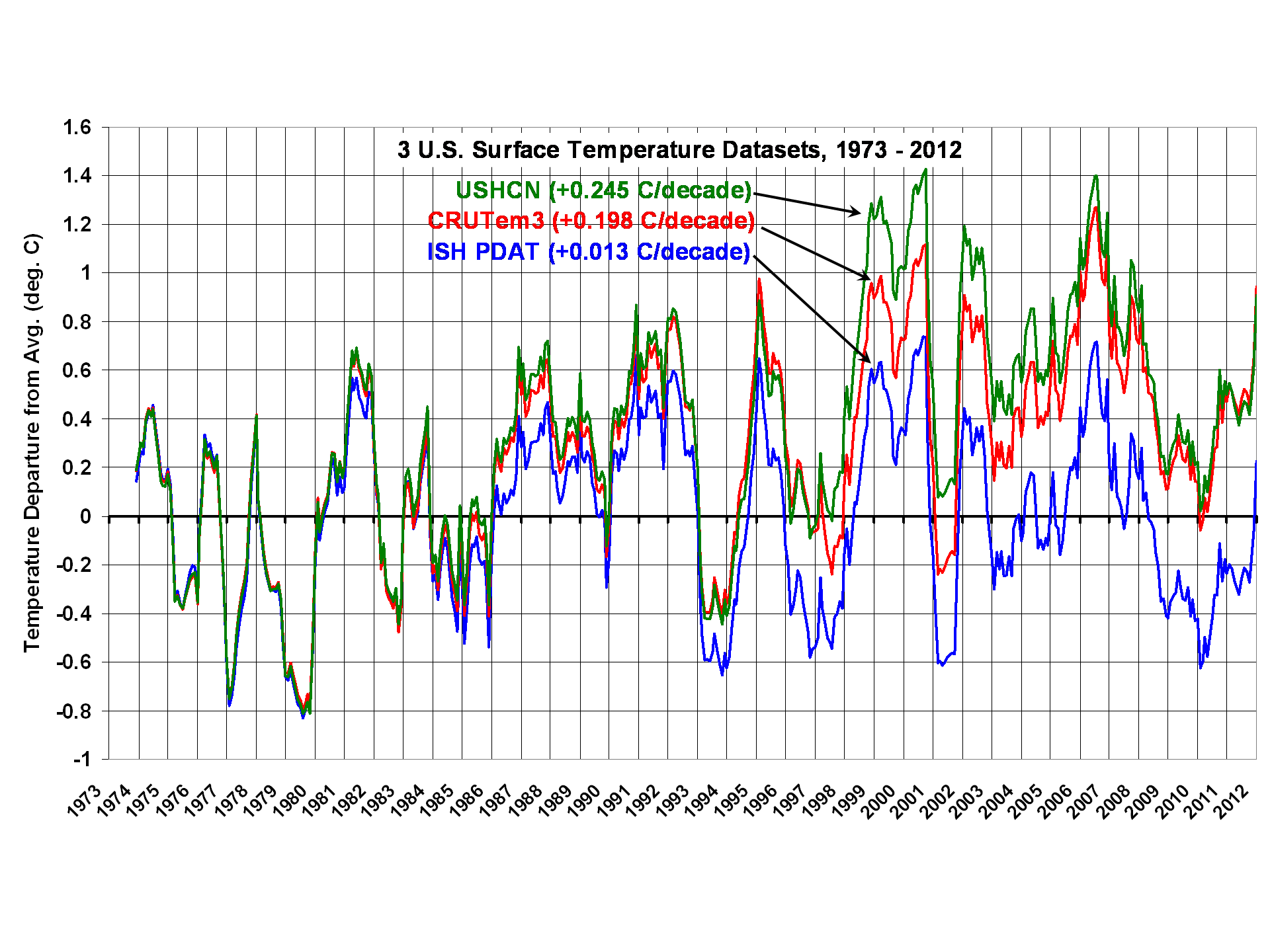

Die offiziellen Zahlen der globalen Temperatur liegen jetzt vor, und NOAA und NASA haben beschlossen, dass 2015 das wärmste Jahr jemals war. Hauptsächlich auf der Grundlage bodenständiger Thermometer ignoriert die offizielle Verlautbarung die anderen beiden primären Methoden, die globale Lufttemperatur zu messen, nämlich Satelliten und Radiosonden.

Die Tatsache, dass jene ignorierten Datensätze seit etwa 18 Jahren nur eine geringe oder gar keine Erwärmung zeigen, erfordert eine genauere Beschreibung der primären Differenzen zwischen diesen drei Messverfahren.

Drei Methoden, um die globalen Temperaturen zu messen

Die primären Methoden zum Monitoring der mittleren globalen Lufttemperatur sind bodenständige Thermometer (seit Ende des 19. Jahrhunderts), Wetterballone (seit den fünfziger Jahren) und Satellitenmessungen der Mikrowellen-Emissionen (seit 1979). Andere Technologien wie etwa auf GPS basierende Verfahren sind hinsichtlich ihrer Aufzeichnungsperiode begrenzt und bzgl. ihrer Genauigkeit noch nicht allgemein akzeptiert.

Während die Thermometer die Temperatur nahe der Erdoberfläche messen, messen Satelliten und Radiosonden die mittlere Temperatur einer dickeren Schicht der unteren Atmosphäre. Auf der Grundlage unseres Verständnisses der atmosphärischen Abläufe wird vermutet, dass die Temperaturen der unteren Schicht sich irgendwie schneller erwärmen (und abkühlen) als die bodennahen Temperaturen. Mit anderen Worten, Variationen der globalen mittleren Temperatur werden vermutlich mit zunehmender Höhe verstärkt, sagen wir mal in den untersten 10 km der Atmosphäre. Tatsächlich wird dies auch beobachtet während warmer El-Nino-Jahre (2015) und kühler La-Nina-Jahre.

Die Satelliten-Aufzeichnungen umfassen den kürzesten Zeitraum, und da der größte Teil der Erwärmung sowieso erst seit den siebziger Jahren erfolgt war, reden wir häufig über Temperaturtrends seit 1979. Damit können wir alle drei Datensätze über einen allgemeinen Zeitraum vergleichen.

Temperaturen der Tiefsee, auf die ich nicht detailliert eingehen möchte, sind um einen so geringen Betrag gestiegen – hundertstel Grad – dass man darüber streiten kann, ob sie für eine allgemeine Heranziehung genau genug sind. Wassertemperaturen an der Oberfläche, die ebenfalls während der letzten Jahrzehnte eine moderate Erwärmung zeigen, involvieren ein ganz neues Bündel von Problemen. Das reicht von räumlich weit auseinanderliegenden und sporadischen Temperaturmessungen mit Eimern von vor vielen Jahren über neuere Daten aus dem in Schiffe einströmenden Kühlwasser, Bojen bis zu Infrarot-Satellitenmessungen seit Anfang der achtziger Jahre.

Wie viel Erwärmung?

Seit 1979 ist allgemein anerkannt, dass die Satelliten und Radiosonden einen um 50% geringeren Erwärmungstrend messen als die Daten der bodenständigen Thermometer. Die Theorie hatte für höhere Luftschichten einen um 30 bis 50% stärkeren Erwärmungstrend prophezeit als am Boden.

Das ist eine substantielle Unstimmigkeit.

Warum die Unstimmigkeit?

Dafür gibt es mehrere Möglichkeiten:

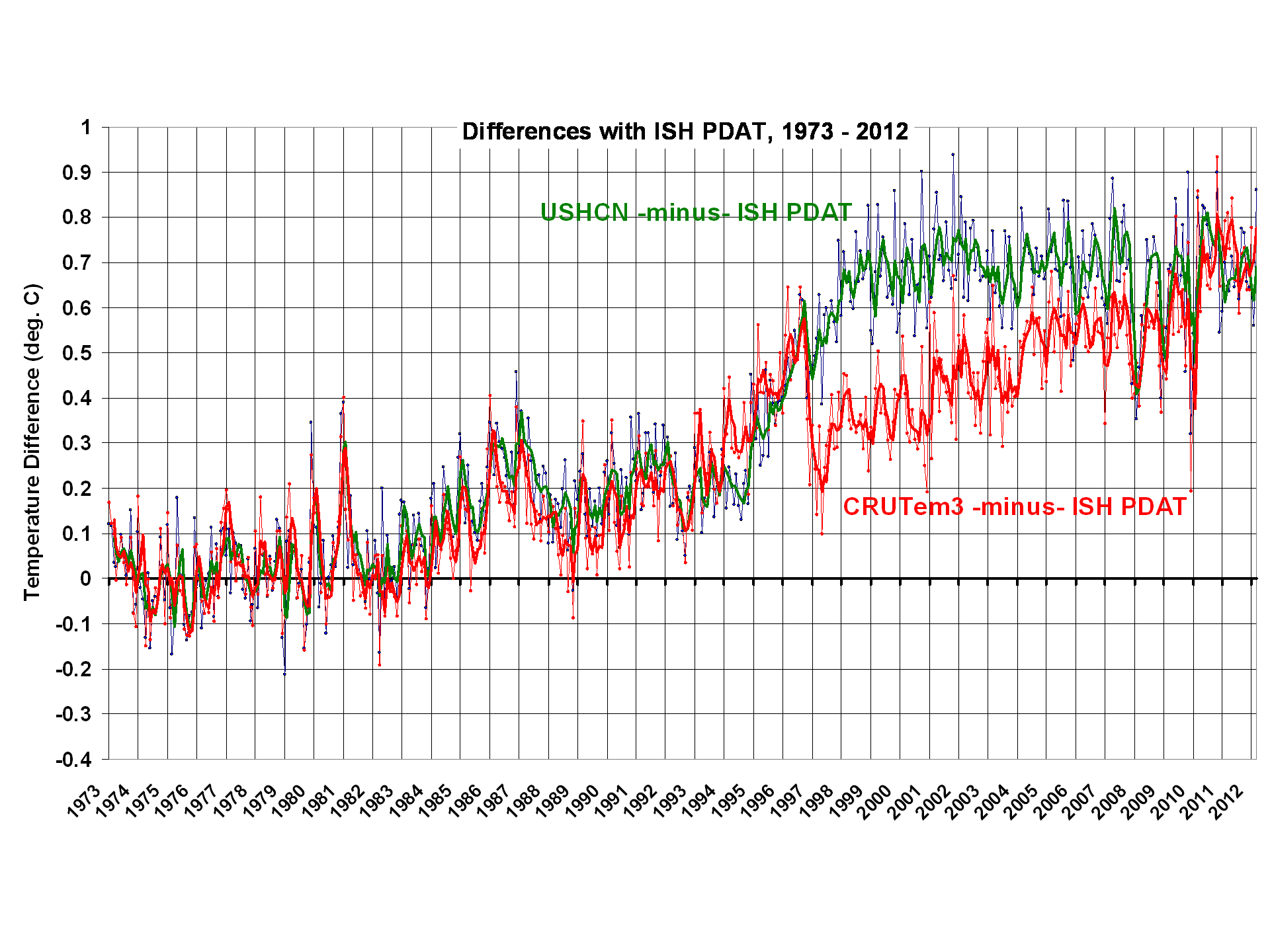

1) Die Analysen der Daten bodenständiger Thermometer überschätzen den wahren Temperaturtrend ein wenig.

2) Satelliten und Radiosonden unterschätzen den wahren Temperaturtrend etwas.

3) Alle Daten sind im Wesentlichen korrekt und sagen uns irgendetwas Neues darüber, wie das Klimasystem auf eine langfristige Erwärmung reagiert.

Zuerst wollen wir auf die fundamentale Grundlage für jede Messung schauen.

Alle Temperaturmessungen sind „indirekt“

Grob gesagt ist „Temperatur“ eine Maßzahl der kinetischen Energie der Bewegung von Molekülen in Luft.

Unglücklicherweise gibt es keine einfache Möglichkeit, diese kinetische Bewegungsenergie direkt zu messen.

Stattdessen waren vor vielen Jahren Quecksilber- oder Alkohol-Thermometer im allgemeinen Gebrauch, in denen die thermische Ausdehnung einer Flüssigkeitssäule in Abhängigkeit von der Temperatur mittels Augenschein geschätzt worden ist. Diese Messungen wurden inzwischen ersetzt durch Thermistoren, welche den Widerstand elektrischen Stromes messen, der ebenfalls temperaturabhängig ist.

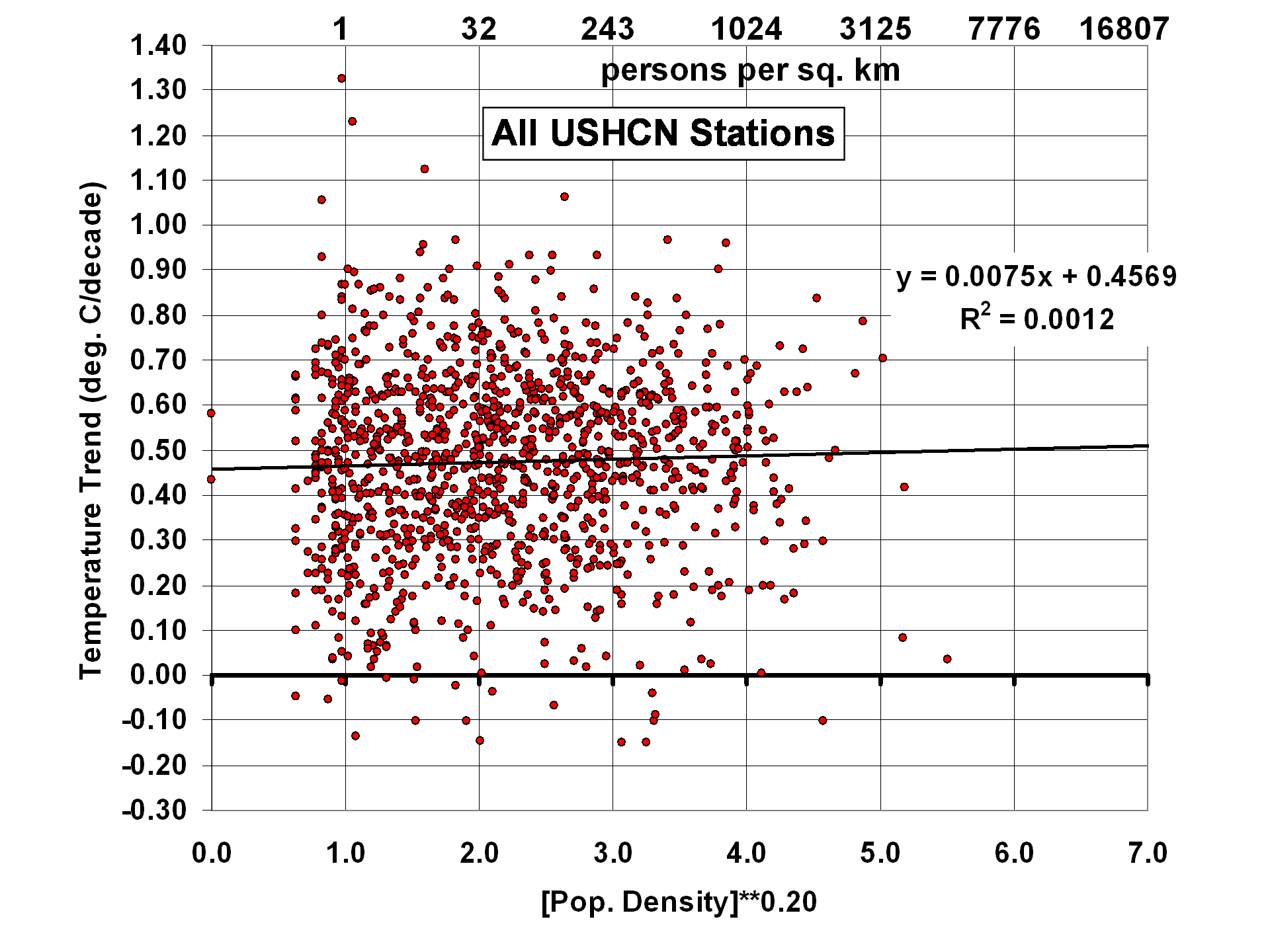

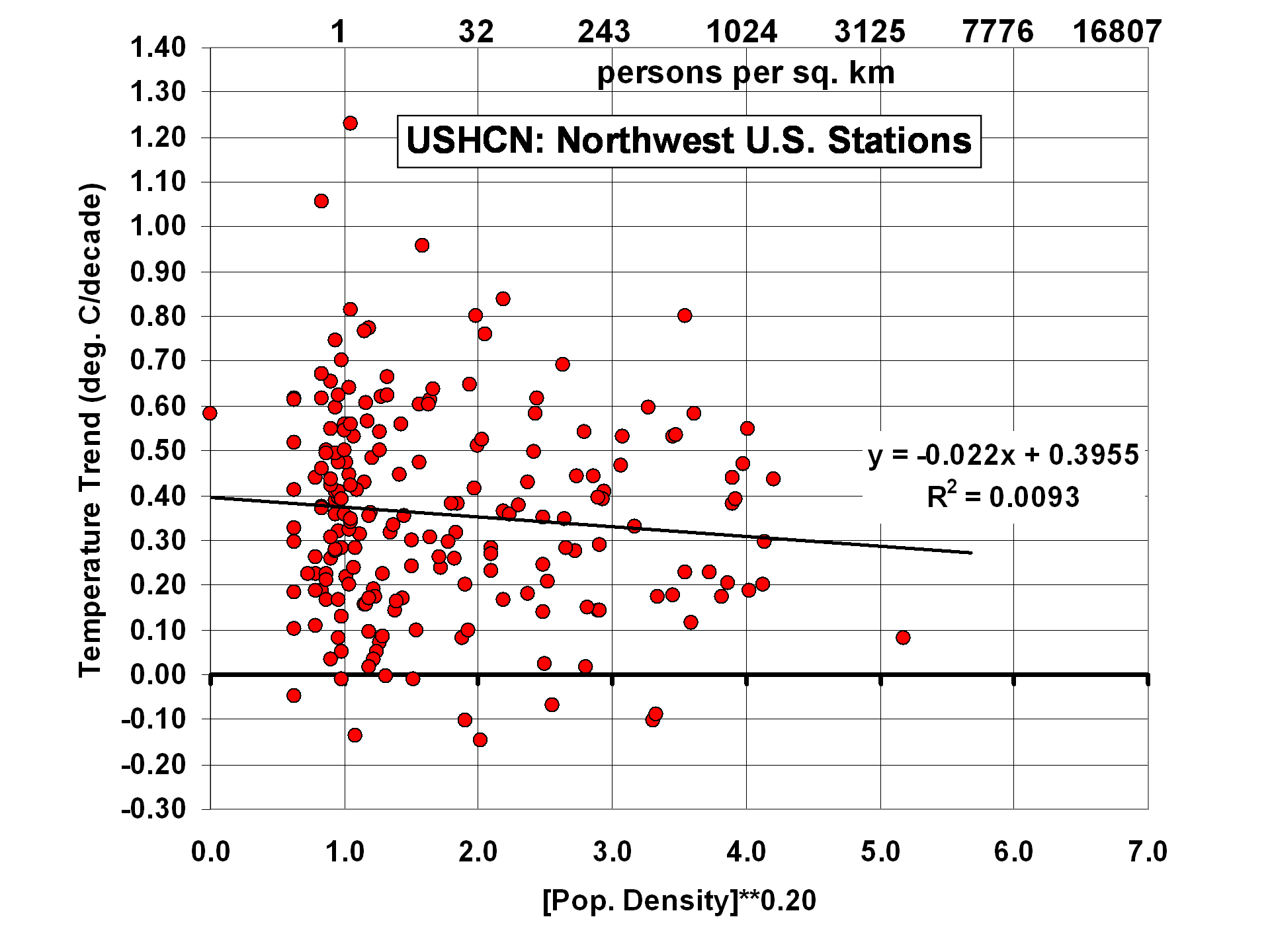

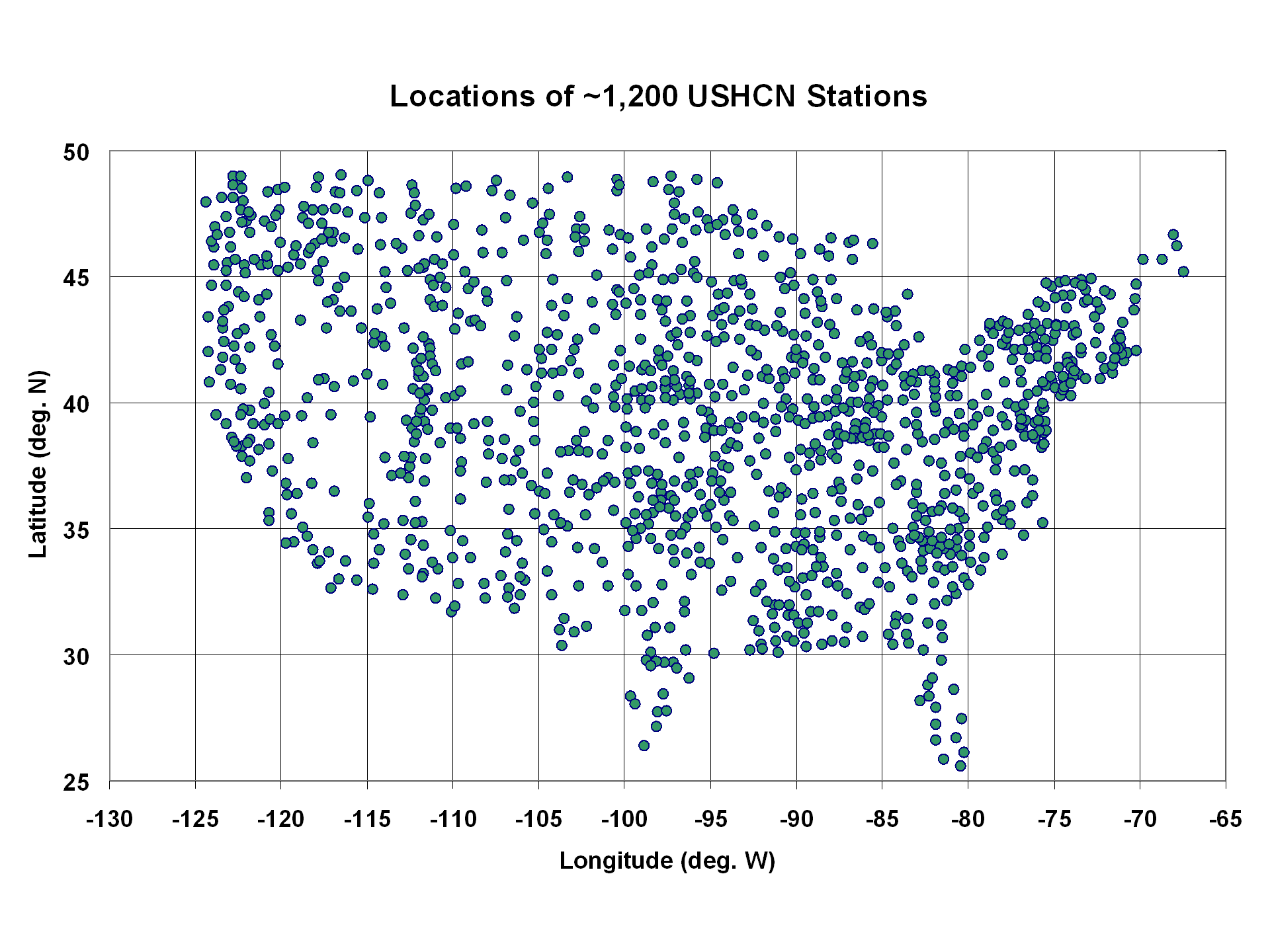

Diese Messungen sind nur gültig für die unmittelbar das Thermometer umgebende Luft, und wie wir alle wissen, können lokale Wärmequellen (eine Mauer, Bodenversiegelung, Air Condition, Heizungsausrüstung usw.) diese Thermometermessungen beeinflussen und tun dies auch. Schon sehr oft wurde gezeigt, dass städtische Standorte höhere Temperaturen aufweisen als ländliche Standorte, und solche Spuren-Wärmeeinflüsse sind schwierig vollständig zu eliminieren, haben wir doch die Neigung, Thermometer dort aufzustellen, wo die Menschen wohnen.

Radiosonden messen ebenfalls mit einem Thermistor, welches normalerweise mit einem separaten Thermometer unmittelbar vor dem Auflassen des Ballons verglichen wird. Wenn der Ballon den Thermistor aufwärts durch die Atmosphäre trägt, ist es unabhängig von bodenbasierten Quellen der Beeinflussung, aber es gibt immer verschiedene Fehler infolge Sonnenbestrahlung und Infrarot-Abkühlung, welche durch das Design der Radiosonde jedoch minimiert sind. Die Anzahl der Radiosonden ist wesentlich geringer, und allgemein werden Hunderte Punktmessungen auf der ganzen Welt jeden Tag durchgeführt – an Stelle der vielen Tausend Messungen, die Thermometer vornehmen können.

Satelliten-Mikrowellen-Radiometer bilden die geringste Anzahl, nur ein Dutzend oder so, aber jedes Einzelne wird von seinem eigenen Satelliten transportiert, um kontinuierlich nahezu die gesamte Erde zu vermessen – jeden Tag. Jede individuelle Messung repräsentiert die mittlere Temperatur in einem Luftvolumen, das etwa 50 km Durchmesser aufweist und 10 km hoch reicht, was sich zu etwa 25.000 km³ Luft ergibt. Etwa 20 dieser Messungen werden jede Sekunde durchgeführt, da der Satellit wandert und das Instrument die Erde scannt.

Die Satellitenmessung selbst ist „radiativ“: Das Niveau der Mikrowellen-Emission von Sauerstoff in der Atmosphäre wird gemessen und verglichen mit der Emission eines Warm-Kalibrierungs-Zieles auf dem Satelliten (dessen Temperatur überwacht wird mittels vieler hoch genauer Platin-Widerstands-Thermometer), und eine Kalt-Kalibrierung mit der kosmischen Hintergrundstrahlung, die mit etwa 3 K angesetzt wird (nahe des Absoluten Nullpunktes). Eine weniger aufwändige (infrarote) Strahlungstemperatur wird mit einem Fieberthermometer im Ohr durchgeführt.

Welches System ist also das Bessere?

Die Satelliten haben den Vorteil, dass sie nahezu jeden Tag die gesamte Erde vermessen mit den gleichen Instrumenten, die dann untereinander abgeglichen werden. Aber da es zwischen diesen Instrumenten nur sehr geringe Differenzen gibt, die sich mit der Zeit geringfügig ändern können, müssen Adjustierungen vorgenommen werden.

Thermometer haben den Vorteil, in viel größerer Zahl vertreten zu sein, aber mit potentiell großen langfristigen Spuren-Erwärmungseffekten, die abhängig sind von der lokalen Umgebung eines jeden Thermometers, welche sich wiederum verändert durch das Hinzufügen menschlicher Objekte und Strukturen.

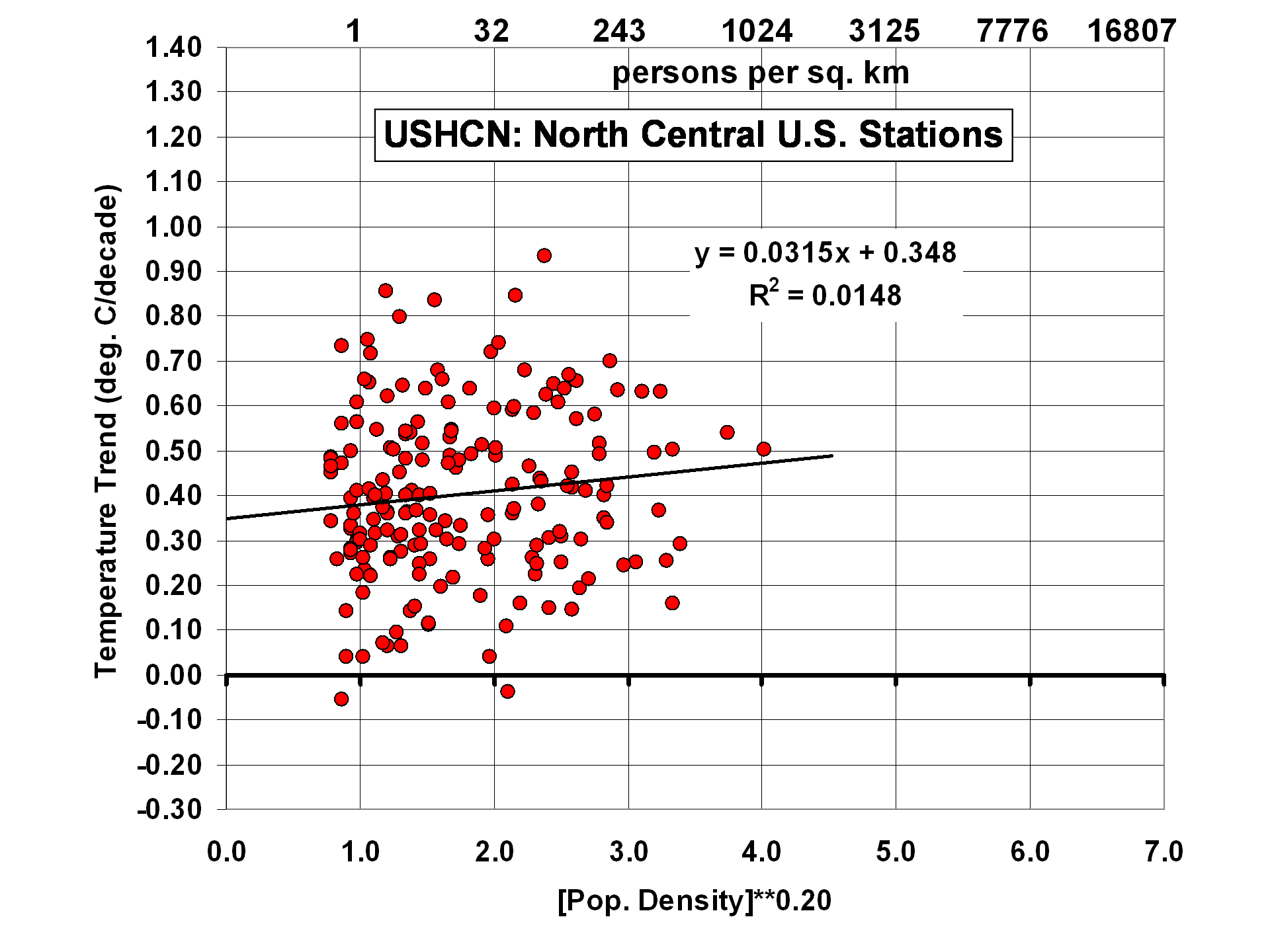

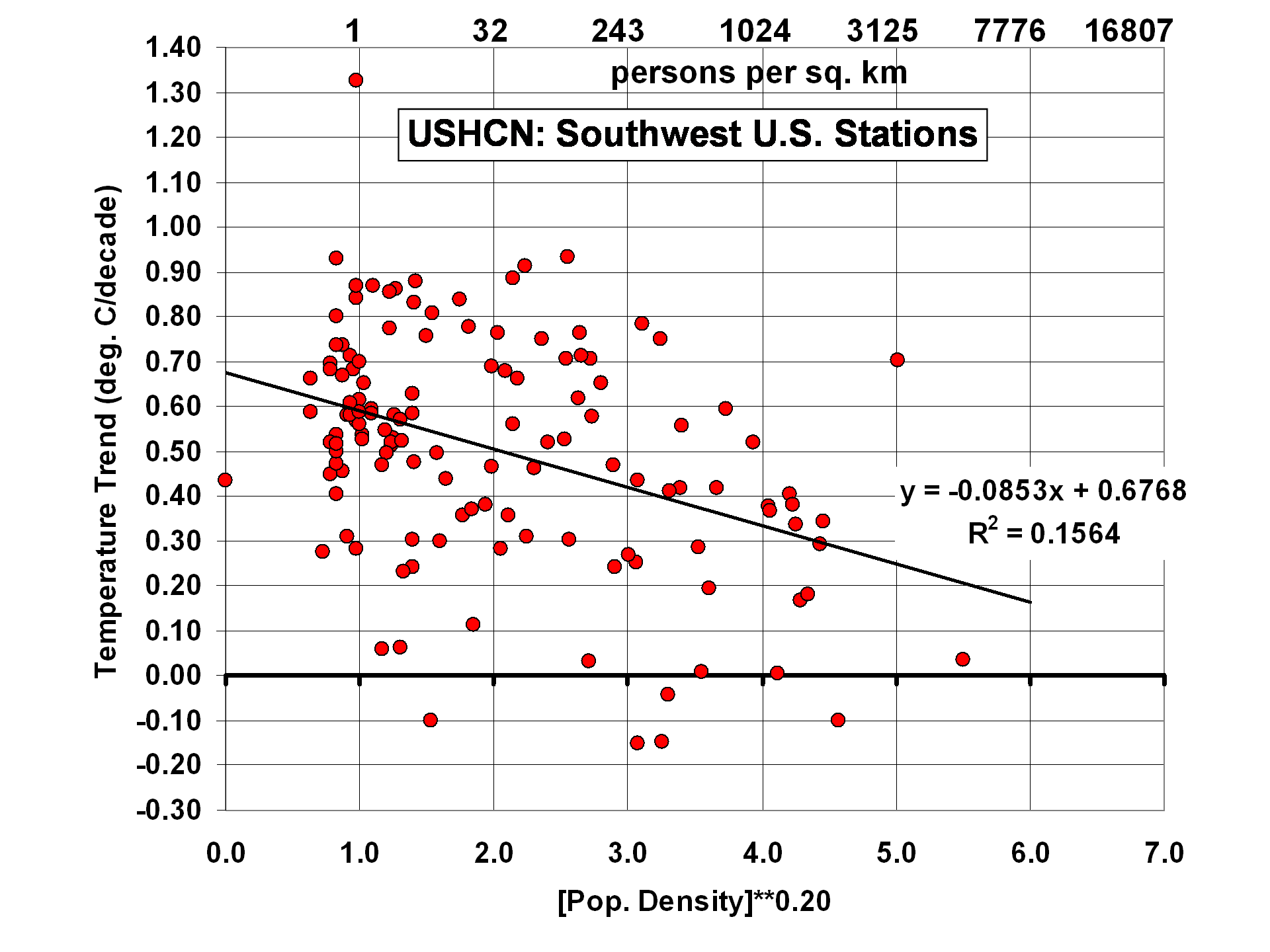

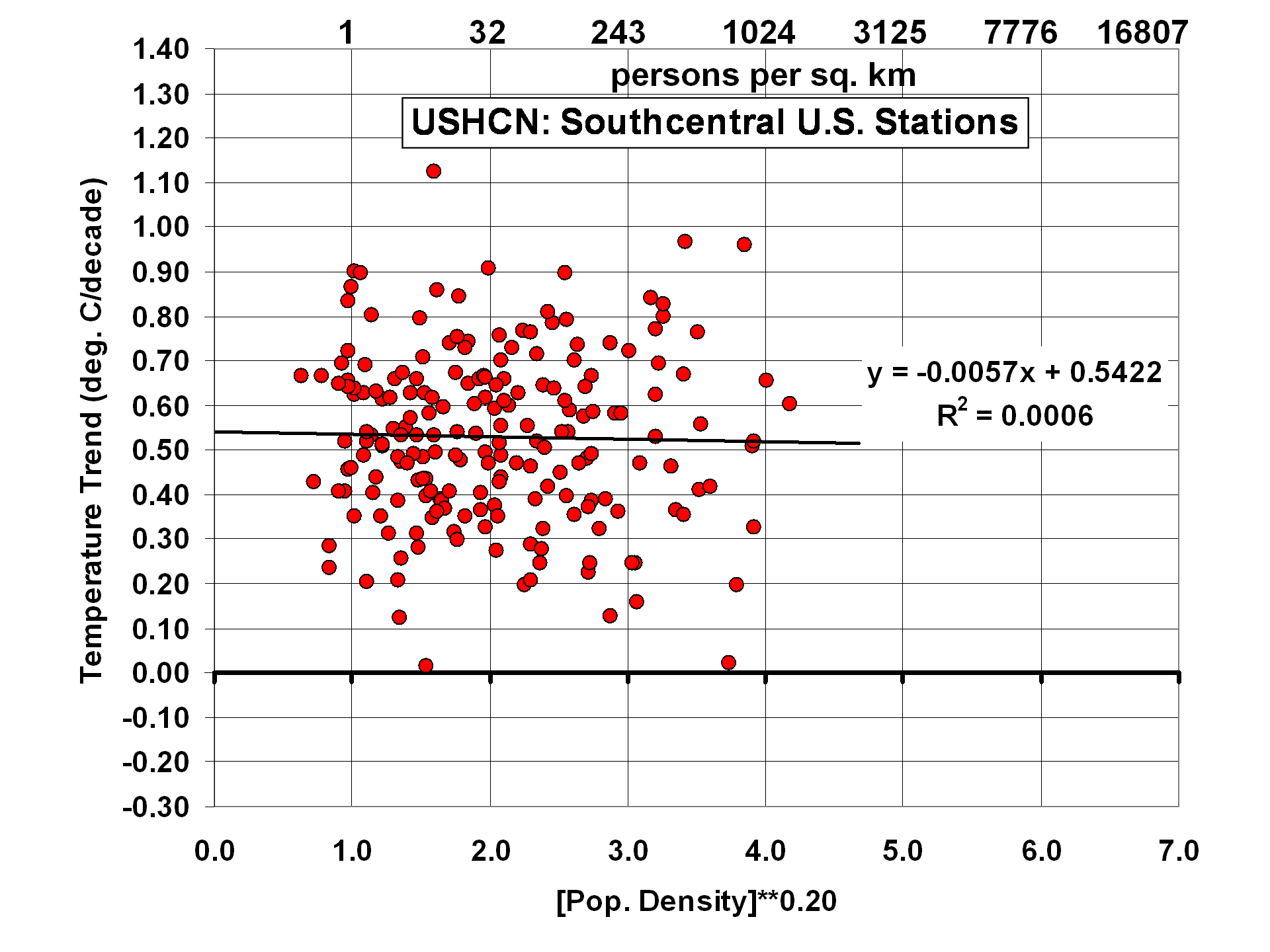

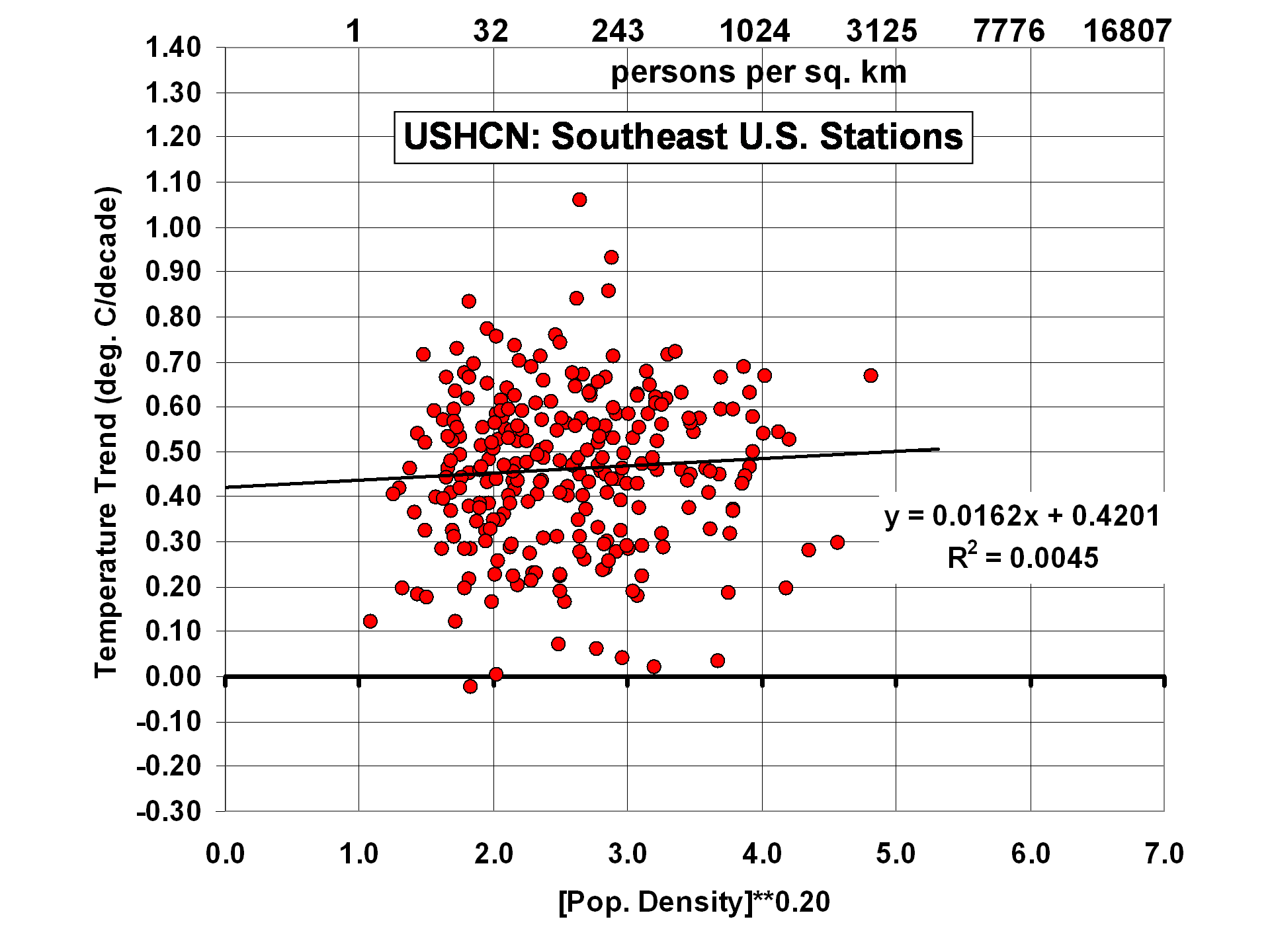

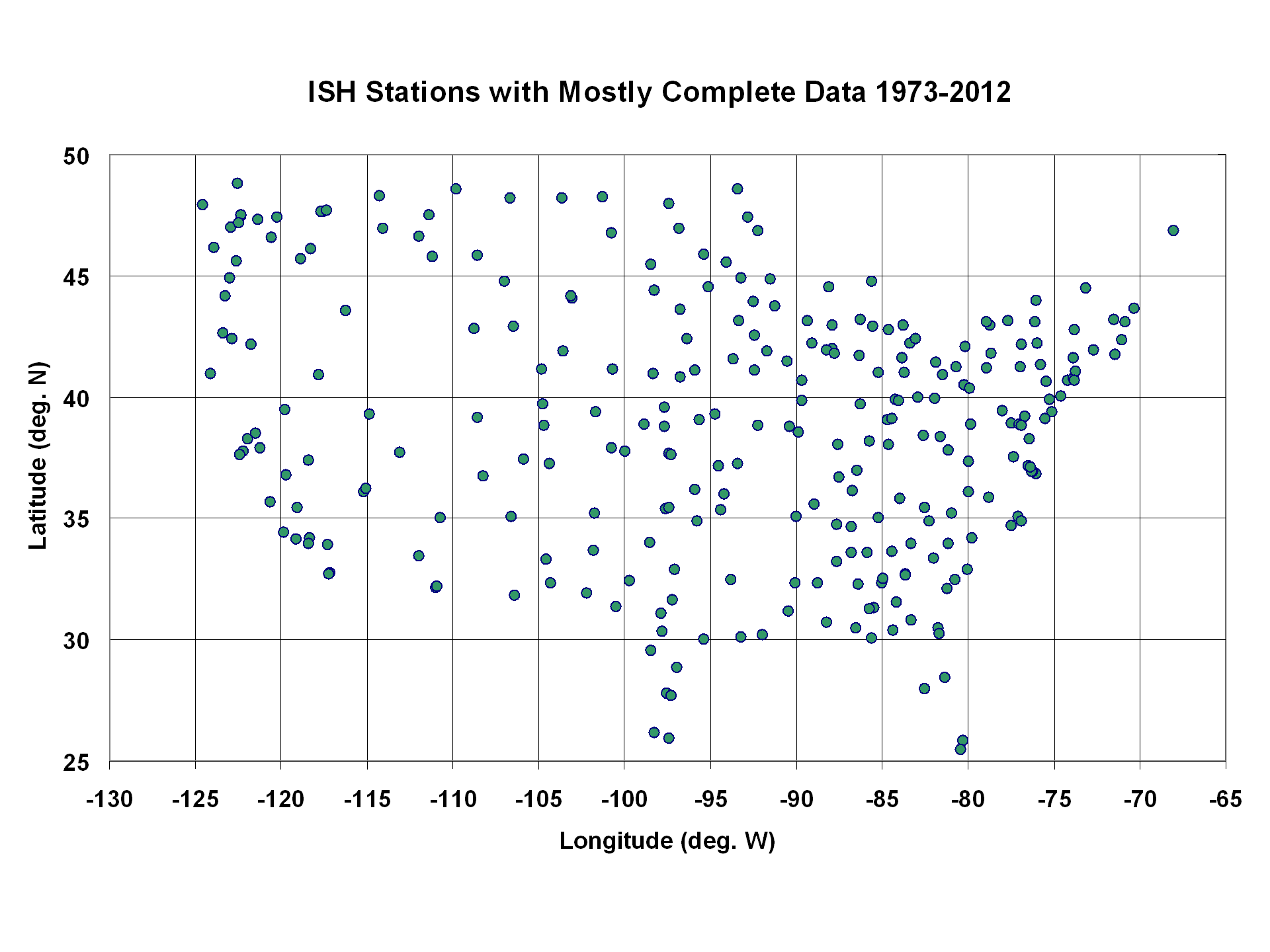

Nahezu alle Thermometermessungen erfordern Adjustierungen irgendwelcher Art, einfach weil es mit Ausnahme einiger weniger Messstellen keine einzige Messstelle gab, die über 30 Jahre lang an der gleichen Stelle ohne Veränderung der Umgebung gemessen hat. Als derartig seltene Thermometer-Standorte jüngst in einer Studie aus den USA ermittelt wurden, fand man im Vergleich mit den offiziellen US-Erwärmungstrends, dass letztere diese Trends um fast 60% übertrieben haben. Folglich scheinen die derzeitigen offiziellen NOAA-Adjustierungs-Verfahren die guten Daten an die schlechten Daten anzupassen anstatt umgekehrt. Ob es derartige Probleme auch in anderen Ländern gibt, bleibt abzuwarten.

Änderungen des Designs von Radiosonden und deren Software gab es auch über die Jahre, was einige Adjustierungen der Rohdaten erfordert.

Für Satelliten gilt: die orbitale Abnahme [decay] der Satelliten erfordert eine Adjustierung der Temperaturen der „unteren Troposphäre“ (LT), welche gut verstanden und ziemlich genau ist. Sie hängt lediglich ab von der Geometrie und der mittleren Temperaturabnahme mit der Höhe. Aber die orbitale Abnahme bringt die Satelliten dazu, dass sie langsam treiben zu der Tageszeit, in der sie messen. Diese dem „täglichen Abtreiben“ geschuldete Adjustierung ist weniger sicher. Bedeutsam: Sehr unterschiedliche Verfahren für diese Adjustierung haben zu fast identischen Ergebnissen geführt zwischen den von UAH (University of Alabama in Huntsville) und RSS (Remote Sensing Systems, Santa Rosa, California) erzeugten Satellitendaten.

Die Tatsache, dass die Satelliten und Radiosonden – zwei sehr unterschiedliche Messsysteme – dazu tendieren übereinzustimmen, gibt uns große Zuversicht hinsichtlich ihrer Ergebnisse, dass die Erwärmung deutlich geringer ausgefallen ist als von den Klimamodellen prophezeit. Aber selbst die Thermometer zeigen weniger Erwärmung als die Modelle, allerdings ist die Diskrepanz mit den Klimamodellen geringer.

Und das ist möglicherweise das Wichtigste: Egal welches Verfahren zum Monitoring der Temperatur wir anwenden – die Klimamodelle, auf deren Ergebnissen die Politik bzgl. der globalen Erwärmung basiert, zeigen im Mittel eine viel stärkere Erwärmung als sämtliche unsere Temperatur-Messsysteme.

Ich glaube, dass es zu einer „globalen Erwärmung“ gekommen ist, aber 1. ist diese schwächer als erwartet, wie aus unabhängigen Messungen von Satelliten und Radiosonden hervorgeht; 2. ist sie überschätzt worden durch schlecht adjustierte Messungen bodenständiger Thermometer; 3. hat die Erwärmung eine wesentliche natürliche Komponente und 4. ist sie für das Leben auf der Erde viel eher vorteilhaft als schädlich.

Link: http://www.cfact.org/2016/01/26/measuring-global-temperatures-satellites-or-thermometers/

Übersetzt von Chris Frey EIKE

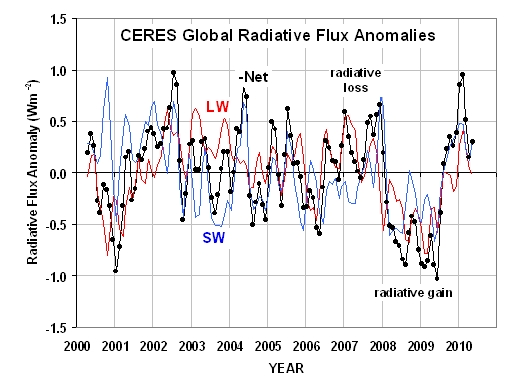

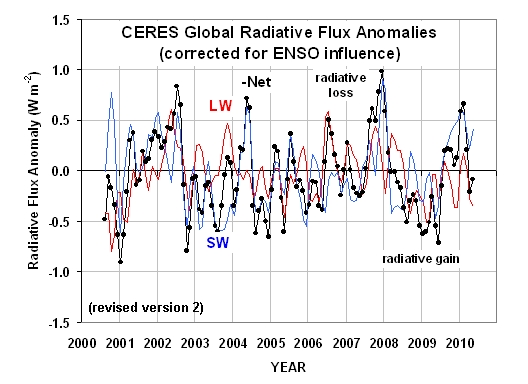

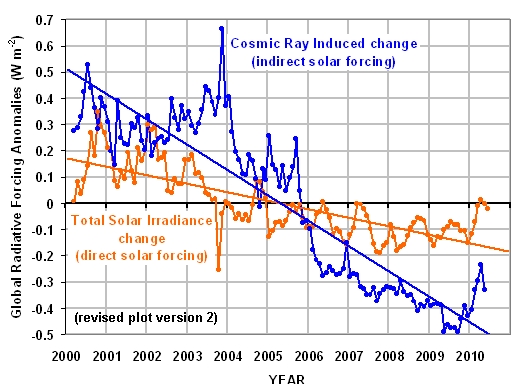

welche die Variationen des im globalen Mittel reflektierten Sonnenlichts (SW), die emittierte infrarote Strahlung (LW) und Net [?] zeigt (welches die geschätzten Ungleichgewichte der gesamten absorbierten Energie durch das Klimasystem ist, nach der Anpassung der Variationen der gesamten Solarstrahlung TSI). Man beachte, dass ich die Variationen im Negativen von Net geplottet habe, was angenähert gleich ist mit Variationen von (LW + SW).

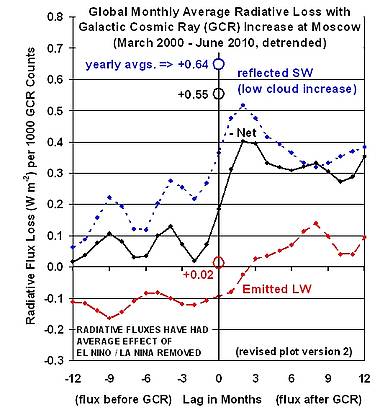

welche die Variationen des im globalen Mittel reflektierten Sonnenlichts (SW), die emittierte infrarote Strahlung (LW) und Net [?] zeigt (welches die geschätzten Ungleichgewichte der gesamten absorbierten Energie durch das Klimasystem ist, nach der Anpassung der Variationen der gesamten Solarstrahlung TSI). Man beachte, dass ich die Variationen im Negativen von Net geplottet habe, was angenähert gleich ist mit Variationen von (LW + SW). Schließlich führte ich Regressionen an verschiedenen zeitlichen Verschiebungen zwischen den GCR-Reihen, den LW, SW und Net-Strahlungsflüssen durch. Die Ergebnisse folgen hier:

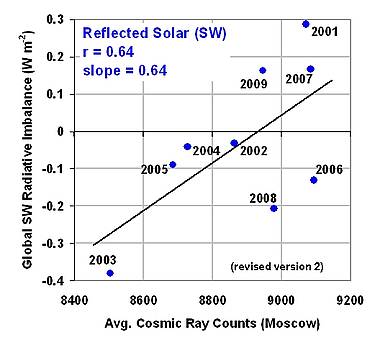

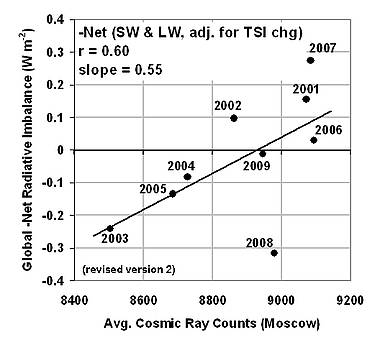

Schließlich führte ich Regressionen an verschiedenen zeitlichen Verschiebungen zwischen den GCR-Reihen, den LW, SW und Net-Strahlungsflüssen durch. Die Ergebnisse folgen hier:

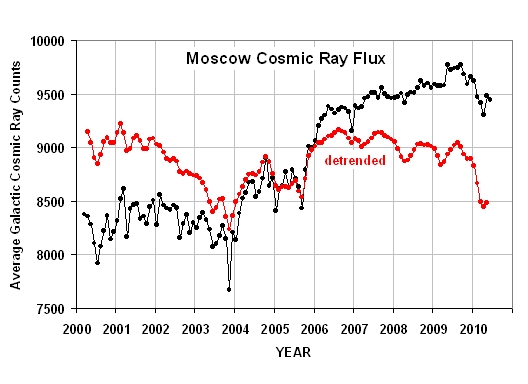

Ebenso ist der geschätzte Antrieb durch kosmische Strahlung dargestellt, wie er aus Änderungen von Monat zu Monat des originalen Datensatzes der Moskauer Serie resultiert, berechnet durch Multiplikation dieser monatlichen Änderungen in Höhe von 0,55 Watt pro Quadratmeter pro 1000 Zählern der Änderung der kosmischen Strahlung.

Ebenso ist der geschätzte Antrieb durch kosmische Strahlung dargestellt, wie er aus Änderungen von Monat zu Monat des originalen Datensatzes der Moskauer Serie resultiert, berechnet durch Multiplikation dieser monatlichen Änderungen in Höhe von 0,55 Watt pro Quadratmeter pro 1000 Zählern der Änderung der kosmischen Strahlung.