Die Computermodelle des IPCC (Intergovernmental Panel on Climate Change, Weltklimarat) sind nach wie vor von sehr begrenztem Wert, die resultierenden Vorhersagen so gut wie unbrauchbar – das Weltklima ist einfach zu kompliziert. So reichen die Prognosen des IPCC für die CO2-Klimasensitivität (Temperaturanstieg bei Verdoppelung des CO2) von 1,6 bis 5,6 Grad C, aber nur mit einer Wahrscheinlichkeit von 66%. Vor diesem unbefriedigenden Hintergrund haben, wie überall in der Physik, Messungen das letzte Wort. Und die gibt es inzwischen schon seit längerer Zeit. Ist es da nicht besser, man orientiert sich an konkreten Messergebnissen anstelle von fragwürdigen und in aller Regel übertriebenen Alarm-Prognosen?

Die Temperatur-Werte, ermittelt von vielen tausend Stationen, enthalten allerdings auch Fehlerquellen wie unregelmäßig verteilte Messstationen, welche Stationen ausgewählt werden, Messungenauigkeiten sowie die meist intransparenten Adjustierungen und Homogenisierungen der Messdaten. Über den Ozeanen und vor allem auf der Südhalbkugel gibt es weniger Messstationen. Je älter die Temperaturdaten, desto größer sind die Ungenauigkeiten. Belege für „gezielte“ Anpassungen gibt es ebenfalls. Nachfolgende HadCRUT4-Bodendaten werden auch vom IPCC verwendet – schon deshalb ist eine „Untertreibung“ eher unwahrscheinlich.

Unschwer ist zu erkennen, dass den Temperaturverläufen Periodizitäten überlagert sind, für die es teilweise gute Beschreibungsansätze gibt (Ozeanische Oszillationen, El Niño, Nord-Süd-Klimaschaukel, Solarzyklen verstärkt durch kosmische Strahlung und Wolkenbildung), die aber in den Klimamodellen bisher kaum Berücksichtigung finden. Auch ist bis heute nicht sicher bekannt, welche natürlichen Vorgänge die historischen Klimaschwankungen verursacht haben – wie damals die Mittelalterlichen Warmzeit, als u.a. die Wikinger Grönland besiedelten, und die vorausgegangenen Warmzeiten davor.

Die Ozeane stellen einen riesigen Wärmespeicher dar, mehr als 100mal größer als die gesamte Atmosphäre. Insbesondere in den tieferen Ozeanbereichen folgen die Meerestemperaturen einer Erderwärmung nur sehr langsam, von bis etwa 1000 Jahren Verzögerung ist die Rede. Auch wird über den Ozeanen weniger Temperaturanstieg gemessen als über Land. Zusätzlich sind die Temperaturanstiege auf der Nordhalbkugel größer als auf der Südhalbkugel (Klimaschaukel?).

Zusätzliche Einflüsse wie die Wärmeinseleffekte durch zunehmende Bebauung und möglicherweise der Luftverkehr (Eintrag von Aerosolen in die Stratosphäre) bis hin zur wachsenden Energiefreisetzung von immer mehr Menschen spielen ebenfalls eine Rolle. Worauf hier nicht näher eingegangen wird, weil der Einfluss von natürlichen Ursachen auf den Temperaturverlauf zwar oftmals plausibel ist, aber aus heutiger Sicht dennoch meist spekulativ. Die Vorgaben der 1,5 Grad bzw. 2 Grad-Ziele gemäß Paris-Abkommen beziehen sich immer auf globale Mitteltemperaturen, worauf auch hier der Schwerpunkt gelegt wird.

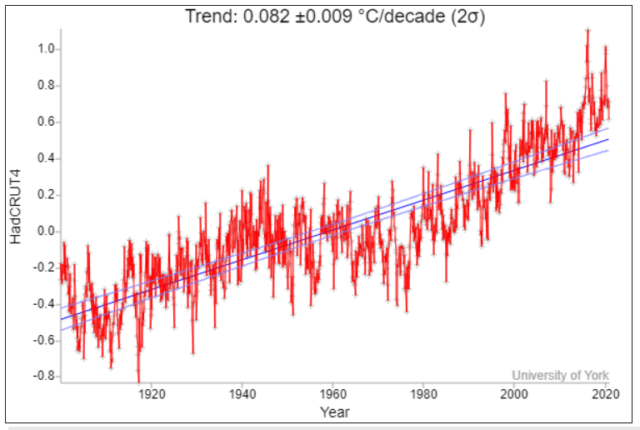

Der Temperaturanstieg seit Beginn der Industrialisierung fand vor allem im Laufe des letzten 120 Jahre statt (Darstellung unten nach Dr Kevin Cowtan – University of York, gefunden bei Kalte Sonne). Der Temperaturrückgang/-stillstand nach dem Jahr 2000 („Hiatus“), der den Temperaturrückgang zwischen 1945 und 1975 im Ansatz zu wiederholen schien, wurde seit 2016 von zwei El Niños unterbrochen. Was den Medien Gelegenheit gibt, fortlaufend „hohe“ Temperaturwerte zu vermelden, auch wenn es nur Zehntelgrad-Rekorde sind. Dennoch, in den kommenden zehn Jahren wird es spannend, wie es mit den Temperaturen weitergeht.

Setzt man diesen 120-jährigen Temperaturtrend fort, dann ist bis 2100 ein weiterer Temperaturanstieg von nur etwa 0,66 +/- 0,07 Grad C zu erwarten, was niemanden beunruhigen muss.

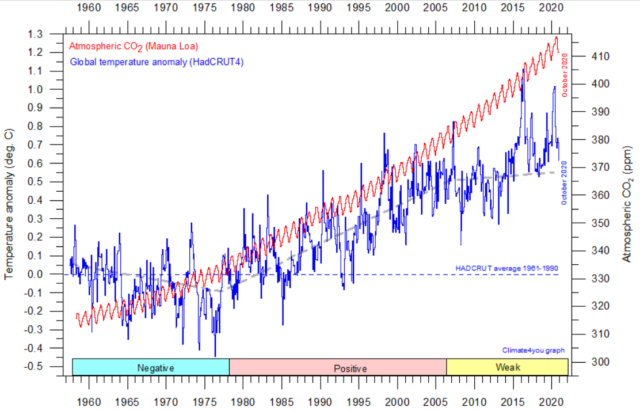

Von 1978 bis etwa 2005 korrelierten das CO2 und die Temperaturen kurzzeitig, was der Alarmforschung bekanntlich Auftrieb gab. Dazu in der nachfolgenden Grafik (von climate4you) rot eingetragen die CO2-Konzentration in der Atmosphäre, gemessen auf dem Mauna Loa. Davor und danach ist die Korrelation deutlich schlechter. Die beiden Peaks seit 2016 sind, wie bereits erwähnt, Folge des unregelmäßig wiederkehrenden Klimaphänomens El Niño, das von den Klimamodellen ebenfalls nicht dargestellt werden kann. Der CO2-Anstieg müsste genau genommen logarithmisch eingetragen werden, weil auch die spektroskopische Erwärmung nur dem Logarithmus der CO2-Konzentration folgt. Was dann den CO2-Anstieg etwas weniger „dramatisch“ aussehen lässt.

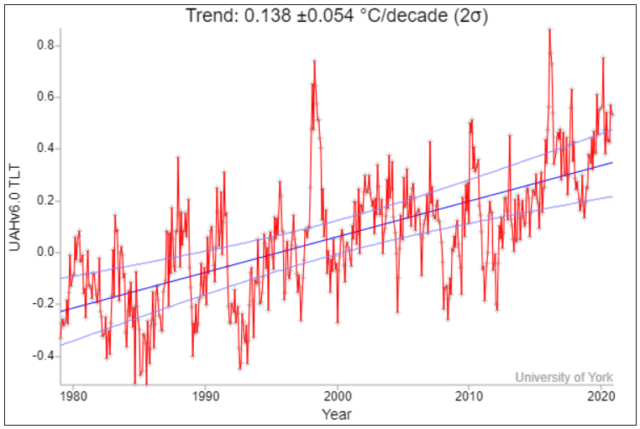

Seit etwa 1979 gibt es Satellitenmessungen, bei denen ebenfalls global gemessen wird und zwar die Mikrowellenstrahlung von O2 (Sauerstoff) in der Troposphäre:

Bei den Satellitendaten wird offenbar weniger manipuliert, doch auch hier gibt es einige Fragen: Man misst die Temperaturen in der Troposphäre und nicht in Bodennähe. Auch sind Nachjustierungen bei den Bahnparametern von Zeit zu Zeit erforderlich – zumindest, wenn dies bei den Satelliten nicht automatisch erfolgt. Auch gibt es z.B. bei El Niño Zeitverzögerungen, bis die Troposphäre den Bodentemperaturen folgt. Die hier gezeigten Satellitendaten schneiden immerhin gut ab beim Vergleich mit Ballonmessungen und sog. Nachrechnungen – siehe hier.

Bei Satellitendaten ist ferner zu beachten, dass es sie erst seit 1979 gibt, also seit Beginn der relativ steilen Anstiegsphase, ähnlich, wie sie auch schon von 1910 bis 1945 aufgetreten ist – was für eine „Übertreibung“ aufgrund der Auswahl des Zeitfensters spricht. In diesem kurzen Zeitabschnitt ist der Temperaturanstieg pro Dekade beinahe doppelt so hoch wie in den letzten 120 Jahren. Auch ist das Unsicherheitsintervall mehr als fünfmal größer.

Statistisch gesehen erlaubt deshalb der 120-jährige Messzeitraum, wie in der ersten Abbildung oben dargestellt, die verlässlichste Prognose mit einem Temperaturanstieg von nur 0,66 +/- 0,07 Grad C bis 2100. Wobei mit längerer Messdauer die Unsicherheitsintervalle immer kleiner werden.

Der reale Temperaturanstieg dürfte in Wirklichkeit sogar noch kleiner sein, wie z.B. der dänische Geologe Prof. em. Dr. Johannes Krüger ausführte:

„ Die offizielle, von NOAA (National Oceanic and Atmospheric Administration) entwickelte Temperaturkurve der globalen Temperatur für den Zeitraum 1900-1999, die das IPCC in seinen Berichten vorgestellt hat, wurde umfassend angepasst, um einen viel höheren Temperaturanstieg als die ursprünglichen Temperaturdaten zu zeigen. Die Anpassung trägt bis zu 0,3 ° C der postulierten globalen Erwärmung von 0,7–0,8 ° C während des 20. Jahrhunderts bei. Die Schlussfolgerung ist daher, dass die globale Temperatur zwischen 0,4 ° C und 0,7 ° C angestiegen ist, wobei die erste Zahl auf der ursprünglichen Temperaturreihe und die letzte auf angepassten und manipulierten Daten basiert. Keiner dieser Werte ist in irgendeiner Weise alarmierend.“

Was folgt daraus? Man sollte die Temperaturen unaufgeregt weiter beobachten, zumal Ozeane und Pflanzen immer mehr von dem atmosphärischen CO2 aufnehmen. Was auch die stark zunehmende Begrünung der Erde sowie die gestiegenen Ernteerträge beweisen. Und hinzu kommt, dass die Temperaturen, wenn überhaupt, aus spektroskopischer Sicht nur logarithmisch mit dem CO2 ansteigen. Auch gehen die „Fossilen“ sowieso früher oder später zur Neige. Selbst wenn nicht, was vor allem russische Wissenschaftler behaupten, ist genügend Zeit vorhanden, Temperaturen und das CO2 in der Atmosphäre vorerst weiter zu beobachten. Auch sollte man notwendige Folgetechniken möglichst dem Markt überlassen und nicht einer grünen Staatsplanwirtschaft!

Da die deutsche Energiewende kein tragfähiges Energiekonzept für die Zukunft bietet, wird voraussichtlich an Dual Fluid-Reaktoren der 4. Generation längerfristig kein Weg vorbei führen – sie sind inhärent sicher. Auch sind damit die bisher gelagerten Brennstäbe zu 90 bis 95% nutzbar. Bereits heute ist die Kerntechnik die mit Abstand sicherste Energietechnik – und dies trotz der Tschernobyl-Katastrophe. Letztere trat ein als Folge eines untauglichen Reaktorkonzepts sowie unglaublicher Bedienungsfehler. Die 20.000 Fukushima-Opfer waren ausschließlich dem Tsunami geschuldet, und nicht, wie es uns Grüne suggerieren, der Reaktor-Havarie, die sich dank unzureichendem Tsunami-Schutz ereignete. Der Kernbrennstoff Thorium sollte bei dem neuen Reaktorkonzept für mindestens 1 Mio. Jahre reichen. Bis dahin funktioniert auch die Fusion… Prozesswärme für synthetische Kraftstoffe gäbe es dann auch – Mobilität mit gewohntem Komfort und Reichweiten wäre möglich.

Die erhofften Resultate der geplanten CO2-Reduktion sind dagegen in jeder Hinsicht höchst ungewiss. Das beginnt mit der Frage, welche Staaten dabei überhaupt mitmachen – Deutschland alleine ist hier vollkommen bedeutungslos! Schon deshalb bleibt offen, wie viel CO2 überhaupt reduziert werden kann, und was, last but not least, bei den Temperaturen damit letztlich erreicht werden wird (und welches Temperaturziel überhaupt gelten soll). Auf die Klimamodelle kann man sich dabei nicht verlassen. Somit ist die Dekarbonisierung eine jahrzehntelange sehr kostspielige Geisterfahrt mit höchst ungewissem Ergebnis – die nachhaltige Schädigung des Industriestandorts Deutschland ist dagegen gewiss!

Wenn überhaupt, wären für eine CO2-Reduktion weltweite Aufforstungsprogramme sinnvoller und für eine zuverlässige Temperaturabsenkung Geoengineering billiger, zeitnah und effektiver!

Ärgerlich, warum sieht das Frau Merkel nicht genauso? Klar, sie hat bereits Billionen auf „Klima-Weltrettung“ durch Dekarbonisierung gesetzt, da gibt es kein Zurück…

Über den Autor

Dr. Roland Ullrich ist Physiker und promovierte an der LMU über Plasmaphysik.Sein Berufsweg führte ihn von der Plasmaphysik, einem kurzen Ausflug in die Welt der Metallhydridspeicher zu einer überwiegend gutachterlichen Tätigkeit in der technisch-wissenschaftlichen Analyseabteilung einer Bundesbehörde.

Dass CO2 die Anregungsenergie unter den Druckbedingungen der Troposphäre nicht reemittiert, sondern per Stoßdeaktivierung abgeregt wird, lässt sich sehr wohl belegen. Damit ist der „Gegenstrahlung“ jede physikalische Grundlage genommen. Eine Erderwärmung durch CO2 ist nicht physikalisch plausibel begründbar.

Es geht nur darum, das Prinzip zu erkunden. So lange beide Wärmequellen wärmer als die gemeinsame Umgebungstemperatur sind, werden sowohl die starke als auch die schwache einzeln einen Wärmezuwachs beim Empfänger bewirken und beide zusammen zumeist einen etwas höheren.

Man kann nun variieren und eine Wärmequelle so stark machen, daß sie z. B. den Empfänger um 20°C über die Umgebungstemperstur erwärmt. Wenn man nun die zweite Wärmequelle auf eine Sendetemperatur regelt, die knapp unterhalb der um 20°C aufgewärmten Empfängerplatte liegt aber doch höher ist als die Umgebungstemperatur, dürfte gem. 2. HS ein Dazuschalten dieser Quelle keine zusätzliche Weitererwärmung des Empfängers bewirken.

Das beweist, daß die häufig gehörte Behauptung, einzelne Strahlungsquanten „wissen nicht“, wo sie dazugehören, falsch ist! Sie „wissen es“ natürlich genau! Der 2. HS ist nämlich auch für Strahlung gültig.

Noch extremer wird die Sache, wenn man bedenkt, daß es sich beim Versuch um einen strahlenden Körper(!) handelt.

Bei CO2 handelt es sich um einzelne Gasmoleküle, die im Gegensatz zum breiten Strahlungsspektrum eines Körperstrahlers spektral ganz eng begrenzt strahlen und allesamt kühler als der Boden sind. Welche Schlußfolgerung ergibt sich daher bezüglich einer Gegenstrahlungswirkung aufgrund von CO2?

Die sogenannte Gegenstrahlung mit einer Wärmedämmung zu vergleichen, ist also nur für den sehr, sehr kleinen Teil der „Restwärme“ unseres Planeten zutreffend.

Das heißt also nichts anderes, als daß die Wärmedämmung in diesem Falle kühlt! Nutzt man technisch mit jeder Thermoskanne in der man im Sommer Kaltgetränke aufbewahrt.

Herr Strasser, Sie zeigen keinesfalls, sondern behaupten (!) lediglich dass der 2.HS auch für Strahlung gilt. Er gilt schon nicht für Gegenstrahlung, die Energie von kalt nach warm transportiert. Dabei wird dem kalten Körper Wärme entzogen und bei Absorption im warmen Körper Wärme erzeugt. Dessen Temperatur steigt allerdings nur wenn er beheizt ist (also z.B. wie der Erdboden durch Solarstrahlung) – ansonsten erfolgt verzögerte Abkühlung.

Viel Glück dazu! Technisch erspare ich mir einen Kommentar …