Statistisch gesehen, begann der leicht wärmende Klimawandel erst mit dem Ende des kalten Krieges signifikant zu werden

Man versucht, diesem Problem inzwischen mit verfeinerten statistischen Methoden wie der trendbeseitigenden Fluktuationsanalyse (DFA)[3] zu begegnen. Doch auch damit ist das wirkliche Basisproblem der ungenauen, historischen Daten nicht lösbar, schlimmer noch, gerade diese Methode ist auf genaue Vergangenheitsdaten angewiesen.

Video (leider nur in Englisch) von Pat Frank (Juli 10, 2016, Omaha, Nebraska.) als Ergänzung zu den im Beitrag behandelten immensen Unsicherheiten, die den historischen Temperaturdaten zwangsläufig und unabänderlich innewohnen. (Details dazu u. hier und hier und hier) Im Video zeigt der Vortragende unmissverständlich und unwiderlegbar auf, dass bei Anwendung der Fehlertheorie mit ihrem Fehlerforpflanzungsgesetz jegliche Klima-Modellaussage völlig bedeutungslos wird. Weil ihre berechneten Änderungen z.B. der Temperatur, z:B. allein auf Grund der ungenauen Kenntnis der Wolkenbedeckung 140 mal kleiner ist als die unvermeidbare Unsicherheit, die aufgrund des Gesetzes der Fehlerforpflanzung zwangsläufig entsteht. Und der Fehler durch die Wolkenbedeckung ist nur einer von vielen Fehlern.

Hinweis: Wer sich konkreter über diese statistische (DFA) Methode informieren möchte, findet in [6] und vor allem [4] gut erklärende Basisinformation. In [4] sind zudem zwei Temperaturmessreihen in Asien als Beispiele detailliert analysiert und dabei gezeigt, wie weit Trendaussagen abhängig von der verwendeten statistischen Methode differieren können (Anm.: dieses Beispiel aus [4] ist in der Dissertation [8] aufgegriffen und mit Zusatzinformation ergänzt) .

Trotzdem sind die Ergebnisse interessant, da sie die enormen – und wesentlich größer als bisher angenommenen – statistischen Unsicherheiten der Temperaturreihen aufzeigen.

Beispiel Messreihe von Bajtyk (Mongolei).

[4] Tab. 3; 1915-2001: Bajtyk

– Lineare Trendanalyse: 0,7°C auf 100 Jahre;

– DFA-basiertes Verfahren: 0,0 – 0,5°C auf 100 Jahre

Zusätzlich ist dort auch gezeigt, dass die zwei nur 320 km weit entfernte Temperaturstationen Karakol eine deutlich abweichende Trendaussage liefert. Dort beträgt der Trend:

Station Karakol: +1 °C +-0,2 in 100 Jahren

Nach der DFA-Trendanalyse begann der Klimawandel – wenn man ganz sicher sein will – erst nach 1990

In der Dissertation [8] wurde nach der DFA Methodik errechnet, ab wann ein von der Vergangenheit unabhängiger, neuer Temperaturtrend sicher besteht. Er beginnt mit dem Jahr 1990.

[8] In diesem Fall hat man für die näher diskutierten Rekonstruktionen Detektionsjahre id im Bereich von 1990 (Mann1999), 1993 (Briffa2000), 1994 (McIntyre2003) und 1995 (Esper2002) bis 1998 (Moberg2005) und 2002 (Jones1998).

Die Dissertation zeigt aber auch die mit der verbesserten Statistik nicht gelöste Problematik der historischen Ungenauigkeiten, denn Rekonstruktionsanalysen mit „geraden“ historischen Verläufen führen natürlich auch zum früheren „Beleg“ eines Klimawandel-Trends.

[8] Diese Analyse zeigt auch, wie wichtig es ist, über präzise Rekonstruktionen zu verfugen. Denn nur auf ihrer Basis kann die gegenwärtige Klimaerwärmung untersucht werden.

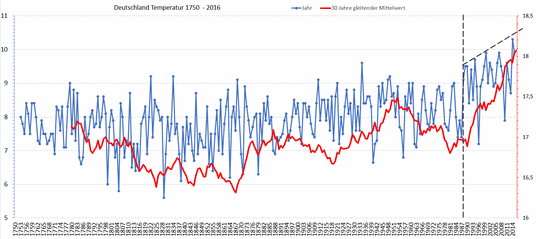

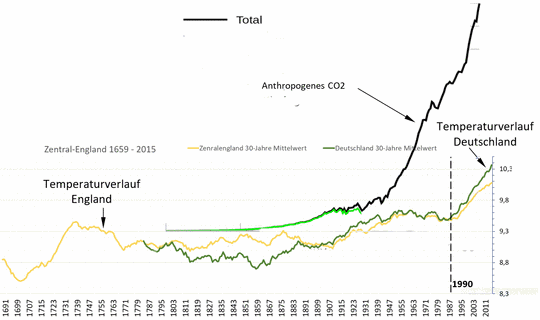

Was gerade global berechnet wurde, zeigt sich ebenfalls deutlich an den Temperaturverläufen in Deutschland (Bild 1) und auch von England (Bild 2). Erst ab dem Jahr 1990 beginnt der wirklich steile Temperaturanstieg. Dies gilt sowohl für die Globaltemperatur (Bild 1), wie auch im Detailverlauf der Station Potsdam (Bild 3), die wegen ihrer seltenen, langen Zeitreihe für Analysen gerne verwendet wird..

Um zu zeigen, über welche großen Zeitintervalle der Temperaturverlauf nicht mit dem anthropogenen CO2-Eintrag korreliert, ist auch dies anhand der Temperaturreihen von Deutschland und England dargestellt (Bild 2).

Bild 1 Bild 1 Temperaturverlauf Deutschland 1750 – 2016, Jahreswerte (blau, linke Temperaturskala), gleitender 30-Jahre Mittelwert (rot, rechte, gedehnte Temperaturskala). Vom Autor anhand der DWD Daten erstellt

Bild 2 Temperaturverlauf Deutschland (dunkelgrün) und Zentralengland (gelb) gleitende 30-Jahre Mittelwerte. Startwert Deutschland auf das Jahr 1783 mit dem Wert von England normiert. Die rechte Temperaturachse gilt für England, der Wert von Deutschland liegt um 1,33 Grad niedriger. Darüber eine Verlaufsgrafik des anthropogenen CO2-Eintrags (schwarz) kopiert. Grafik vom Autor erstellt.

Die Temperaturreihe von Potsdam

In globalen Kurven sind solche Artefakte aufgrund der vielen Mittelungen stark „verwischt“, in Einzelkurven zeigen sie sich deshalb deutlicher.

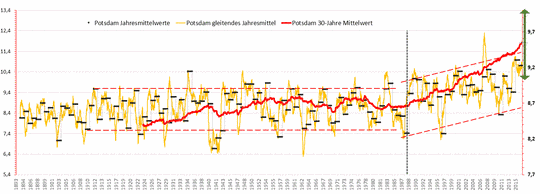

Das folgende Bild 3 zeigt den Temperaturverlauf der Station Potsdam (Anm.: Der Verlauf der Station Berlin Dahlem ist praktisch identisch). Genau mit der Wiedervereinigung 1989 zeigt sich nach einer langen, horizontalen Stagnation der Beginn eines deutlichen Trends, den auch sowohl der Verlauf von Deutschland und auch von England in Bild 2 aufweisen.

Bild 3 Temperaturverlauf Messstation Potsdam 1883 – 2015 (DWD-Stations-ID 3987) vom Autor aus den Daten erstellt.

Jahresmittel (schwarz), gleitendes Jahresmittel (gelb), gleitendes 30-Jahre Mittel (rot, Hinweis: rechte Temperaturachse),

+-0,5 °C Mittelwerttoleranz (grüner Doppelpfeil)

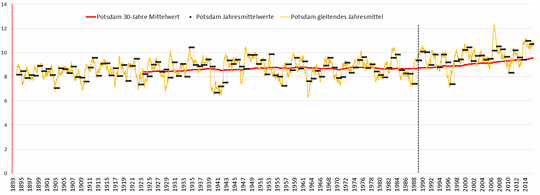

Um zu zeigen, wie unspektakulär sich dies ohne gedehnte Temperaturachsen darstellt, sind die gleichen Verläufe im Bild 4 bezogen auf die 0-Grad Achse gezeigt. Jeder Leser versuche einmal, die der Welt noch zugestandenen +0,6 Grad Temperaturerhöhung (sind dann +1,5 Grad seit Beginn der Industrialisierung) darin als Problem zu entdecken, wie es unserm Bundestag mit der einstimmigen Verabschiedung des Klimaschutzgesetzes am 22.09.2016 gelang.

Bild 4 Gleiche Daten wie Bild 1, aber bezogen auf 0 Grad und einheitliche Skalierung

In einer statistischen Studie [7] wurde der Fehlerbereich des Mittelwertes der Temperaturreihe Potsdam berechnet und mit +-0,5 °C angegeben.

[7] If the Potsdam anomalies were identically independently distributed data, this error would be about 0.07◦C. For AR(1) data with the given auto-correlation time, it would be about 0.2°C, for a pure long range correlated data set it would be about 0.3°C, and for the model which fits best the data it is 0.5°C.

As particular results, we found that the 95% confidence intervals for 30-year averages of the Potsdam temperatures (Darwin temperatures) are almost as large as (even larger than) the whole warming effect of the past 100 (50) years. Although the physical con sequences of increasing greenhouse gas concentrations are undebatable, this work shows that a quantitative assessment of climate change from observed data is still challenging.

The results shown for Potsdam and Darwin admit with low but finite probability both the absence of climate change as well as a warming of already much more than 1 °C, and without the past 5 years of data, the same analysis shows much less significance for warming.

[Übersetzung von Chris Frey: Falls die Anomalien von Potsdam identische unabhängig verteilte Daten wären, läge dieser Fehler bei etwa 0,07°C. Für die Daten im AR 1 mit der gegebenen Autokorrelationszeit wäre er etwa 0,2°C, für einen reinen, langfristig korrelierten Datensatz etwa 0,3°C und für das Modell, das am besten zu den Daten passt, wäre er 0,5°C.

Im Einzelnen fanden wir, dass die 95%-Vertrauensintervalle für 30-jährige Mittelwerte der Temperaturen von Potsdam (und der von Darwin) fast genauso groß (sogar noch größer) sind als der gesamte Erwärmungseffekt der letzten 100 (50) Jahre. Obwohl die physikalischen Konsequenzen zunehmender Treibhausgas-Konzentrationen nicht zur Debatte stehen, zeigt diese Arbeit, dass eine quantitative Abschätzung des Klimawandels aus Messdaten immer noch eine Herausforderung ist.

Die Ergebnisse für Potsdam und Darwin räumen mit geringer, aber eindeutiger Möglichkeit ein, dass sowohl das Fehlen eines Klimawandels als auch eine Erwärmung von schon jetzt mehr als 1°C abgeleitet werden kann, und ohne die Daten der letzten 5 Jahre würde die Analyse viel weniger Signifikanz für eine Erwärmung zeigen.]

Danach wäre der 30-Jahre Mittelwert der Station Potsdam erst in den letzten Jahren gerade eben aus dem statistischen Fehlerbereich einer horizontalen Verlaufslinie herausgekommen und die Wahrscheinlichkeit, dort wieder hineinzulaufen sehr hoch (sofern wie angenommen die jüngsten Temperaturspitzen zyklisch bedingt sind).

Fazit

Genauere statistische Trendanalysen zeigen, dass die Fehlerbänder der Temperaturkurven wesentlich größer sind als bisher (aus der Stichprobenstatistik berechnet) angenommen. Sie zeigen zudem, dass der belegbare Beginn der Warmphase erst mit den 90er Jahren des letzten Jahrhunderts wirklich begann und man kann zeigen, dass eine starke Korrelation des warmen Klimawandel-Beginns mit dem Ende des kalten Krieges besteht (sowie wie auch mit dem Steigen der US-Postgebühren). Ein gutes Beispiel, wie viel Unsinn selbst starke Korrelationen über die wirklichen Zusammenhänge aussagen können, allerdings auch eine Tatsache, die zum Grübeln über die AGW-Theorie Anlass gibt.

Wer sich schon immer gewundert hat (wie der Autor), wie zu offensichtlich mindestens ungenauen Proxi- und Temperaturverläufen extrem enge Vertrauensbereichs-Bänder hinterlegt sind (weil sie der Computer so berechnet hat, der von statistisch einwandfreien Daten ausging) mit der Wirklichkeit nicht überein stimmen können, findet sich hier bestätigt.

Anm.: Das Thema der Temperaturstufen wurde in [2] bereits mit vielen Beispielen dargestellt.

Nachtrag

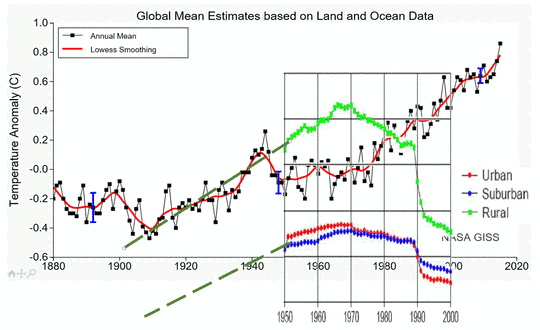

Zum Verlauf von globalen Temperaturkurven ein Anhang.

Die Temperaturstationen werden laufend ausgetauscht (wie im ersten Absatz beschrieben) und verändert. Anfang der 70er Jahre des letzten Jahrhunderts begann man jedoch, die Stationszahl extrem auszudünnen und zwar vor allem in ländlichen (also kühleren!) Gebieten[10]. Die Auswirkungen auf die Temperatur korrelieren erkennbar deutlich und ist besonders um das Jahr 1990 auffallend. Dies könnte manche Erklärungen für den „sonderbaren“ Verlauf von Temperaturkurven liefern.

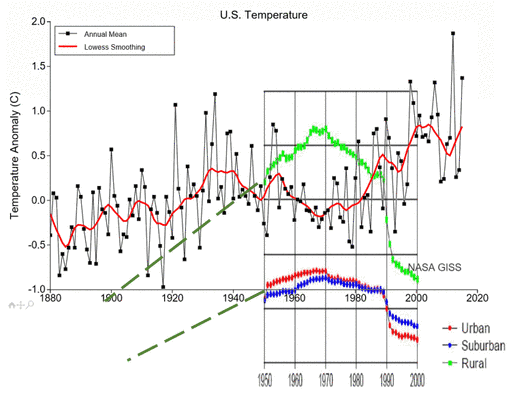

Bild 5 NASA GISS Globaltemperatur (Screenshot der GISS Animation) und vom Autor darüber kopiert die Grafik mit Anzahl und Art der Temperaturstationen aus [10]. Hinweis: die Verlängerungen der Stationsanzahl mit den dunkelgrün gestrichelten Linien sind vom Autor ohne Datenhintergrund rein fiktiv zugefügt.

Bild 6 NASA Giss US Landdaten (Screenshot der Giss Animation) und vom Autor darüber kopiert die Grafik mit Anzahl und Art der Temperaturstationen aus [10]. Hinweis: die Verlängerungen der Stationsanzahl mit den dunkelgrün gestrichelten Linien sind vom Autor ohne Datenhintergrund rein fiktiv zugefügt.

Quellen

[1] EIKE 11.05.2016: Die Problematik der Temperaturrekonstruktion Eine beispielhafte Sichtung dazu anhand des Projektes PAGES 2k

http://www.eike-klima-energie.eu/news-cache/die-problematik-der-temperaturrekonstruktion-eine-beispielhafte-sichtung-dazu-anhand-des-projektes-pages-2k/

[2] EIKE 06.11.2015: Langfrist-Temperaturverläufe Deutschlands: Das Phänomen der „Temperaturstufen“

http://www.eike-klima-energie.eu/news-cache/langfrist-temperaturverlaeufe-deutschlands-das-phaenomen-der-temperaturstufen/

[3] EIKE 23.09.2016:Konfidenz-Intervalle für zeitliche Mittelwerte bei langfristigen Korrelationen: eine Fallstudie zu Anomalien der Temperatur auf der Erde

http://www.eike-klima-energie.eu/news-cache/konfidenz-intervalle-fuer-zeitliche-mittelwerte-bei-langfristigen-korrelationen-eine-fallstudie-zu-anomalien-der-temperatur-auf-der-erde/

[4] Zentrum für internationale Entwicklungs- und Umweltforschung der Justus-Liebig-Universität Gießen

Discussion Paper Ivo Mossig* und Diego Rybski 2005: Die Erwärmung bodennaher Luftschichten in Zentralasien Zur Problematik der Bestimmung von Trends und Langzeitkorrelationen

[5] EIKE 09.09.2016: Hat die barbusige Dame um 1830 gegen den Klimawandel gekämpft? Eine ganz aktuelle Studie legt es nahe

http://www.eike-klima-energie.eu/news-cache/hat-die-barbusige-dame-um-1830-gegen-den-klimawandel-gekaempft-eine-ganz-aktuelle-studie-legt-es-nahe/

[6] Horst-Joachim Lüdecke 26.Feb. 2013: Klimatrends in Temperaturreihen

[7] Max Planck Institute for the Physics of complex SystemsM. Massah, H. Kantz 2016: Confidence intervals for time averages in the presence of long range correlations, a case study on earth surface temperature anomalies

[8] Institut für Theoretische Physik Gießen, Diego Rybski Dissertation 2006: Untersuchung von Korrelationen, Trends und

synchronem Verhalten in Klimazeitreihen

[9] EIKE: US Klimainstitut (GISS) verfälscht rückwirkend Temperaturdaten!

http://www.eike-klima-energie.eu/klima-anzeige/us-klimainstitut-giss-verfaelscht-rueckwirkend-temperaturdaten/

[10] WUWT 2009: How bad is the global temperature data?