Teil 1

In der Hunger-Zeit nach dem zweiten Weltkrieg warb ein geschäftstüchtiger Fleischermeister mit einem besonderen Angebot.

„Billig, billig: Reines Kaninchenfleisch (mit Pferdefleisch gemischt!)“ Im Kleingedruckten stand: „Mischung: 50:50!“. Ein neugieriger Kunde fragte nach, wie denn das mit der 50 : 50 Mischung zu verstehen sei? Der Meister zögerte ein wenig, bis er schließlich sagte: „Na, ja, ein Kaninchen, ein Pferd!“

So ähnlich kann man sich die Zusammensetzung des Kombikraftwerks vorstellen, welches das unermüdliche Fraunhofer-Institut für Windenergie und Energiesystemtechnik (IWES) in Kassel zusammen mit seinen Partnern[1]: der staunenden Öffentlichkeit kürzlich vorstellte.

Die dazu erstelle Pressemitteilung ist überschrieben mit:

Kombikraftwerk 2 demonstriert: „Sicherer Stromnetzbetrieb bei 100% Erneuerbaren Energien in Zukunft möglich“

Und um die sehr hohen Erwartungen an die Möglichkeiten dieses Projektes auch allen Gläubigen des Einsatzes von „Erneuerbaren“ zu demonstrieren, wurde außerdem ein schöner aufwendiger Film erstellt, der auf Youtube zu sehen ist.

Er hat den verführerischen Titel

„Stabiler Strom aus Erneuerbaren Energien“:

Hier das Youtube Video zum Projekt Kombikraftwerk 2

Als Dokumentarfilm aufgemacht und mit vielen Animationen angereichert, welche die schöne neue Welt mit hundert Prozent Ökostromversorgung den Zuschauern nahe bringen soll, zeigt er uns anschaulich was -dank Kombikraftwerk-2-Erkenntnissen- zukünftig möglich sein soll. Nämlich 100 % Stromversorgung aus Ökostrom. Geld für das Projekt ist jedenfalls genug da, denn es wird – wie anders – vom Bundesministerium für Umwelt mit rd. 1,8 Mio € gefördert. Der Anteil der vielen Projektpartner an der Förderung –allesamt Nutznießer des Geldregens aus der Energiewende- wird leider nicht genannt. Klein wird er jedoch nicht sein. Doch sonst ist von Geld oder gar Kosten samt Vergleichen, wie man dasselbe Ziel mit konventionellen oder mit Kernkraftwerken erreichen kann, mit keinem Wort die Rede.

Was wurde gemacht?

Deswegen ist es nützlich, sich die Fakten anzuschauen, die dem Projekt zugrunde liegen. Im „Hintergrundpapier[2] ist aufgelistet welche Einzel-Kraftwerke zum „Kombikraftwerk“ zusammengeschlossen wurden. Es handelt sich um zwei brandenburgische „Windparks“, 12 PV Anlagen im Raum Kassel und insgesamt sieben Biomasseanlagen in Hessen und im Saarland. Tabelle 1 zeigt deren Anzahl, Lage und Leistungsdaten

| WKA |

Ort |

Anzahl

Anlagen |

|

Nennleistung in MW |

|

Brandenburg Jüterbog |

18 |

|

37,2 |

|

Brandenburg Jüterbog |

19 |

|

39,2 |

| PVA |

Raum Kassel |

12 |

|

1 |

| Biomasse |

Wallerstädten |

1 |

|

1,2 |

|

Mittelstrimmig |

2 |

|

0,5 |

|

Zemmer |

2 |

|

1,4 |

|

Heilbachhof |

2 |

|

0,5 |

|

Zusammen |

56 |

|

81 |

Tabelle 1: Typ, Ort, Anzahl und Nennleistung der zum Kombikraftwerk 2 zusammengeschalteten Einzelanlagen mit zusammen 81 MW Leistung.

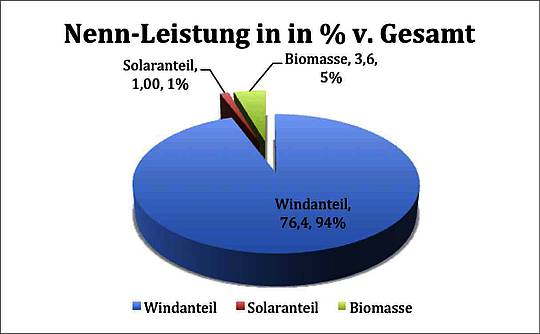

Sofort sticht ins Auge, dass es sich beim Zusammenschluss um eine recht willkürliche Angelegenheit handelt. Auch wenn Deutschland als Ganzes und insbesondere Kassel nicht von der Sonne verwöhnt werden, so ist doch der Anteil an PVA Leistung mit nur 1,2 % der Gesamtleistung extrem gering. Hält doch Deutschland mit rd 40 % der installierten PV Anlagen, deren Nennleistung sich inzwischen zu über 34 GW auftürmen den Weltrekord bei der Solarnutzung.

Ob die geringe Einspeisung für das Gelingen des Versuches erforderlich war oder nicht, wissen wir nicht. Denkbar wäre es jedenfalls. An zweiter Stelle folgen dann, mit ebenfalls geringen 4,44 % der Gesamtleistung, die Biomasseanlagen, während die Windparks, mit rund 94,3 %, dominieren.

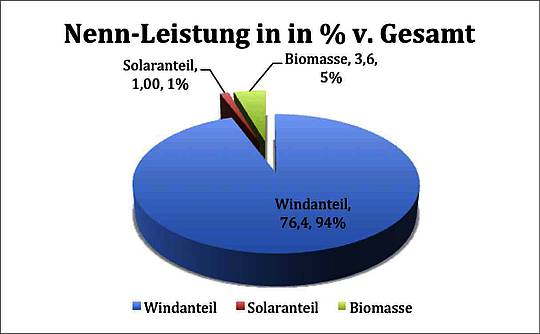

Das Tortendiagramm in Abb 1. zeigt die Anteile nochmals grafisch.

Abbildung 1: Verteilung der Nennleistungsanteile beim Feldversuch Kombikraftwerk 2.

Der Feldversuch hatte den Zweck herauszufinden ob „Erneuerbare“ sich dazu eignen sog. „Regelleistung“ bereit zu stellen. Das ist die Kraftwerksleistung, die zur Grundlast hinzukommen muss, um schwankenden Bedarf und/oder schwankende Einspeisung sekunden- bis minutenschnell auszugleichen. Dabei sind besondere Anforderungen an Frequenz und Phase der so eingespeisten Leistung zu erfüllen.

Auch ohne jeden Versuch dieser Art hätte man vorab feststellen können, dass sich Kraftwerke auf Biomassebasis jederzeit für die Bereitstellung von Regelenergie eignen, denn wie alle thermischen Kraftwerke können sie innerhalb gewisser – wenn auch bei Biomasse besonders enger-Grenzen (siehe Kommentare unten) beliebig herauf- wie auch heruntergefahren werden, d.h. je nach Anweisung des KW-Betreibers mehr oder weniger Leistung ins Netz einspeisen. Komplizierter wird diese Betriebsweise bei Windkraft- oder Solaranlagen. Aber auch diese lassen sich, wenn auch in wesentlich engeren Grenzen, auf- und abregeln, bspw. durch Verstellen des Anstellwinkels der WKA-Rotorblätter oder durch schrittweises Zu- und Abschalten oder Veränderung des Anstellwinkes einzelner PVA Felder. Mit der sehr wichtigen Einschränkung, dass dies nur möglich ist, wenn genügend Wind oder Sonne vorhanden sind. Also immer von Wind und Sonne abhängig.

Da nun die beiden letzteren generell immer von der Verfügbarkeit von Wind und Sonne abhängen, ist ihr Einsatz als Kraftwerke auch und besonders für Regelleistung – von wenigen Ausnahmen mal abgesehen – im Normalfall dem Willen der Götter unterworfen. Deswegen setzt man sie bisher nicht für deren Erbringen ein.

Der Versuch sollte nun demonstrieren, dass sich alle beteiligten Kraftwerkstypen zusammen als Regelleistungslieferant eignen würden. Dabei wurde bereits in der Kurzbeschreibung ausführlich dargelegt und auch im Film entsprechend gewürdigt, dass man später auch Speicher und Backup-Kraftwerke einbeziehen würde. Das ist in diesem Falle jedoch – mangels Speichern und Backup-Kraftwerken- nicht geschehen. Denn als Backup Kraftwerke gerade mal für 4,44 % der Leistung gut, kann man das Faulgas-Kraftwerk wohl nicht ansehen.

Was wurde versprochen?

Das Projekt wurde zentral vom Fraunhofer Insititut für Windenergie & Energiesystemtechnik (IWES) in Kassel entworfen und geleitet und im Versuch von dort im 3-Sekunden-Takt gesteuert. Der Versuch selbst dauerte insgesamt 20 Minuten und wurde schon nach dieser kurzen Zeit von der Projektleitung als Erfolg gewertet. Dabei gelang es lt. Versuchsleitung, die Netz-Frequenz mittels passender Steuerung der einzelnen Komponenten innerhalb einer Bandbreite von ± 0,03 Hz bezogen auf 50 Hz zu halten. Vollmundig sagte der Versuchsleiter Kurt Rohrig anschließend (Minute 7:20 ff)

„Unser Versuch hat gezeigt, dass die Erneuerbaren nicht nur genügend Energie liefern, sondern auch für eine stabile Spannung und eine stabile Frequenz sorgen“.

Wenn das so sein sollte, dann bleibt zunächst die Frage offen, was ein 20 minütiger Feldtest, aufs genaueste vorbereitet und ausgetrimmt, eigentlich beweisen soll? Hätte ein solcher als Nachweis für eine 100 % Versorgung aus „Erneuerbaren“ angekündigter „Feldversuch“, nicht über einen wesentlich längeren Zeitraum – mindestens 7 Tage á 24 Stunden, besser noch – weil wirklichkeitsnäher- – mehrere Monate mit Stark- und Schwachwindtagen sowie mit Sommer und Wintersonne laufen müssen?

Offen bleibt auch die Frage, warum man schon bei einem so positiven Ergebnis, (wenn auch nur im extrem kurzem Test) die Regeln für die Anlieferung von Regelleistung zugunsten der „Erneuerbaren“ ändern soll. Denn dies wurde im Hintergrundpapier eindringlich gefordert. Da bahnt sich offensichtlich, parallel zur Vorrangeinspeisung, der Wunsch nach Sonderbehandlung an. Aber diese Forderungen sollen hier jetzt nicht betrachtet werden.

Was wurde erreicht?

Wie der Film exemplarisch zeigt, wurde erreicht, dass die Frequenz unter kontrollierten Bedingungen innerhalb von ± 0,03 Hz ausgeregelt wurde. Dazu waren alle Teilkomponenten lieferbereit und zuvor entsprechend abgeregelt, um im Bedarfsfall ihre Leistung erhöhen oder im umgekehrten Fall drosseln zu können.

Weder genannt noch gezeigt wurden die Produktionsbedingungen insbesondere für die dominierenden Windkraftanlagen, die bis zu 94 % der Leistung betragen könnten. Auch wurde die Leistungsabgabe der PVA Anlage in Kassel nicht erwähnt, vielleicht weil diese mit nur max. 1,2 % zu Gesamtleistung beigetragen hätte.

Ebensowenig wurde gezeigt, wie das System reagiert, wenn die Netzfrequenz sich bis zu ± 0,2 Hz ändert. Das ist nämlich der Bereich, den normale Kraftwerke ausregeln müssen und können.

Somit ist die Schlussfolgerung des Projektleiters Rohrig reichlich kühn, wenn er diesen Mikroversuch, der unter engsten, streng kontrollierten Bedingungen durchgeführt wurde, als Beleg für das Vorhandensein grundlegender Eigenschaften ansah, wie man sie aus guten Gründen an eine funktionierende qualitativ hochwertige Stromversorgung stellen muss. Diesen Beweis erbrachte der Versuch nicht.

Was wurde nicht erreicht?

Nirgendwo -weder im ausführlichen Hintergrundpapier noch im Film – wurden die Randbedingungen erläutert, unter denen der Versuch durchgeführt wurde. Die Beschränkung auf die Ausregelung von mageren ± 0,03 Hz, also einem knappen Sechstel der zulässigen Abweichung, legt den Verdacht nahe, dass die Versuchsanforderungen extrem leicht waren. Auch gab es keine Informationen über Laständerungen o. ä.

Unterstellt man, wie im Film und im Hintergrundpapier behauptet. dass dieser Feldversuch ein gelungenes Beispiel für das Funktionieren der Versorgung eines Industrielandes wie Deutschland mit 100 % Strom aus „Erneuerbaren“ sein soll, dann erhebt sich sofort als weitere Frage, wie denn die Stromversorgung gesichert werden soll, wenn weder die Sonne scheint noch der Wind weht. Dann nützt weder ein Aufregeln der Windparks noch eine künstliche Beleuchtung der dunklen PVA Anlagen. Denn von nichts kommt nichts! Was verfügbar bleibt, ist die Energiemenge, die die Biomassekraftwerke (vulgo Faulgas-Generatoren) abliefern können. D.h. die maximal sicher abrufbare Regel-Leistung ist nur diejenige der paar Faulgasgeneratoren. Alles andere ist Beiwerk oder Spitzenlastausgleich für den eher seltenen Fall, dass Nachfrage und Angebot übereinstimmen.

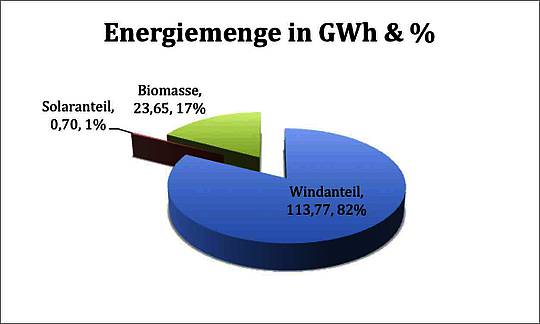

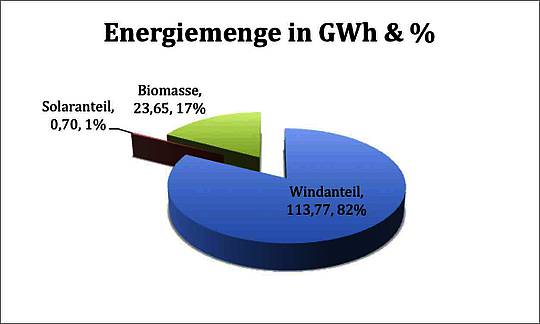

Abbildung 2: Maximal abgebbare Energiemenge je Kraftwerkstyp beim Feldversuch Kombikraftwerk 2

Die Leistung der Biomassekraftwerke und somit der obere Grenzwert an sicher verfügbarer Leistung lag hier bei 3,6 MW oder knapp 5 % der Gesamtleistung. Anders ausgedrückt, dieses Kombikraftwerk kann trotz seiner 81 MW Nennleistung dauerhaft und sicher nur bis zu 3,6 MW aufbringen. Das entspricht einem Verhältnis von 22,5 zu 1 zwischen installierter (und vom deutschen Michel bezahlter) Leistung und der sicher abrufbaren Leistung!

Aufgrund seines vglw. hohen Nutzungsgrades kann dieser Kraftwerkstyp im Durchschnitt zwar bis zu 17 % der Gesamtmenge an elektischer Energie erzeugen, aber eben auch nicht mehr. Die stündlich oder täglich abgebbare Energiemenge wird jedoch durch die maximale Leistung der Biomassegeneratoren[3] nach oben begrenzt. Von Speichern, die diese missliche Situation mildern könnten, insbesondere Batterien und/oder Wasserstoff-Methanspeichern, ist im Film zwar die Rede, aber sie wurden weder in den Versuch einbezogen noch sind sie in der Realität – selbst in diesen Minigrößenordungen- verfügbar

Nun wird man sofort einwenden, dass auch im konventionellen Bereich die Kraftwerke nach Grund- Mittel- und Spitzenlastkraftwerken unterschieden werden. Es muss nicht immer die volle Lieferkapazität bereitstehen, weil sich bestimmte Abahmesituationen in Abhängigkeit von Stunde, Tag und Jahreszeit kurz-, mittel- und langfristig planen lassen. Deshalb lassen sich dafür entsprechende Kraftwerkstypen und deren Leistung unter kosten- und betriebsoptimalen Bedingungen vorhalten. Das hat zusätzlich den Charme, dass auch unvorhergesehene Lastabrufe über die gleichen Kraftwerke abgefangen werden können.

Dieser berechtigte Einwand ist jedoch für die oben gezeigten Situation nicht stichhaltig. Denn alle konventionellen Kraftwerkstypen sind per se auch zur Erbringung von Grundlast sowie zur Abgabe von Regelenergie fähig. Und damit auch fähig zu jeder gewünschten Zeit, Strom – im Rahmen der jeweiligen Maximalauslegung – in gewünschter Menge, bereitzustellen. Es ist nur eine Kostenfrage, ob sie für diesen oder jenen Zweck eingesetzt werden oder nicht. Und damit keine Frage, die allein vom Wettergott entschieden wird. Deswegen müssen die Regellast- Kraftwerke auch nur bis zur Abdeckung der Spitzenlast ausgelegt werden und nicht für ein Vielfaches davon. Einer solchen, eigentlich selbstverständlichen, Anforderung genügen aber weder PVA noch Windkraftwerke. Denn die liefern ihre Leistung nur an wenigen Stunden des Tages und auch nur dann, wenn Wind oder Sonne es erlauben. Häufiger vorhersagbar, aber sehr oft eben auch nicht.

Also bleibt festzuhalten, dass uns die Versuchsleitung allen Ernstes weismachen will, eine Überkapazität von 23:1 im Kraftwerkspark wäre ein probates Mittel um 100 % „Erneuerbare“ einzusetzen.

Ende Teil 1

[1] Diese sind: CUBE – Engineering GmbH, Deutscher Wetterdienst, ENERCON GmbH, ÖKOBiT GmbH, Siemens AG, SMA Solar Technology AG, SolarWorld AG, Agentur für Erneuerbare Energien und Institut für Elektrische Energieversorgung an der Universität Hannover, Quelle http://www.kombikraftwerk.de/kontakt/impressum.html

[2] hier Kombikraftwerk Hintergrundpapier

[3] In der Realität ist sie auch beim Biomassekraftwerk noch geringer weil diverse Einschränkungen nur eine Nutzung von max. 75 % übers Jahr gestatten