Trotz der Milliarden: „Audits“ der Wissenschaft werden unbezahlten Freiwilligen überlassen.

Eine bestimmte, aber weitgehend unkoordinierte Basisbewegung von Wissenschaftlern ist um den Globus gejettet, um die Integrität der Theorie zu prüfen und sich mit einem gut finanzierten und wohlorganisierten Klimamonopol anzulegen. Sie haben erhebliche Irrtümer bloßgestellt.

Der Kohlenstoffhandel weltweit erreichte 2008 126 Milliarden Dollar. Banken rufen nach noch mehr Kohlenstoffhandel. Und Experten erwarten, dass der Kohlenstoffmarkt noch 2 bis 10 Billionen Dollar [trillions] erreicht, was den Kohlenstoff zum größten gehandelten Einzelposten macht.*

*Siehe Bemerkung weiter unten vor dem entsprechenden Abschnitt. A. d. Übers.

Auf einem ablenkenden Nebenschauplatz wird inzwischen die Exxon-Mobil-Corp. wiederholt angegriffen, weil sie insgesamt 23 Millionen Dollar an Skeptiker gezahlt haben soll – weniger als ein Tausendstel dessen, was die US-Regierung gezahlt hat, und weniger als fünf Tausendstel des Wertes des Kohlenstoffhandels allein im Jahre 2008.

Der riesige Aufwand, der bei der Suche nach einem Zusammenhang zwischen Kohlenstoff und Klima betrieben wird, erzeugt eine enorme Eigendynamik und ein mächtiges Kartell fest begründeter Interessen.

Indem wir so viel Geld in eine Frage gepumpt haben – haben wir da nicht aus Versehen eine sich selbst erfüllende Prophezeiung geschaffen anstatt einer unvoreingenommenen Untersuchung?

Kann die Wissenschaft eine solche schraubstockartige Umklammerung von Politik und Finanzwelt überleben?

Milliarden im Namen des „Klimas“

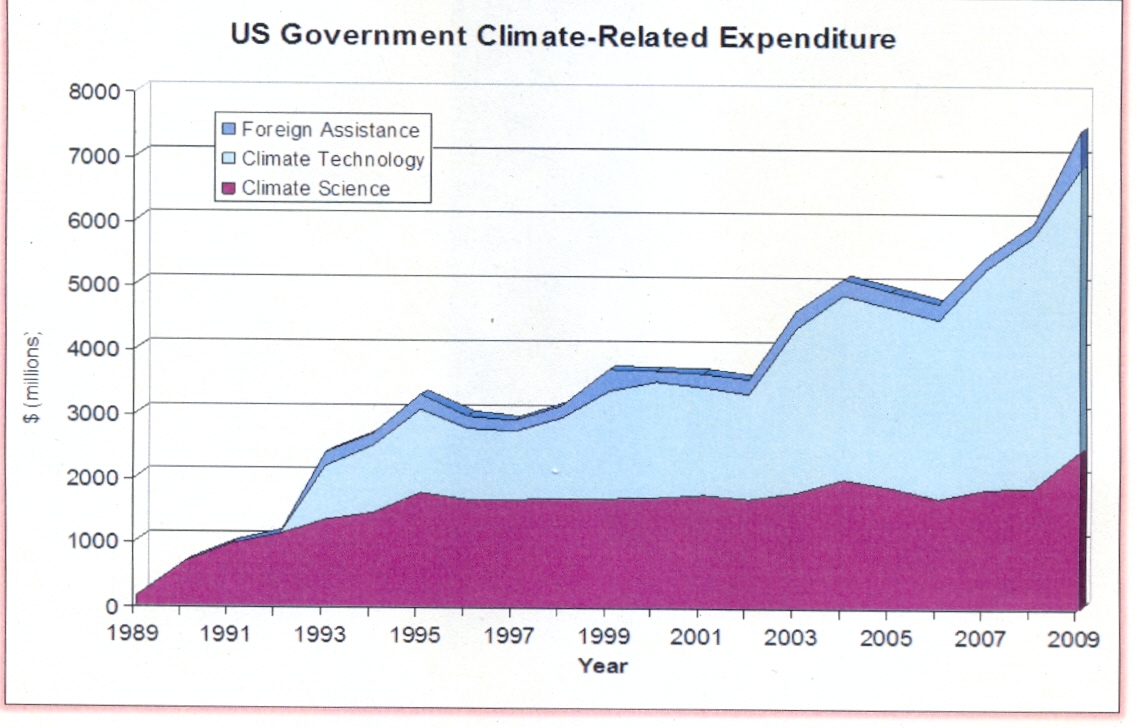

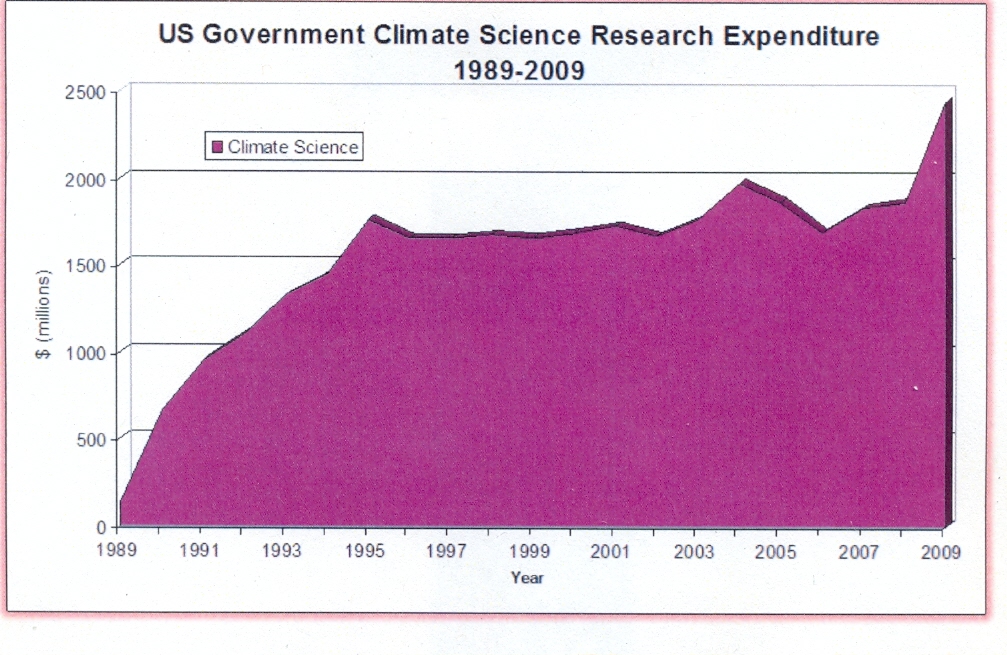

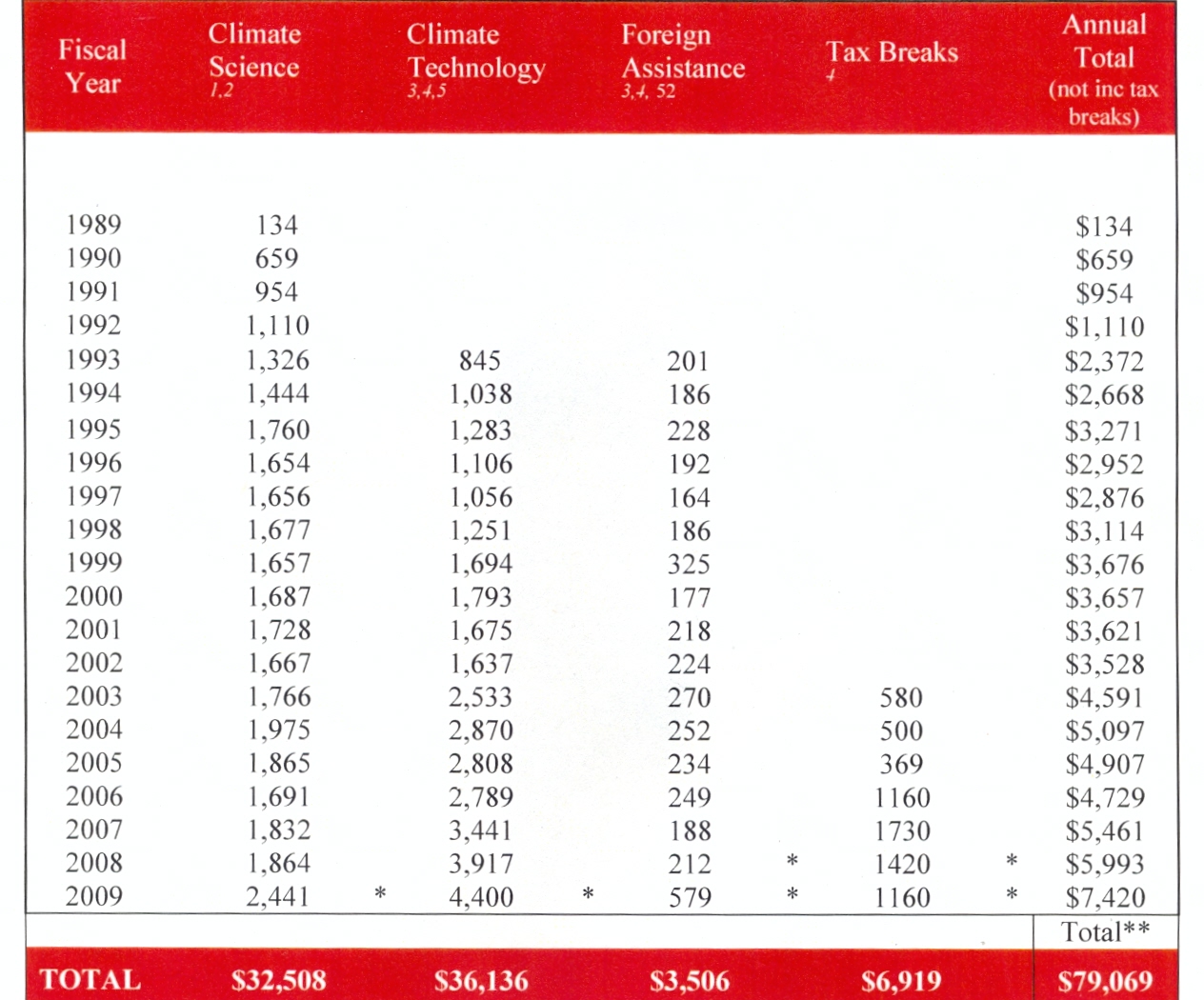

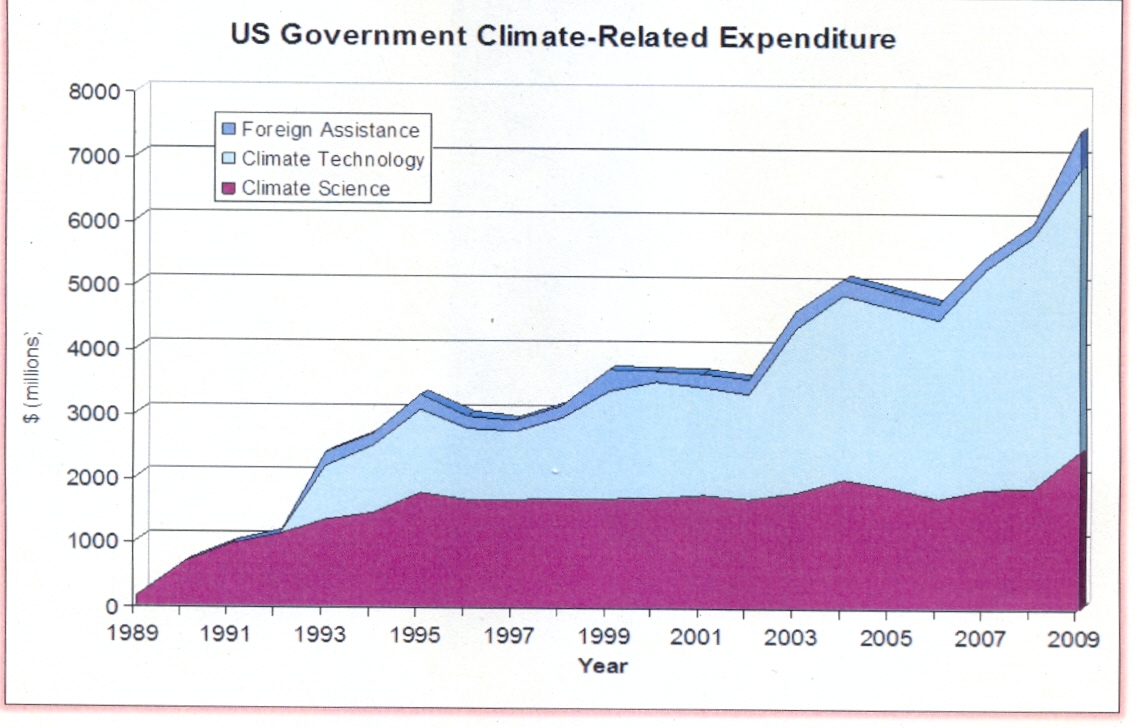

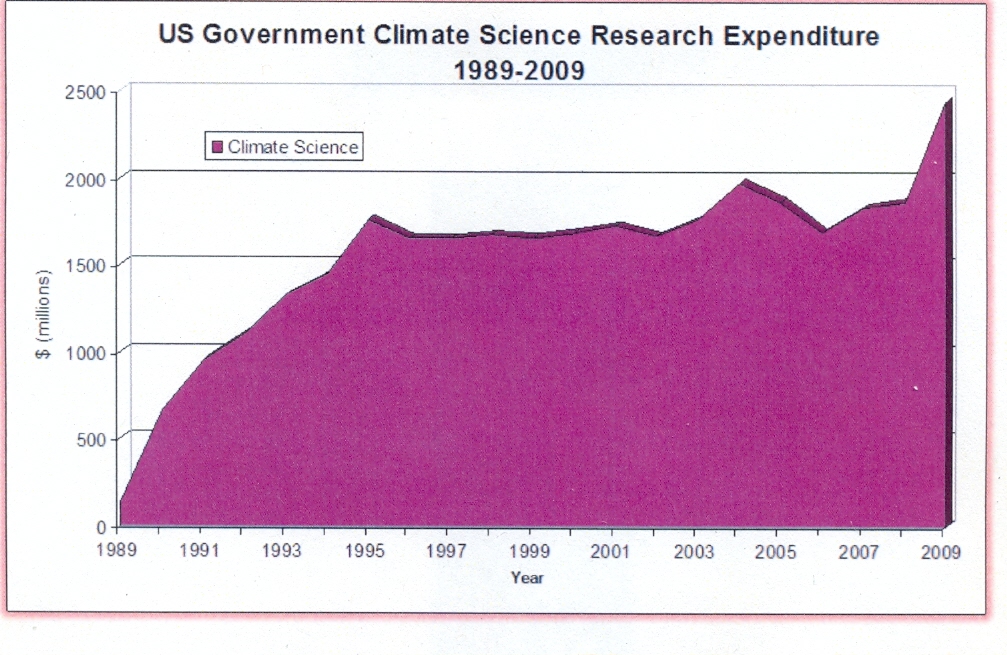

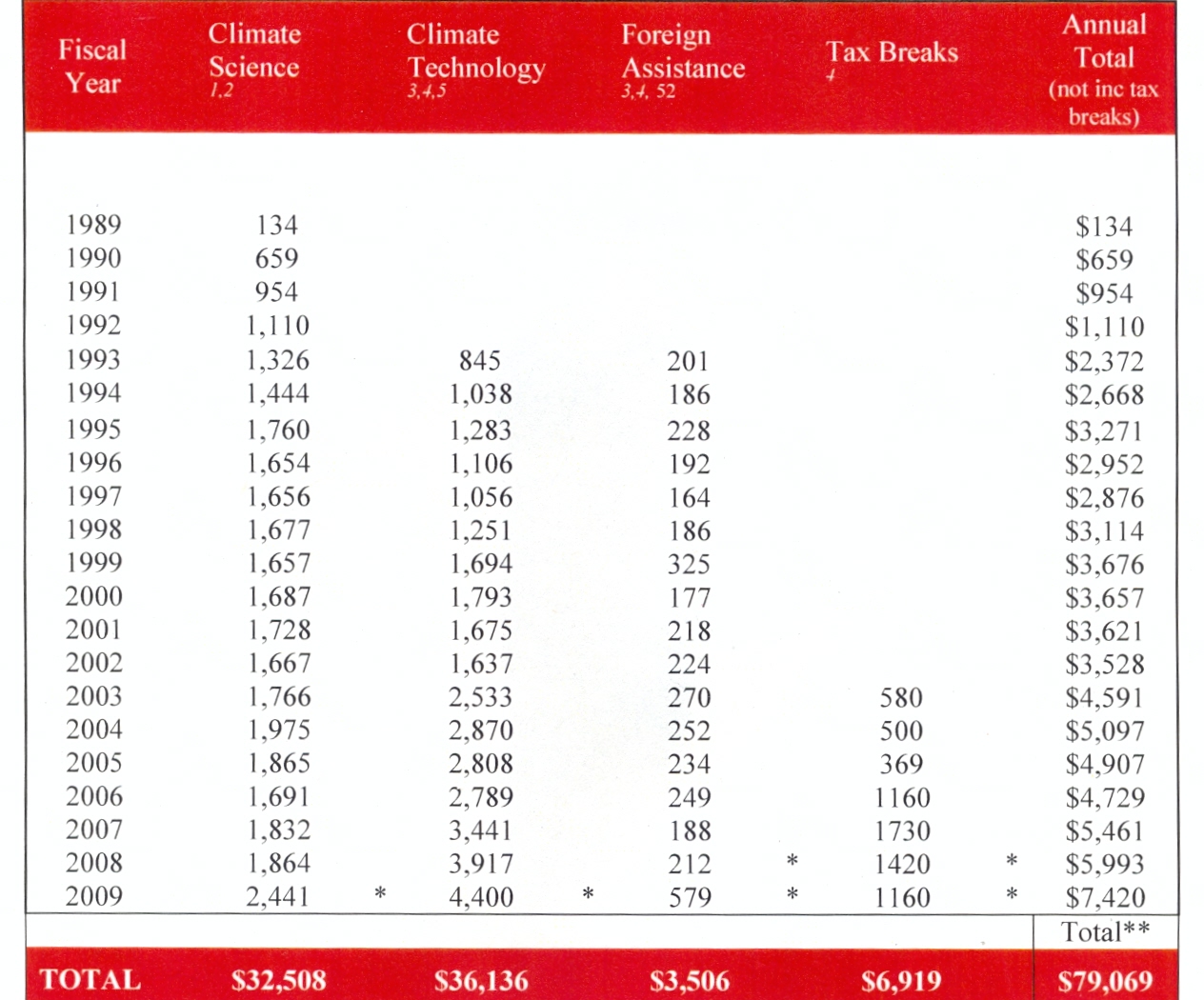

Insgesamt wird die US-Regierung während der letzten 20 Jahre bis zum Ende des Finanzjahres 2009 32 Milliarden Dollar [1,2] für die Klimaforschung ausgegeben haben – und weitere 36 Milliarden [3,4,5] für die Entwicklung von Technologien in Bezug auf das Klima. Dies sind aktuelle Zahlen, entnommen den Berichten der Regierung und nicht inflationsbereinigt. Zuwendungen anderer Regierungen oder der globalen Industrie sind darin nicht enthalten.

1989 wurde die erste US-Agentur gegründet, die sich speziell mit dem Thema Klima befassen sollte, mit einem jährlichen Budget in Höhe von 134 Millionen Dollar. Heute hat die Finanzierung die 7000 Millionen-Dollar-Grenze pro Jahr übersprungen, also 50 mal mehr. Steuerkonzessionen kommen dabei noch hinzu (siehe Anhang 1 für Details und Quellen).

Die Ausgaben zeigen also einen sehr steilen Anstieg. Mit enormen Steuererleichterungen und Rettungsfonds, die jetzt im Spiel sind, ist es schwierig herauszufinden, um wie viel wir über der 7-Milliarden-Marke im Finanzjahr 2009 insgesamt liegen. Zum Beispiel beliefen sich die Kosten für Experimente zur Abscheidung von Kohlenstoff allein auf bis zu 3,4 Milliarden [6] im American Recovery and Reinvestment Act aus dem Jahr 2009. (Diese sind bei den 7 Milliarden noch nicht enthalten).

Der bedeutendste Punkt ist, dass nach einer Ausgabe von 30 Milliarden für reine wissenschaftliche Forschung noch niemand in der Lage ist, auch nur einen einzigen Beweis dafür vorzulegen, dass das anthropogene CO2 einen signifikanten Einfluss auf das Klima hat [7]

Falls Kohlenstoff nur ein geringer Mitspieler beim globalen Klima ist, wie es das Fehlen von Beweisen nahe legt, würden die Programme „Climate Change Science Program (CCSP)“ und das „Climate Change Technology Program(CCTP)“ sowie einige Anreize für grüne Belange und Steuererleichterungen wenige, geringe oder gar keine Grundlagen für ihre Existenz haben. Während die Vorhersage von Wetter und Klima kritisch ist und es andere gute Gründe gibt, alternative Energiequellen zu entwickeln – niemand kann behaupten, dass die Tausende Mitspieler, die diese Dollarmilliarden erhalten haben, irgendeinen realen Trieb verspüren zu „verkünden“, die Nichtsignifikanz der Rolle des Kohlenstoffs gefunden zu haben.

Ausgaben der US-Regierung von 1989 bis 2009

(Millionen Dollar)

|

Wissenschaft

Technologie

Hilfe für Ausland

Steuererleichterungen*

Insgesamt

|

32 508

36 136

3 506

6 919

79 069

|

*2003 bis 2008, ohne die Multimilliarden Dollar Finanzzuschüsse [financial recovery packages] vom Oktober 2008 und Februar 2009

Durch das Errichten von Handelsnetzwerken, Steuerkonzessionen und internationalen Bürokratien, bevor Beweise vorgelegt werden konnten, haben wir damit nicht sichergestellt, dass unser Verständnis von der Rolle des Kohlenstoffs in der Klimawissenschaft vorankommt, aber dass sich unser Verständnis jedes anderen Aspektes der Klimawissenschaft nicht in gleichem Maße verringert?

Die monopolistische Förderung erzeugt einen Sperrriegeleffekt, bei dem selbst über die unbedeutendsten Ergebnisse der AGW-Ergebnisse berichtet wird, und zwar wiederholt, mit Triumphgeschrei und mit absoluter Sicherheit, während jedwedes Ergebnis, das gegen AGW spricht, eine Lüge ist, von unqualifizierten Leuten stammt, ignoriert und verzögert wird. Die Begutachtung von AGW ist so unterfinanziert, dass es zum größten Teil unbezahlten Bloggern vorbehalten ist, die online Spenden von besorgten Bürgern sammeln. Diese Auditoren, oftmals Wissenschaftler im Ruhestand, stellen der Gesellschaft kostenlos einen wertvollen Service zur Verfügung, und doch werden sie im Gegenzug angegriffen, missbraucht und beleidigt.

Am Ende wird die Wahrheit herauskommen, aber wie viel Schaden wird angerichtet sein, während wir auf Freiwillige warten, um die Behauptungen der finanziell Überfütterten einer Begutachtung zu unterziehen?

Der verstohlene Masseneintritt von Bankiers und Händlern in den Hintergrund der wissenschaftlichen „Debatte“ stellen schwere Bedrohungen des wissenschaftlichen Prozesses dar.

Das „Milliarden-Dollar“-Versprechen für die Rohstoffmärkte – mit allem finanziellen Potential dafür, dass die menschlichen Emissionen von Kohlendioxid eine signifikante Rolle beim Klima spielen – kann man sicher mit einer Schlammdecke vergleichen, die über einer offenen leidenschaftslosen Analyse liegt.

All das bedeutet, dass wir große Extrasorgfalt aufwenden müssen, um uns nur auf die Beweise zu konzentrieren, die Wissenschaft, die empirischen Daten. Unlogik und Unvernunft umwölken eine Debatte, die ohnehin schon vollgeladen mit Verzerrungen ist. Wenn es so viele Anreize gibt, die Unklarheiten und Überkomplexitäten ermutigen, braucht die einfache Wahrheit viel Hilfe, um an die Spitze zu rücken. Aber wer fördert die Gegen-PR-Kampagne – wenn jetzt selbst Exxon aus dem Theater der Wissenschaft hinaus gebrüllt wurde? Es gibt kaum irgendwelche Gelder, um die natürlichen Gründe der Klimaänderungen zu erforschen, während für die Erforschung unnatürlicher Kräfte Milliarden über Billionen ausgegeben werden.

In dieser wissenschaftlichen Diskussion ist die eine Seite geknebelt, während die andere Seite über eine von der Regierung geförderte Medienkampagne verfügt.

30 Milliarden Dollar für eine monopolistische Wissenschaft

Ein Prozess ohne Verteidigung ist Betrug

Wirtschaft ohne Wettbewerb ist ein Monopol

Wissenschaft ohne Diskussion ist Propaganda

Der wissenschaftliche Prozess wurde deformiert. Eine Seite der Theorie erhielt Milliarden, während die andere Seite so ärmlich finanziert ist, dass die Überwachung dieser Forschung als Gemeinschaftsservice übrig bleibt, und zwar für Leute mit der Erfahrung von Experten, einer dicken Haut und Leidenschaft aus Passion. Eine Art von „sich eines Irrtums annehmen“.

Kann die Wissenschaft diesen Klammergriff von Politik und Großfinanz überleben?

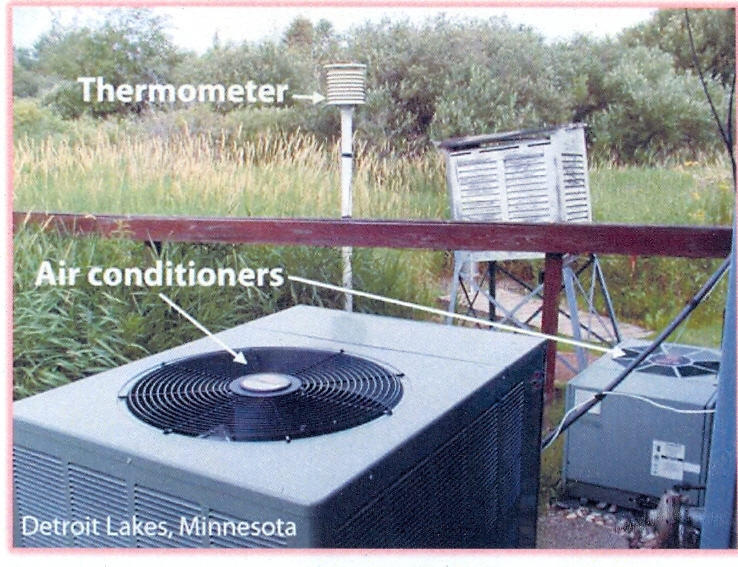

Trotz der Milliarden schweren Dollarunterstützung wurden himmelschreiende Fehler gemacht. Besonders einer der Heuler [howler] schrieb die Geschichte um und kam damit jahrelang durch, bis ein engagierter, ohne Bezahlung arbeitender Untersucher den Betrug um den Hockeyschläger aufgedeckt hatte. Mittlerweile sind Agenturen wie das Goddard Institute of Space Studies GISS nicht in der Lage, Temperaturfühler zu installieren, die ihren eigenen Vorschriften genügen, weil die Arbeiter kaum ausgebildet und lediglich mit Gartenschippen und Spaten ausgerüstet sind. NOAA „adjustiert“ die Daten nach der Messung – offensichtlich, um die [Werte der] Sensoren zu kompensieren, die zu dicht an den Austrittsöffnungen von Lüftungsanlagen oder Parkplätzen liegen, und doch erhebt sich die Frage: Wenn das Klima das größte Problem ist, dem wir derzeit gegenüber stehen; und falls die Milliarden von Dollar gebraucht werden, warum können wir die Thermometer nicht ordnungsgemäß installieren?

Wie ernst ist es ihnen, ordentliche Daten zu erhalten? Oder sind sie nur darauf aus, die „richtigen“ Daten zu bekommen?

Die Gesamtzahl von Interessengruppen in der Klimawissenschaft ist viel größer als nur die Wissenschaftler, die echte Forschung betreiben. In der Unterstützung in Höhe von 30 Milliarden Dollar (Abbildung oben) für die CCSP sind noch nicht Arbeiten für grüne Technologien wie Verbesserung von Solarzellen oder das Verpressen eines harmlosen Gases in den Untergrund enthalten. Die Zuwendungen für Klimatechnologien liegen buchstäblich doppelt so hoch wie die involvierten Gelder und füttern einen viel größeren Pool von ehrbar aussehenden Leuten mit einem eindrucksvollen wissenschaftlichen Gehabe, die noch mehr Presseverlautbarungen ausgeben – wovon die meisten wenig mit grundlegender atmosphärischer Physik zu tun haben, sondern immer nur die Hypothese wiederholen, dass sich das Klima wegen der menschlichen Emissionen erwärmen wird. Mit anderen Worten: eine 30 Milliarden Dollar teure Jubeleinheit.

Eine große Menge einseitiger Forschung sorgt nicht für eine faire Diskussion

Die von der Regierung bezahlten Wissenschaftler müssen nicht unehrlich gegenüber der Wissenschaft sein, um verzerrte Ergebnisse zu liefern. Sie müssen einfach nur ihre Arbeit machen. Wenn wir 100 Leute beauftragen, nach Eidechsen im Dschungel zu suchen, würde es da jemanden überraschen, wenn er einen Elefanten auf der Ebene sieht? Wenige Leute werden bezahlt oder belohnt, um das IPCC oder damit verbundene Organisationen zu überwachen. Wo befindet sich die Abteilung für solare Einflüsse oder das Institut für natürliche Klimaänderungen?

Tausende Wissenschaftler erhielten Zuwendungen, um eine Verbindung zu finden zwischen menschlichen Kohlenstoffemissionen und dem Klima. Kaum jemand wurde dafür bezahlt, das Gegenteil zu finden. Man wende 30 Milliarden Dollar zur Beantwortung einer Frage auf, wie kann es dann sein, das brilliante, überzeugte Leute 800 Seiten von Verbindungen, Links, Vorhersagen, Projektionen und Szenarien nicht finden konnten? (Wobei wirklich erstaunlich ist, was sie noch nicht gefunden haben: empirische Beweise!)

Und Wissenschaftler sind menschlich, sie haben Hypotheken und Kinder. Falls das Geld von Exxon irgendeine Anziehungskraft hat, muss das Geld von der Regierung auch „ziehen“.

Ich kann es nicht besser ausdrücken als Al Gore in einem Film Eine unbequeme Wahrheit:

Es ist schwierig, einen Menschen dazu zu bringen, etwas zu verstehen, wenn sein Gehalt davon abhängt, dass er es nicht versteht. – Upton Sinclair, 1935

Ironischerweise war es Al Gore selbst, der sicher stellte, dass das US Global Change Research Program (USGCRP) von 1993 bis 2000 so umfangreich gefördert worden ist. Wir haben Milliarden dafür aufgewendet, herausragende Gehirne auf einen Blickwinkel, ein Thema, einen Grund zu konzentrieren. Das ist eine Menge Holz!

Milliarden für „das Klima“, aber die Überwachung wird unbezahlten Freiwilligen überlassen

Die besten Beispiele für unbezahlte Begutachtungen sind die Arbeiten von unabhängigen Wissenschaftlern wie Steve McIntyre [8] und Anthony Watts. Hier haben wir die ironische Situation, in der erfahrene Arbeiter einen kostenlosen Beratungsservice zur Verfügung stellen, um der größten Einzelinstanz des Planeten zu „assistieren“.

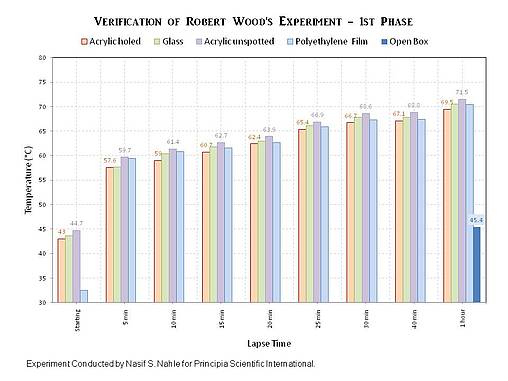

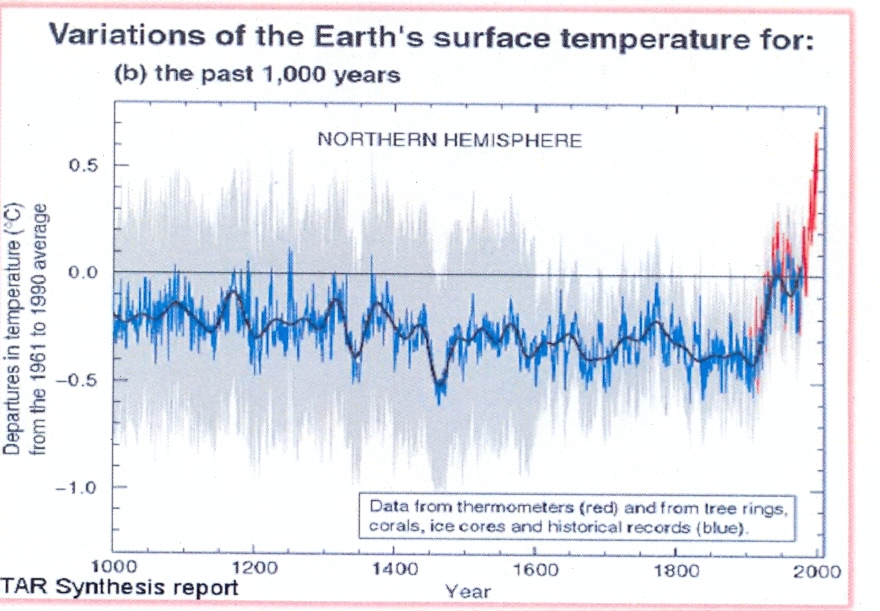

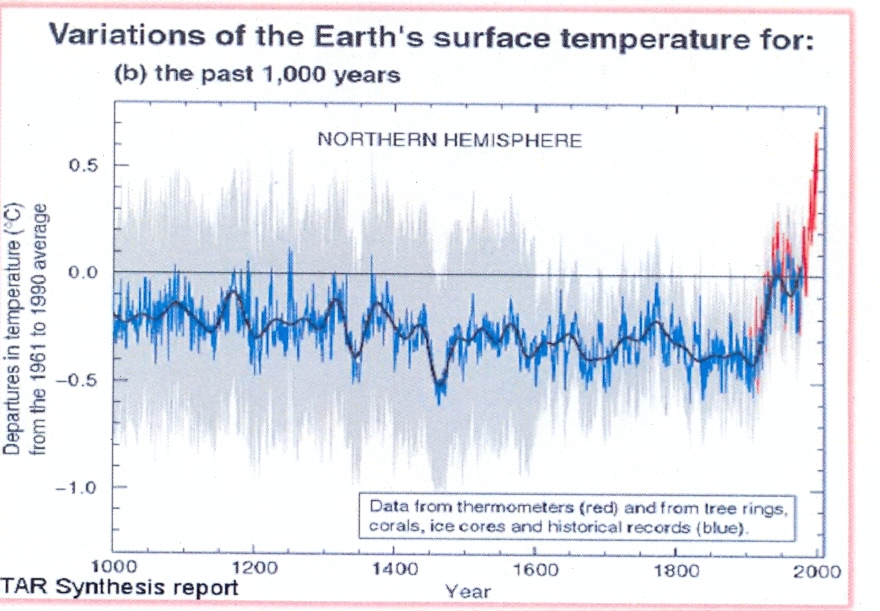

Steve McIntyre hatte eine mathematische Ausbildung und arbeitete 30 Jahre lang in der Erkundung von Mineralien [9] (und hat niemals trotz gegenteiliger Behauptungen für die Ölindustrie gearbeitet). Hier folgt die Hockeyschlägerkurve aus dem Zustandsbericht des IPCC 2001:

Die in die Irre führende „Hockeyschläger“- kurve

McIntyre kam die Hockeyschlägerkurve verdächtig vor, weil sie ihn an einen Bre-X–Schwindel [?] erinnerte. Er ist im Ruhestand und arbeitete mit großem eigenen personellen Aufwand ohne jede Bezahlung [10].

McIntyre fand empörende Fehler [11] in der Hockeyschlägerkurve, einer Kurve, die jahrhundertelange historische Aufzeichnungen, archäologische Tatsachenbefunde und Daten von fast allen anderen Quellen außer unzuverlässigen „Baumringen“ einfach auslöschte. (Baumringe werden auch durch die Regenmenge und das Angebot an Nährstoffen beeinflusst). McIntyre fand, dass der von Michael Mann erzeugte und wiederholt im IPCC-Bericht 2001 zitierte Graph so schlecht konstruiert war, dass es möglich war, beliebige Daten als „Rauschen einzugeben und immer wieder ein Hockeyschläger herauskam. Eine wirkliche wissenschaftliche Begutachtung hätte darauf hinweisen müssen! Statt dessen stand der Graph drei oder vier Jahre lang im Mittelpunkt, bis ein entschlossenes skeptisches Individuum die Daten in Frage stellte (welche erst unangebracht, dann ungenau, dann inkonsistent waren) und die Statistiken genau unter die Lupe nahm.

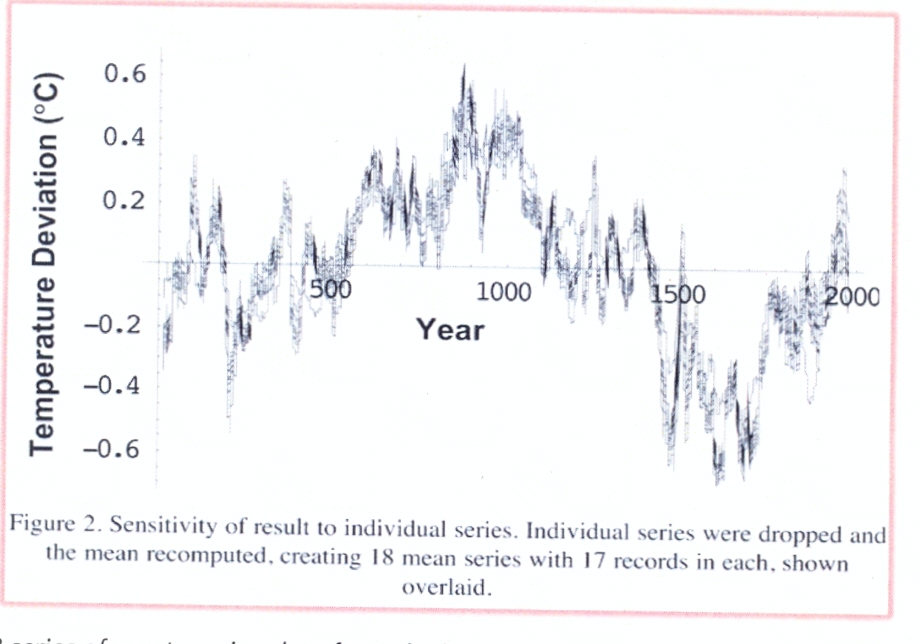

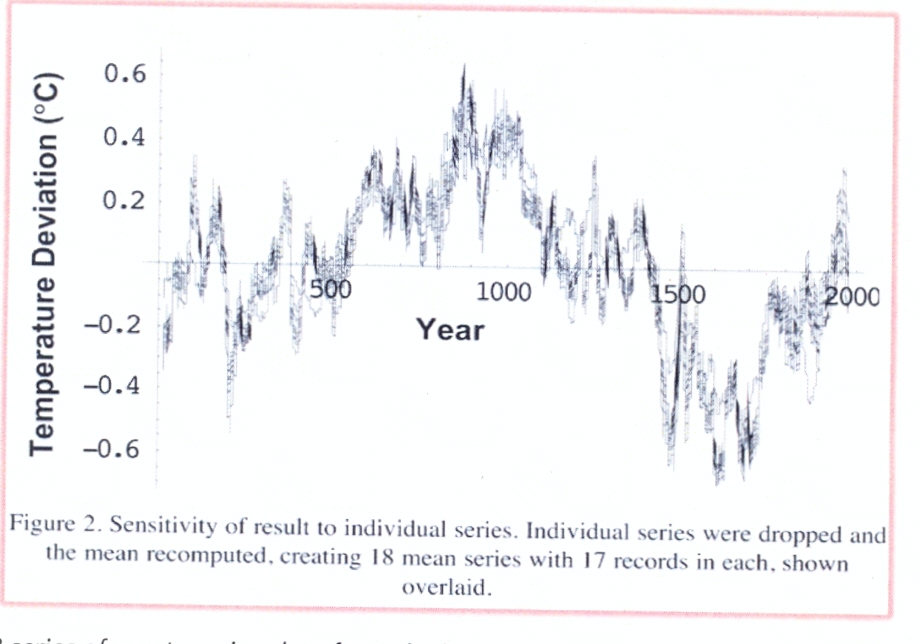

McIntyre und Ross McKitrick fuhren fort, wissenschaftlich begutachtete Studien zu veröffentlichen [12, 13, 14]. Wegman und andere unabhängige Statistikexperten unterstützten McIntyre und McKitrick [15]. Craig Loehl untersuchte den gleichen Zeitraum mit anderen Proxies als Baumringen, und die Tatsache der Mittelalterlichen Warmzeit und der Kleinen Eiszeit stachen wieder heraus [16].

Die Kombination von 18 Reihen nicht aus Baumringen stammender Daten der letzten 2000 Jahre zeigt eindeutig die Mittelalterliche Warmzeit und die Kleine Eiszeit und demonstriert offenkundig, wie sehr der „Hockeyschläger“ in die Irre führt.

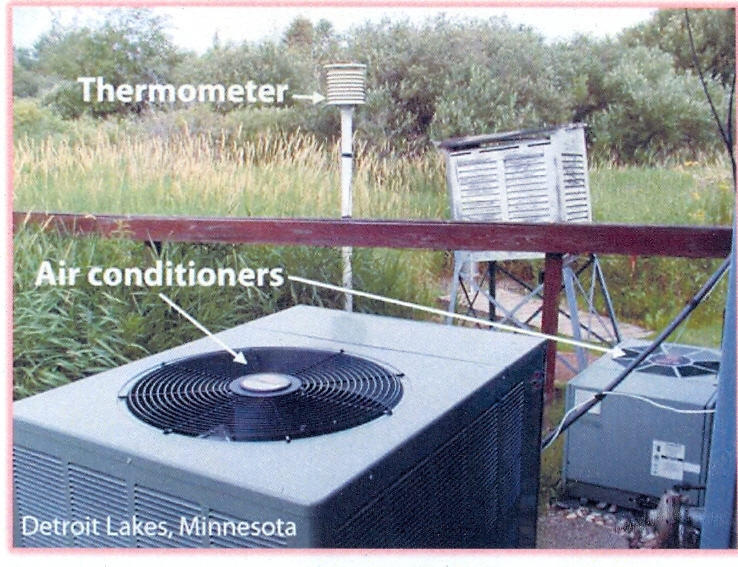

Ganz ähnlich hat Anthony Watts, ein ehemaliger Fernsehmeteorologe, eine Gruppe von 650 Freiwilligen rekrutiert, die mehr als 800 Temperatursensoren des United States Historical Climatological Network (USHCN) [18] fotografieren und beschreiben sollten – was eigentlich Aufgabe der NOAA [National Oceanic and Atmospheric Administration, die US-amerikanische Wetterbehörde] selbst wäre. Obwohl sie rund 4 Milliarden Dollar pro Jahr an Zuwendungen erhalten hatte, unternimmt die NOAA keine umfassenden Untersuchungen der Aufstellungsorte, um sicherzustellen, dass die Sensoren den erforderlichen Standards genügen.

Die Mehrzahl der Temperaturfühler der NOAA liegt neben Abluftschächten, Parkplätzen, Gebäuden und anderen künstlichen Wärmequellen.

Das sind keine kleinen Abweichungen der Messpunkte, die Anthonys Team von Freiwilligen fotografiert hat. Stationen für die Aufzeichnungen stehen neben Abluftschächten (Abbildung 5), über Asphalt von Parkplätzen, auf kochend heißen Dachspitzen aus Beton und neben geheizten Gebäuden.

Die Untersucher fanden, dass 89% aller bisher untersuchten Stationen nicht die vom Nationalen Wetterbüro selbst aufgestellten Standards erfüllten. [20]

Erneut sind die Mängel systematisch. Da als Sensor anstelle der Thermometer heute elektronische Messfühler die Daten anzeigen, wurden sie durch Leute installiert, die lediglich mit Kreuzhacken und Schaufeln ausgerüstet waren. Wurden frühere Sensoren im Freien über Gras und weit entfernt von einem Parkplatz errichtet, sind die neuen Messfühler elektronischer Natur, d. h. sie benötigen Stromversorgung aus Gebäuden. So war es keine Überraschung, dass sie an weniger idealen Stellen viel dichter am Gebäude aufgestellt wurden. Wer würde sich schon per Hand nur mit einem Spaten bewaffnet durch einen asphaltierten Parkplatz wühlen, um Platz für das Kabel zu schaffen?

Das Team bei der NOAA zieht es vor, „mathematische Anpassungen“ vorzunehmen, um die Nachteile der Lokalität und den „urbanen Wärmeinseleffekt“ auszugleichen. Wenn sie wirklich daran interessiert wären, die Daten korrekt zu ermitteln, hätten sie dann nicht einfach alle Stationen ausschließen sollen, die an nicht geeigneten Plätzen stehen, bis zu der Zeit, an der diese Ausgleichswerte ordnungsgemäß ermittelt sind? Hätten sie nicht für einen Gräben ziehenden Bagger zahlen sollen?

Das monopolistische Zuwendungs-„Raster“

Es muss sich nicht unbedingt um eine Verschwörung handeln. Es bedarf nicht irgendeines zentral gesteuerten Betrugs oder verdeckter Instruktionen. Stattdessen ist es das Fehlen von Zuwendungen an Alternativen, das ein Vakuum hinterlässt und systematisches Scheitern erzeugt. Die Kraft monopolistischer Förderung wirkt wie ein Rastersystem auf die Wissenschaft. Die Ergebnisse können in beide Richtungen weisen, aber die Förderung bedeutet, dass nur Ergebnisse von einer Seite der Gleichung „Zugkraft“ entfalten.

Gedanken, die die Rolle des Kohlenstoffs beim Klima in Frage stellen, werden mit einem feinen Kamm durch große Teams bezahlter Forscher durchgekämmt. Werden echte Irrtümer gefunden, werden sie laut und wiederholt verkündet; und falls es sich um irrelevante oder imaginäre Irrtümer handelt, werden diese auch verkündet, manchmal sogar mit noch mehr Lärm. Aber Gedanken, die die Rolle des Kohlenstoffs beim Klima stützen, sind Gegenstand einer ganz anderen Art der Analyse. Die im AGW-Team schauen nach, ob sie die Rolle des Einflusses von Kohlenstoff unterschätzt haben, oder befinden sich in einem so offensichtlichen Irrtum, dass es „das Team“ in eine peinliche Lage bringt. Da es nur eine kleine Anzahl von Forschern gibt, die die natürlichen Gründe untersuchen, oder Leute, die von der Verteidigung nicht kohlenstoffbasierter Gründe profitieren, gibt es niemanden, der a priori motiviert ist, intensiv nach nicht so offensichtlichen Fehlern zu suchen. Daher können die pro-AGW-Gedanken nur kurz eingehender untersucht werden sowie durch unbezahlte Ruheständler, auf Spenden angewiesene Blogger oder bei der Regierung angestellten Wissenschaftlern, die in anderen Bereichen arbeiten – wie z. B. Geologen, die allen Grund haben, skeptisch zu sein, die aber nicht notwendigerweise in, sagen wir, atmosphärischer Physik geübt sind.

Normalerweise ist das kein großes Problem, weil die Verlockung von Ruhm und Glück durch das kategorische Zersprengen eines weithin akzeptierten Gedankens für einige Leute attraktiv ist. In den meisten Bereichen der Wissenschaft werden diejenigen, die eine große Studie in Nature oder Science zerpflücken, plötzlich öfter zitiert; sind die Nächsten in der Reihe der Promotion und haben es leichter, Zuwendungen zu erhalten. Sie motivieren PhD-Studenten, ihnen zu helfen, werden eingeladen, auf mehr Tagungen zu sprechen und in der Programmfolge weiter nach oben gehievt. In der Klimawissenschaft dagegen besteht die Belohnung in persönlichen Angriffen auf Sites wie Desmog [21], ExxonSecrets [22] oder Sourcewatch [23]. Diese Sites wurden geschaffen, um jeden einzelnen Fehler zu jedem Thema aufzulisten, das sie bearbeitet haben, um Verbindungen anzuzeigen, die sie vielleicht mit der Industrie fossiler Energie gehabt haben könnten, wobei es keinen Unterschied macht, vor wie langer Zeit die jeweilige Arbeit erschienen ist, oder wie prekär. Diese Kampfhunde-Sites greifen auch Ihre religiösen Überzeugungen an, sofern Sie welche haben. Roy Spencer beispielsweise wurde wiederholt angegriffen, weil er Christ ist (allerdings hat bisher niemand einen Grund dafür genannt, warum das seine Satellitendaten beeinflussen könnte).

Ironischerweise werden die „aktivistischen“ Websites von bezahlten Bloggern betrieben. DeSmog ist ein bezahlter Ableger einer professionellen PR-Gruppe Hoggan und Associates [24] (welche bezahlt werden, um Kunden wie die David Suzuki Foundation, ethische Gruppen sowie Kompanien, die alternative Energiequellen wie Wasserkraft, Wasserstoff und Brennstoffzellen verkaufen, zu fördern) [25]. ExxonSecrets wird durch Greenpeace unterstützt [26] (die von Spenden leben, um den Planet zu „retten“ und die vermutlich besser dran wären, wenn der Planet wirklich Rettung brauchen würde).

In den meisten wissenschaftlichen Bereichen sucht man nach Antworten und versucht nicht, nur eine Seite einer Hypothese zu beweisen. Es gibt einige wenige Forscher, die bezahlt werden, um die Hypothese der globalen Erwärmung zu widerlegen, und die meisten davon werden einer Untersuchung unterzogen und an den Pranger gestellt, als ob sie sich wie ein Politiker auf offizielle Ämter bewerben. So funktioniert Wissenschaft nicht, durch persönliche Angriffe!

Die Einschüchterung, Respektlosigkeit und die Ausgrenzung und Ächtung, denen Menschen ausgesetzt sind, die renitente Fragen stellen, gleicht einem Akt der Zensur. Nicht viele Bereiche der Wissenschaft haben Wissenschaftlern schmierige Sites gewidmet. Geld zählt!

Der angesehene MIT-Klimatologe Richard Lindzen [MIT = Massachusetts Institute for Technology. A. d. Übers.] hat sich gegen den Druck ausgesprochen, mit den Wölfen zu heulen, und beklagt sich über den Verlust großer Forscher:

Leider ist dies nur die Spitze eines niemals schmelzenden Eisbergs. In Europa wurde Henk Tennekes als Forschungsdirektor der Royal Dutch Meteorological Society abgelöst, nachdem er die wissenschaftlichen Belege für die globale Erwärmung in Frage gestellt hatte. Aksel Winn-Nielsen, der frühere Direktor der Weltorganisation für Meteorologie (WMO) bei den UN wurde von Bert Brolin, erster Leiter des IPCC, als ein Werkzeug der Kohleindustrie gebrandmarkt, nur weil er den Klimaalarmismus in Frage gestellt hatte. Die angesehenen italienischen Professoren Alfonso Sutera und Antonio Speranza verschwanden 1991 aus der Diskussion, offensichtlich weil man ihnen die Förderungen strich, weil sie Fragen gestellt hatten.

Die Kombination von fehlender finanzieller Unterstützung plus eine garantierte voreingenommene Prüfung sowie Drohungen mit dem Verlust des Arbeitsplatzes würde ausreichen, um viele zu entmutigen, die sich der umstrittenen Seite des Feldes annehmen oder ihre Meinung frei aussprechen, wenn sie den „Glauben“ in Frage stellen.

Schließlich fehlt es den Freiwilligen und isolierten Forschern an Infrastruktur. Obwohl die Theorie des Main Stream einigen Verifikationen unterzogen wird, stehen den meisten Wissenschaftlern, die Fehler finden, keine bezahlten Teams von PR-Experten zur Verfügung, um zahlreiche Presseerklärungen zu veröffentlichen, oder die Stunden und Monate aufzuwenden, die erforderlich sind, um Studien in Magazinen zu veröffentlichen. Das heißt, wenn ein Fehler gefunden wird, würden das nur wenige außerhalb der Industrie mitbekommen.

Die monopolistische Fördermaschine stellt sicher, dass selbst unwichtige oder falsche Analysen von Faktoren, die das Klima antreiben, länger unterstützt werden können als sie sollten, während die wirklichen Probleme klein geredet, ignoriert und verzögert werden.

In einem so neuen Bereich wie der Klimawissenschaft können sich viele Dinge im Laufe von zehn Jahren ändern. Der Fortschritt zum Verständnis des planetarischen Klimas hat sich auf Schneckentempo verlangsamt.

Welche Motivation steckt dahinter zu beweisen, dass AGW falsch ist?

Wie viele Experten würden ihren Weg verlassen, um ihre eigene Expertise und Erfahrung weniger bedeutsam zu machen? Vor dem Hintergrund, dass die Förderung von dem Beweis abhängt, dass Kohlenstoff das Klima kontrolliert und damit die Klimawissenschaft selbst von entscheidender Bedeutung ist, ist es ein Kreislauf sich selbst sanktionierender Interessengruppen. Ja, schlaue Klimawissenschaftler können in anderen Bereichen beschäftigt werden. Aber wenn den Wählern plötzlich klar wird, dass Kohlenstoffemissionen nur eine geringe Rolle spielen und die Menschen nur einen kleinen Einfluss haben, würden Tausende Menschen bzgl. ihrer Arbeit etwas zu ändern haben, und Änderung ist schmerzhaft. In keiner Industrie ist es möglich, damit zu argumentieren, dass die Spezialisten es vorziehen würden, die halbe Förderung und den halben Status zu haben. Die meisten von ihnen würden auch bei der nächsten Gehaltserhöhung leer ausgehen, könnten ihre Arbeit verlieren oder zumindest Einiges von ihrer Kaufkraft. Sie bekommen nicht die verbesserte Ausrüstung, die sie sich wünschen, oder sie verlieren an Statur, weil, nun, Klimatologie „wichtig“ ist, aber da wir nicht das Wetter ändern können, laden wir ausgewiesene Experten nicht in unsere Komitees ein oder zu genauso vielen Konferenzen.

Man kann getrost davon ausgehen, dass die meisten Wissenschaftler ehrlich sind und hart arbeiten, aber selbst dann, wer würde sich darüber lustig machen, dass sie genauso viel Zeit und Mühe dafür aufwenden würden, AGW zu widerlegen, wie aufgewendet wird, AGW zu beweisen? Wenn ihre Reputation und ihre Förderung auf dem Spiel stehen, schwitzen und schaffen sie bis spät in die Nacht, um herauszufinden, warum sie recht haben und die anderen unrecht. Wettbewerb bringt auf beiden Seiten die Besten hervor.

Einige behaupten, dass sie dem wissenschaftlichen Prozess als solchen vertrauen, und dass sich die richtigen Antworten mit der Zeit herausstellen – was vermutlich stimmt. Aber wie John Maynard Keynes in seinem berühmten Ausspruch sagte: „Langfristig müssen wir alle sterben“. Es gibt bessere Wege, als auf das Nachleben zu warten. Verspätete Wissenschaft ist abgelehnte Wissenschaft.

Verlangsamung der Wissenschaft ist endlos fortgesetzte Propaganda [Science slowed is propaganda perpetuated].

Das „Wer-ist-schuld“-Spiel von Exxon ist ein ablenkender Nebenschauplatz

Viel Aufmerksamkeit in den Medien wurde schonungslos auf den Einfluss von „Big Oil“ konzentriert – aber die Zahlen rechnen sich nicht. Exxon Mobile wird nach wie vor verunglimpft [28], weil es angeblich über einen Zeitraum von etwa zehn Jahren um die 23 Millionen Dollar an Skeptiker des verstärkten Treibhauseffektes gezahlt haben soll. Das sind etwa 2 Millionen pro Jahr, verglichen mit den Ausgaben der US-Regierung in Höhe von etwa 2 Milliarden Dollar pro Jahr. Die gesamte von Exxon zur Verfügung gestellte Förderung beläuft sich auf weniger als ein Fünftausendstel des Wertes des Kohlenstoffhandels im Jahr 2008 allein.

Offensichtlich hat Exxon mit kaum 0,8% dessen, was die US-Regierung in jedem Jahr in die Klimaindustrie pumpt, die „Debatte sehr stark verzerrt“. (Falls das so sein sollte, ist es ein weiterer vernichtender Beweis dafür, wie effektiv die Förderung durch die Regierung wirklich ist).

Ein Beispiel zum Vergleich: Fast dreimal so viel wie das, was Exxon ins Spiel gebracht hatte, wurde in das Projekt zur Abscheidung von Kohlenstoff gesteckt [Big Sky Sequestration Project] [29], um gerade mal 0,1% des jährlich in den USA anfallenden Kohlendioxids in ein Loch im Boden zu pressen. Die australische Regierung ist der Förderung durch Exxon mit gerade mal einer Wohlfühlkampagne begegnet unter dem Motto „Denk ans Klima! Denk an die Änderung! [Think Climate! Think Change], (aber mach dir keine Gedanken über die Details)!

Hätte sich Exxon die gnadenlosen Angriffe vielleicht erspart, wenn es Geld sowohl pro als auch kontra AGW ausgegeben hätte? Vermutlich nicht, denn es hat mehr als viermal so viel ausgegeben für das Global Climate and Energy Project (GCEP) in Stanford [32, 33]. Das schwere Verbrechen von Exxon besteht offenbar darin, den Skeptikern überhaupt zu irgendeiner Stimme zu verhelfen. Die Zensur muss vollständig bleiben.

Die Gifterei gegen Exxon kam von 2005 bis 2008 auf Hochtouren. Umweltgruppen drängten auf einen Boykott von Exxon wegen deren Ansichten zur globalen Erwärmung [34]. Die Firma wurde als ein Feind des Planeten abgestempelt [35]. James Hansen machte sich dafür stark, die Vorstandsmitglieder fossiler Energiefirmen wegen schwerer Verbrechen gegen die Menschlichkeit und gegen die Natur anzuklagen. Im nächsten Atemzug nannte er Exxon.

Selbst die Royal Society, die eigentlich für Wissenschaftler offen sein und auch für einwandfreie Standards der Logik stehen sollte, stimmte in den Chor gegen Exxon mit ein und bat die Firma inständig, sich bei ihren Äußerungen zu mäßigen [to censor its speech] [37]. Der beispiellose Brief dieser 350 Jahre alten Institution listete vielfältige Appelle an die Behörden, nannte aber keinen einzigen empirischen Beweis, der die Behauptung, dass der Zusammenhang zwischen Kohlenstoff und Temperatur jenseits aller Diskussionen und Zweifel sei, gestützt hätte. Die Royal Society behauptet von sich, dass sie Wissenschaftler unterstützt, aber wenn sie sich auf die trügerischen Aussagen der Behörden verlässt, wie kann sie dann jemals die ‚Whistle blowers’ unterstützen, die definitionsgemäß die „Autoritäten“ in Frage stellen?

Während Exxon wiederholt dafür angegriffen wurde, diese unbedeutende Menge an Geld aufgewendet zu haben, gibt es nur wenige, die jemals die Zuwendungen pro AGW aufgelistet haben. Wo sind die Fragen stellenden Journalisten? Geld, das vom Steuerzahler kommt, ist irgendwie Ansporn, während jedwedes Geld von Big Oil in einem freien Markt der Ideen automatisch ein „Verbrechen“ ist. Die Ironie liegt darin, dass das Geld des Steuerzahlers sofort gewaltsam abgeschöpft wird*, während Exxon das Geld durch Tausende freiwilliger Transaktionen verdienen muss.

*Das ist keine Übertreibung! Versuchen Sie mal, „keine Steuern zu zahlen“! Anm. im Original!

Diejenigen, die Exxon wegen deren 2 Millionen Dollar pro Jahr angreifen, ziehen die Aufmerksamkeit ungewollt von den wirklichen Machtspielchen ab und agieren als unbezahlte PR-Agenten für riesige Handelshäuser und große Banken, die es durchaus aushalten mit etwas Unbequemlichkeit durch Grüne [greenies] und Umweltaktivisten. An anderen Tagen werfen einige dieser Gruppen Steine auf die Bankiers.

Der Nebenschauplatz der Schuldzuweisung an Big Oil verschleiert die Wahrheit: Dass es nämlich wirklich nur darum geht, ob es irgendeinen Beweis gibt, und dass die Skeptiker eine Basisbewegung sind mit sehr angesehenen Wissenschaftlern und einer wachsenden Zahl unbezahlter Freiwilliger.

Noch größeres Geld kommt ins Spiel

Vorbemerkung des Übersetzers zu diesem Abschnitt: Der ganze Aufsatz datiert vom Juli 2009 und bezieht sich auf die USA. Damals war dort der Traum vom großen Geld durch den Kohlenstoffhandel noch nicht ausgeträumt. Der folgende Abschnitt ist in dieser Hinsicht also überholt. Jedoch erscheint es sehr interessant, welche Träume selbst gestandene „Fachleute“ damals hatten und was davon übrig geblieben ist – vor dem Hintergrund, dass der Kohlenstoffhandel in den USA inzwischen nicht mehr existiert.

Finanzielle Rettungsaktionen und Steuernachlässe schlucken, was übrig ist.

Neue Provisionen der Förderung seit der Finanzkrise vom September 2008 sind in der obigen Tabelle nicht enthalten. Es ist schwierig, die Angaben strikt nach Finanzjahren zu trennen – und doch sind die Zahlen gigantisch und erreichen auf dem Graphen der Förderung potentiell die Skala sprengende Dimensionen.

Die Gesetzgebung zur finanziellen Erholung, die Präsident Bush am 3. Oktober 2008 unterzeichnet hatte [38] schloss das Gesetz zur Steigerung der Energieeffizienz und –ausweitung aus dem Jahr 2008 mit ein [39], in welchem etwa 17 Milliarden Dollar Steuergelder [40] für saubere Energien enthalten waren.

Dann, im Februar 2009, kam das 787 Milliarden Dollar teure Gesetz zur amerikanischen Erholung und Reinvestitionen [41], in dem um 110 Milliarden teure Investitionen [42] in saubere Energie enthalten sind. Viele dieser Investitionen trotzen einer einfachen Katalogisierung. Zum Beispiel ist die Forschung zu den alternativen Energien wertvoll, unabhängig davon, ob Kohlendioxid ein Problem ist oder nicht – obwohl es nicht so dringend ist. Aber Ausgaben in Höhe von 3,4 Milliarden Dollar zur Abscheidung von Kohlenstoff haben keine anderen Ziele oder Nutzen. Sie hängen zu 100% von der Hypothese ab, dass Kohlendioxid ein gefährlicher Luftverschmutzer ist.

Größer als die Große Regierung – Große Banken

Obwohl die Regierung während der letzten 20 Jahre etwa 70 Milliarden Dollar an Einfluss aufgewendet hat, verblasst diese Zahl im Vergleich mit der rasant wachsenden Kraft des Kohlenstoffhandels. Der Weltbank zufolge verdoppelte sich der Umsatz von 63 Milliarden im Jahre 2007 auf 126 Milliarden im Jahre 2008* [43].

Es ist keine Überraschung, dass die Banken das tun, was sie tun sollten: sie folgen dem Versprechen von Profiten und drängen daher die Regierungen, den Kohlenstoffhandel zu übernehmen [44, 45]. Obwohl sich Banken als gute und kooperierungswillige Mitbürger gerieren, finden sie den Gedanken einer nicht handelbaren Kohlenstoffsteuer als nicht ansprechend. Es könnte „dem Planeten helfen“, würde aber nicht ihren Bilanzen helfen.

Das Potential, das in einer völlig neuen verordneten Währung steckt, treibt Banken und Finanzinstitute „total unter eine Decke“ mit einer wissenschaftlichen Theorie [46].

Der 10-Billionen-Dollar-Gorilla in der Küche

Kommissionsmitglied Bart Chilton, Leiter des Beratungsgremiums für die Energie- und Umweltmärkte des Commodity Futures Trading Commission (CFTC), hat prognostiziert, dass der Kohlenstoffmarkt innerhalb der nächsten fünf Jahre jeden Markt marginalisieren wird, den seine Agentur derzeit reguliert: „Ich kann im Kohlenstoffhandel einen 2 Billionen-Dollar-Markt erkennen“ [47]. „Der größte Rohstoffmarkt der Welt“ [48]

Chilton entwirft folgende Perspektive: „Er würde nicht so groß sein wie einige der Finanzmärkte, aber er wäre größer als jeder echte Rohstoffmarkt“ [49].

Der in London ansässige Investitionsberater New Carbon Finance, der den Markt verfolgt, prognostiziert, dass der Kohlenstoffmarkt bis 2020 3 Billionen Dollar erreichen wird [50].

Richard L. Sandor, Vorsitzender und geschäftsführender Direktor von Climate Exchange Plc, dem die größte Kohlendioxidhandelsbörse gehört, sieht sogar einen noch größeren Markt:

„Wir werden einen weltweiten Markt bekommen, und Kohlenstoff wird eindeutig die größte nicht-kommerzielle Handelsware der Welt sein“. Er prognostiziert ein Handelsvolumen von insgesamt 10 Billionen Dollar pro Jahr [51].

Mit anderen Worten, der Kohlenstoffhandel wird größer als Öl, und selbst die Aussicht auf einen so massiven und lukrativen Markt repräsentiert ein wesentliches Interesse.

Wie Bart Chilton sagt: „Diese Angelegenheit ist so wichtig für unsere Wirtschaft und unsere Welt, dass wir es von Anfang an richtig anstellen müssen“.

Das „von Anfang an“ beginnt mit der Wissenschaft. Sollte es keinen Beweis dafür geben, dass wir [den Ausstoß von] Kohlenstoff einschränken müssen, gibt es keine Notwendigkeit, damit zu handeln.

Es steht und fällt mit dem Beweis

Selbst wenn die monopolistische Förderung die Wissenschaft beeinflusst wurde, sagt uns die Gesamtsumme Geldes, die an jede Seite gezahlt wurde, nichts darüber aus, ob sich das Klima der Erde wirklich erwärmt oder ob diese Erwärmung wegen des Kohlendioxids erfolgt.

Diese Studie möchte zum Ausdruck bringen, dass der wissenschaftliche Prozess (wie jedes menschliche Unternehmen) durch eine massiv einseitige Förderung durch Geld verzerrt werden kann.

Welchen Nutzen sollte das Geld haben, wenn es keinen Einfluss hätte?

Die Gefahr der Verzerrung im wissenschaftlichen Prozess bedeutet, dass wir uns strikt auf die Frage des Beweises konzentrieren müssen. Diese Studie ruft nach mehr Aufmerksamkeit, die man empirischen Beweisen zukommen lassen muss, und danach, Wege zu suchen, die Wissenschaft so zu motivieren, dass sie uns hilft zu entdecken, wie die Welt funktioniert, und zwar auf die bestmögliche und effizienteste Art und Weise.

Falls sich George Bush unwohl dabei gefühlt hatte zu unterschreiben, dass sich die USA an globalen Plänen zur Reduzierung von Kohlenstoffemissionen beteiligen würden, bestand sein vermutlich größter Fehler darin, nicht ein Institut zur Natürlichen Klimaänderung gegründet zu haben, das nach Beweisen für den Einfluss natürlicher Kräfte suchen sollte, und das die wissenschaftlichen Ergebnisse des IPCC sowie von Institutionen wie NOAA und NASA begutachten sollte.

Es fällt schwer sich vorzustellen, dass wir so viel Geld ausgeben, eine Hypothese zu untersuchen und kein Ergebnis erzielen. Monopolistische Förderung testet die Art und Weise, wie wir die Wissenschaft betreiben.

Es wird Zeit, ernsthaft die Wissenschaft zu begutachten, vor allem dann, wenn es um eine Wissenschaft geht, die riesige Regierungsprogramme und riesige Märkte rechtfertigen soll. Wer begutachtet das IPCC?

Alle Hervorhebungen, außer denen in eckigen Klammern, im Original!

Anhang

Autorin Joanne Nova

Übersetzt von Chris Frey für EIKE