Unsere Vorfahren hatten bis zum Ende des 18. Jahrhunderts für ihre Energieversorgung nur die Wahl Holz, oder Dung, oder Kohle aus Holz zu verbrennen. Der EROI betrug dabei 3 bis 5. Mit der Einführung von Kohle änderte sich das und der EROI stieg auf 20. Das bedeutet das Ende der Adelsherrschaft, bei denen 1 % der Bevölkerung reich und der Rest arm bis bitterarm war.

Plötzlich gab es eine Bürgergesellschaft.

Mit der Einführung von Gas und Öl stieg dieser EROI sogar auf 30 an. Was für viel, viel mehr Menschen mehr Wohlstand bedeutete, aber immer unter der Gesellschaftsordnung des Kapitalismus. Mit der Einführung der Kernenergie stieg dieser EROI auf 50 bis 100. Mithin eine der Energieversorgung, die das Energieproblem dieses Jahrhunderts mithelfen kann zu lösen.

Mit der Solar- und Windkraft hingehen befinden wir uns wieder bei 3-5. Ein unendlicher Rückschritt, hin zur Verarmung der Bevölkerung. Der folgend Beitrag des Physikers Dieter Böhme schreibt in einer Stellungnahme zum zum Entwurf des 2. Sachlichen Teilplans Windenergie – Mittelthüringen an das Thüringer Landesverwaltungsamt Referat 300 Regionale Planungsstelle Mittelthüringen, und erklärt darin, warum das so ist

Von Dieter Böhme

Thüringer Landesverwaltungsamt

Referat 300 Regionale Planungsstelle Mittelthüringen

Jorge- Semprún-Platz 4

99423 Weimar

Per Mail an: teilplan.wind@tlvwa.thueringen.de

Stellungnahme zum Entwurf des 2. Sachlichen Teilplans Windenergie – Mittelthüringen

Sehr geehrte Damen und Herren,

es gibt viele gute Gründe den weiteren Ausbau der Windkraft abzulehnen. Einerseits sind dies die exorbitanten Schäden an der Umwelt und für die Gesundheit der Menschen durch die Windkraft sowie andererseits die Naturgesetze der Physik, nach denen ein Industrieland wie Deutschland nicht mit Strom und Primärenergie (Strom, Verkehr, Heizwärme, Industriewärme) aus volatilen Stromerzeugern versorgt werden kann. Und auch nicht aus einem „Mix“ der sogenannten Erneuerbaren Energien. Dies ist übrigens ein Euphemismus, denn Energie ist nicht „erneuerbar“, sie kann nur von einer Form in eine andere Form überführt werden. Und dies immer unter spezifischen Wirkungsgrad-Verlusten.

Mit Bezug auf die Flächenplanung für Windkraft zeigen sich krassen Differenzen des 2,2 % – Zieles und staatlicher Studien mit Leistungsdichten von 20 – 30 W/m2 die im Gegensatz zur ermittelten Realität von etwa 2 – 0,5 W/m2 stehen (S. 4: MDR, MPI). Dies sollten Fachleute für Flächenplanung klären, bevor man beginnt, bislang unberührte Natur für Windkraft zu verplanen. Bis zur Klärung wird ein Moratorium für jegliche Planung und Realisierung von Windkraft vorgeschlagen.

Abstract – die unbequeme Wahrheit zusammengefasst

Mit Windkraft kann pro Quadratmeter Rotorfläche etwa eine Glühbirne (ca. 40 Watt) rund um die Uhr betrieben werden, falls man den Strom denn speichern könnte, was angesichts der schieren Dimension nicht geht. Denn ein Tag Stromerzeugung entspricht etwa der Kapazität von 200 Pumpspeichern Goldisthal oder 17 Mio. E-Autos mit großem 100-kWhAkku. Dunkelflauten (ohne Sonnenschein und Wind) können Wochen dauern. Dies ist umso gravierender, als die gesicherte Leistung der Windkraft nahe NULL ist. Die WasserstoffTechnologie zur Speicherung von Strom ist eine Illusion. Sie wandelt wertvollen, universell einsetzbaren Strom in minderwertigere chemische Bindungsenergie (des H2-Moleküls), die im großtechnischen Maßstab über Wärmekraftmaschinen mit niedrigem Wirkungsgrad wieder in elektrische Energie gewandelt werden muss. Dies verteuert den „gespeicherten“ Strom unter großen Verlusten mindestens um den Faktor 5. Die Ursache für die geringe

Leistung der Windkraft pro Quadratmeter Rotorfläche ist die geringe Dichte der Luft. Die Ursache für die hohe Volatilität ist die Abhängigkeit der Windleistung von der dritten Potenz der Windgeschwindigkeit. Die durchschnittliche Leistungsdichte der Windkraft, quer über die Verteilung der Windgeschwindigkeiten liegt in der Größenordnung etwa 40 W/m2

Rotorfläche. Dies bedingt etwa 1 Mrd. Quadratmeter Rotorfläche, für 40 GW Leistung (etwas über die Hälfte der max. Stromlast) oder ca. 5 Mrd. Quadratmeter Rotorfläche für die Hälfte einer Energiewende, da Strom nur etwa 20 % der Primärenergie ausmacht. Diese geringe Leistungsdichte verursacht den gigantischen Flächenbedarf der Windkraft in der Landschaft, und macht unsere Kulturlandschaft zu einem Elektrizitätswerk. Daran ändern auch immer größere Windräder nichts, denn sie brauchen nicht nur größere Abstände, sondern sie „klauen sich“ auch in immer größeren Höhen gegenseitig den Wind. Windkraft kannibalisiert sich mit zunehmendem Ausbau quasi selbst. Denn die Limitierung für den großflächigen Ausbau der Windkraft ist die, der Atmosphäre max. entnehmbare Leistung und diese tendiert von 2 W/m2 zu 0,5 W/m2 Landschaftsfläche. Bereits heute wird der Atmosphäre über Deutschland durch Windkraft eine Energie entnommen, die dem Äquivalent von etwa 7.900 Hiroshima-Bomben entspricht. Dies führt zu einer Beeinflussung des Mikroklimas und zu einer Austrocknung und Erwärmung der Landschaft im Lee von Windparks. Da der physikalische Wirkungsgrad von Windrädern (0,48 für Dreiflügler) de facto (bei der jeweils häufigsten Windgeschwindigkeit) erreicht ist, erübrigt sich eine Diskussion zum angeblich großen Entwicklungspotential von Windrädern. Diese können nur noch größer werden, was aber kaum etwas an der Leitungsdichte ändert. All dies ist physikalisch bestimmt und kann durch keine ingenieurtechnische Leistung überboten werden. Das Perpetuum Mobile kann durch keinen Koalitionsvertag, keinen Parlamentsbeschluss und keinen Gerichtsentscheid herbeigeführt werden. Wohl aber ein riesiges wirtschaftliches und gesellschaftliches Desaster, wenn eklatant gegen Naturgesetze verstoßen wird. Dabei spielt es keine Rolle, ob dies mit gutem Vorsatz, aus Unkenntnis oder aus Absicht geschieht. Keiner der Verantwortlichen möge sagen „Wenn ich das nur gewusst hätte“. Hier steht es nachvollziehbar zur Diskussion gestellt.

Windkraft ist ein Kampf gegen die Physik – die Herleitung des „Unsagbaren“ Die elektrische Leistung eines Windrades pro Quadratmeter Rotorfläche (Leistungsdichte) wird durch die Dichte der Luft und die dritte Potenz der Windgeschwindigkeit bestimmt sowie durch den max. physikalischen Wirkungsgrad begrenzt.

Die Formel lautet: Pd = ½ ρ v3 h

(Pd – Leistungsdichte, ρ – Dichte der Luft, v – Windgeschwindigkeit, h – Wirkungsgrad) Der max. physikalische Wirkungsgrad h beträgt 0,48 für Dreiflügler. Physik der Windturbine – Uni Leipzig, Physikalisches Institut https://home.uni-leipzig.de/energy/energie-grundlagen/15.html

Die geringe Dichte der Luft (ρ =1.225 kg/m3 bei 15 C in Meereshöhe) stellt die grundsätzliche physikalische Limitierung der Windkraft dar. Sie ist 816-fach geringer als die Dichte von Wasser, wobei der max. Wirkungsgrad der Windkraft etwa nur halb so groß ist, wie der einer Wasserturbine. Die geringe Dichte der Luft ist der Grund für die riesige Anzahl von Windrädern, was in der Konsequenz Milliarden Quadratmeter Rotorfläche bedingt.

Die praktischen Konsequenzen dieser einfachen physikalischen Zusammenhänge sind: Bei einer üblichen Nennwindgeschwindigkeit von 11 m/s (Beginn Windstärke 6) für Schwachwindanlagen (für das Binnenland) beträgt die auf den Rotor pro Quadratmeter aufgebrachte Windleistung 815 W/m2. Davon können (bei Wirkungsgrad 0,48) max. 391 W/m2 in elektrische Leistung umgesetzt werden. Dies ist bei Schwachwindanlagen aber nicht der Fall, da deren max. Wirkungsgrad nicht bei 11 m/s, sondern bei der lokal häufigsten Windgeschwindigkeit liegt. Eine Herstellerangabe für die Leistungsdichte einer Schwachwindanlage bei Nennwindgeschwindigkeit von 11 m/s lautet zum Beispiel 199 W/m2.

Datenblatt Siemens SWT-3.15-142

Der max. Wirkungsgrad ist bei Schwachwindanlagen konstruktiv auf die lokal häufigsten Windgeschwindigkeiten (5 bis 8 m/s) festgelegt. Hierbei können max. elektrische Leistungen zwischen 37 bis 151 W/m2 generiert werden. Dies ist unabhängig von der Größe des Windrades. Weitere Informationen – Windkraft erklärt auf einem Bierdeckel

In Thüringen wird zur Festlegung regionaler Teilflächenziele eine durchschnittliche Mindestwindgeschwindigkeit von ≥ 6,5 m/s in einer Höhe von 150 m über Grund angenommen. Bei dieser Windgeschwindigkeit können bestenfalls 77 W/m2 elektrische Leistung generiert werden. Quelle: Herleitung der regionalen Teilflächenziele zur Umsetzung des

Flächenbeitragswerts gemäß dem Wind-an-Land-Gesetz in Thüringen)

Diese Zahlen machen deutlich, dass, entgegen den möglichen Erwartungen, die Windkraft nur über ein geringes Potential zur Stromversorgung verfügt. Es sind allein die schiere Größe und Anzahl der Windräder sowie die damit einhergehende Nennleistung von Megawatt, die beeindrucken. Die Wenigsten wissen wohl, dass diese nur bei Windstärke sechs aufwärts erreicht wird, und dass bei halbem Wind jeweils nur noch 1/8 der ursprünglichen Windleistung dem Rotor zur Verfügung steht. Damit ist es nicht verfehlt, die Windkraft mit einer Herde dürrer Kühe zu vergleichen, der mittels verbesserter Melkmaschinen immer mehr Milch abgepresst werden soll. Bei verstärktem Ausbau sinkt zudem die Leistungsdichte der Windkraft von 2 bis auf 0,5 W/m2 Landschaftsfläche. Quelle:

MDR: NEUE STUDIE AUS JENA: DAS POTENZIAL UND DIE GRENZEN DER WINDKRAFT

Fachartikel: Physical limits of wind energy within the atmosphere and its use as renewable energy: From the theoretical basis to practical implications

Eine Bespielrechnung verdeutlicht die Größenordnung der Konsequenzen. Bei 1 W/m2 wäre auf der gesamten Fläche von Deutschland (ca. 360.000 km2) eine mittlere elektrische Leistung von 360 GW durch Windkraft generierbar. Dies wäre in etwa die Größenordnung für eine Energiewende (mit dem Fünffachen einer Stromlast von 72 GW. Und zwar ohne den Strom speichern zu können. Mit der Wasserstoff-Technologie gingen, aufgrund des geringen Wirkungsgrades, von angenommenen 100 GW mindestens 80 GW in Form von „Abwärme“ verloren. Quelle: Leibnitz-Institut, Dr. Ulf Bosselt Wasserstoff löst keine Energieprobleme

Bei einer Leistungsdichte von 0,5 W/m2 wären 180 GW generierbar, für eine „halbe“

Energiewende. Damit wäre die Atmosphäre „abgemolken“ und Deutschland stünde voller Windräder. Wohlgemerkt bei einer gesicherten Leistung nahe NULL. Eine andere Rechnung, unter der Annahme einer mittleren Leistungsdichte von 40 W/m2 Rotorfläche, was 1 Mrd. Quadratmeter Rotorfläche für ca. die Hälfte Strom (ca. 40 GW) und 5 Mrd. Quadratmeter Rotorfläche für die Hälfte einer Energiewende bedingt, zeigt das Folgende. Unter der Annahme von Windrädern mit einem Rotordurchmesser von aktuell 170 m (22.700 m2 Rotorfläche, Gesamthöhe ca. 250 m) wären 220.000 Windräder notwendig. Dies wären auf ganz Deutschland verteilt 1,6 km2 pro Windrad oder alle 1,2 km ein Windrad.

Oder unter der Annahme von Windrädern mit einem Rotordurchmesser von 200 m (31.400 m2 Rotorfläche, Gesamthöhe ca. 300 m) wären 160.000 Windräder notwendig. Dies wären auf ganz Deutschland verteilt 2,25 km2 pro Windrad oder alle 1,5 km ein Windrad. Man kann einwenden, dass größere Windräder höhere Windgeschwindigkeiten in größeren Höhen nutzen können und damit die Leistungsdichte pro Quadratmeter Rotorfläche steigt. Dies mag für ein einzelnes Windrad zutreffen, jedoch nicht für den Ausbau der Windkraft, da sich immer größere Windräder in immer größeren Höhen den Wind „klauen“, wie o.g. der MDR gemäß MPI-Jena festgestellt hat. Die Grenzen der Windkraft bestimmt nicht Wunschdenken, sondern die Physik. Bereits jetzt wird der Atmosphäre über Deutschland eine Energie entzogen, die dem Äquivalent von etwa 7.900 Hiroshima-Bomben entspricht. Die Rechnung findet sich hier auf S. 11) Woher kommt der Strom – die Grenzen der Erneuerbaren

Die gigantische Entnahme kinetischer Energie des Windes bleibt nicht ohne Folgen für die jeweiligen Mikroklimata (und nur solche existieren real). Im Lee von Windparks gibt es eine Austrocknung und Erwärmung der Landschaft, infolge der Verwirbelung von, nachts in Bodennähe befindlichen, kühlen und feuchten Luftschichten. Dies haben Studien der Harvard University unter Beteiligung des MPI für Bio-Geochemie Jena, mittels Messungen durch Satelliten an großen Windparks im Mittleren Westen der USA ergeben. Die Autoren sind übrigens glühende Verfechter der Windkraft. Climatic Impacts of Wind Power

Windräder können nur Strom erzeugen, wenn sie der strömenden Luft kinetische Energie entziehen, was zu einer Verringerung der Windgeschwindigkeit führt. Physik der Windturbine

Der beobachte weltweite Effekt der Verringerung der Windgeschwindigkeit wird als „Global terrestrial stilling“ bezeichnet, wobei polit-medial vermieden wird, auch die Windkraft als Ursache zu nennen. Physikalisch ist klar, dass eine Verringerung der Windgeschwindigkeit zu einer Verringerung des Haltedrucks in der Atmosphäre und damit zur Regenbildung führt. Hier meine Berechnungen (s. S. 10) Woher kommt der Strom – die Grenzen der Erneuerbaren

Das Abregnen der Wolken aus Hauptwindrichtung erfolgt bereits im Lee der Windparks auf See oder an der Küste, der Regen fehlt dann im Binnenland, so dass dort die Landschaft austrocknet. Da dies dem polit-medialen Narrativ vom „Klimaschutz“ entgegensteht, wird Forschung zu diesem Thema nicht gerade wohlwollend mit staatlichem Fördergeld bedacht, um es diplomatisch auszudrücken. Stattdessen ist der Ruf nach dem weiteren Ausbau der

Windkraft zwecks „Klimaschutz“ zu vernehmen, einem Multi-Milliarden-Geschäftsmodell

(ca. ab 59:00) Energie Wende oder Energie Ende

Zusammenfassung zum 2,2 % Ausbauziel

Die genannten Beispiele stehen im krassen Widerspruch zum Ausbauziel von 2,2 % der Landesfläche. Auf die „wundersamen Rechnungen“ des Erfurter Energieministeriums mit Nennleistung hatte ich bereits in meiner Stellungnahme vor einem Jahr hingewiesen. Man kommt in Erfurt mit der Rechnung: 970 WEA * 5 MW = 4.850 MW = 4,85 GW auf eine Leistung, ohne diese in Relation zum realen Nutzungsgrad (Volllaststunden) zu setzten (S. 4). Stellungnahme zur Änderung des Landesentwicklungsprogramms Thüringen Abschnitt 5.2 Energie

Betrachte man die zugrunde liegenden Studien, so findet man Angaben zu den Leistungsdichten in Bezug auf die Landschaft zwischen 20 – 30 W/m2 (20 – 30 MW/km2). Dies ist, verglichen mit den o.g. neuesten Erkenntnissen des Max-Planck-Instituts für Bio- Geochemie in Jena zusammen mit der Harvard University, resultierend aus Studien an großen Windparks in den USA, etwa um den Faktor 10 bis 60 zu hoch, verglichen mit den durch Studien in den USA ermittelten 2 – 0,5 W/m2. Damit sind die politisch ausgewiesenen Flächenziele um mindestes eine Größenordnung (> Faktor 10) zu niedrig angesetzt. Wer sagt den Bürgern, dass die 2,2 % erst der Anfang sind, nach deren Realisierung man feststellen wird, dass dies alles in keiner Weise ausreicht? Vom Speicherproblem ganz abgesehen.

Es scheint, als ob sich gewisse optimistische Grundannahmen durch sämtliche Studien ziehen, auch weil man sich immer wieder auf eine Studie des Bundesverbandes WindEnergie beruft. Bundesverband Windenergie: Potenzial der Windenergienutzung an Land, Kurzfassung In dieser Studie wird mit 240.562 Windrädern für 722 GW auf einer Fläche von 28.116 km2 gerechnet, was 8 % der Fläche von Deutschland entspricht und bedeutet, dass auf diesen 28.116 km2 rein rechnerisch alle 340 m ein Windrad steht und sich eine Leistungsdichte von 25,7 W/m2 (25,7 MW/km2) ergibt. Für mich stellt sich dies so dar, als dass der Begriff „installierbare Leistung“ (Nennleistung) mit der real durch ein Windrad generierbaren (mittleren) Leistung gleichgesetzt wird. Doch die reale mittlere Leistung beträgt bei 1.750 Volllaststunden (von 8.760 Jahresstunden) nur 20 % der Nennleistung (installierbaren Leistung). Auch das Erfurter Energieministerium rechnet mit einer Leistungsdichte von 300 kW/ha (30 W/m2 = MW/km2), wie der Antwort auf eine kleine Anfrage von Nadine Hoffmann (AfD-Fraktion) zu entnehmen ist. Damals noch für 1 % der Landesfläche. Aktueller Stand von Windkraftanlagen, Repowering und Windvorranggebieten in Thüringen

Eine Studie im Auftrag des Thüringer Ministerium für Umwelt, Energie und Naturschutz kommt auf eine Leistungsdichte von 23,4 W/m2.

Leipziger Institut für Energie, Metastudie: Potenziale Vorranggebiete Wind

Mit Bezug auf die Flächenplanung für Windkraft zeigen sich krassen Differenzen des 2,2 % – Zieles und staatlicher Studien mit Leistungsdichten von 20 – 30 W/m2 die im Gegensatz zur ermittelten Realität von etwa 2 – 0,5 W/m2 stehen (s. o. MDR, MPI). Dies sollten Fachleute für Flächenplanung klären, bevor man beginnt, bislang unberührte Natur für Windkraft zu verplanen. Bis zur Klärung wird ein Moratorium für jegliche Planung und Realisierung von Windkraft vorgeschlagen.

Strom – das sind keine Äpfel oder Einkellerungskartoffeln

Oft hört man aus Politik und Presse, Strom solle regional erzeugt und verbraucht werden und die „Erneuerbaren“ würden schon so und soviel Prozent der Stromversorgung ausmachen. Solche Vorstellungen von Elektrizität scheinen, mit Verlaub, aus der Landwirtschaft oder dem Obstbau zu stammen? Dies ist nicht verwunderlich, da in Sachen Stromversorgung jeder, gemäß seinen Wunschvorstellungen, mitreden darf, unabhängig davon, ob dafür eine hinreichende Qualifikation nachgewiesen werden kann. Dies steht übrigens im krassen Gegensatz zum Meisterbrief, der für die Ausübung eines Handwerks erforderlich ist. Dieser Umstand sei deshalb erwähnt, da unsere Stromversorgung nichts Geringeres ist, als der Lebensnerv der Wirtschaft und des Landes. Eine Woche ohne Strom stürzt eine Gesellschaft ins Chaos und zwei Wochen ohne Strom ins Mittelalter. Aber jeder darf mitreden.

Insofern sollte nicht unerwähnt bleiben, dass, die durch „Erneuerbare“ erzeugte Energie kein Maßstab sein kann. Erstens haben diese Vorfahrt durch Vorrangeinspeisung und zweites ist es egal, ob gestern viel Windstrom erzeugt wurde und morgen viel Solarstrom erzeugt wird, wenn heute weder der Wind weht noch die Sonne scheint. Dann ist die Leistung dieser beiden gleich NULL und die erzeugte Energie auch (Energie = Leistung * Zeit). Auch sollte man sich von der offenbar faszinierenden Vorstellung verabschieden, man könne den Strom von einem bestimmten regionalen Erzeuger zu einem bestimmten Verbraucher liefern. Strom, dies sind elektromagnetische Felder welche Elektronen im Draht bewegen, die einer Potentialdifferenz (Spannung) folgen und nicht dem Wunsch von Kaufleuten. Dies sei nur deshalb erwähnt, um deutlich zu machen, dass es andere, viel wichtigere Kriterien gibt, über die nicht geredet wird, und bei denen gefragt werden muss, inwiefern Windkraft diese überhaupt erfüllen kann. Da wäre zunächst die Schwarzstartfähigkeit, zu welcher Windräder nach einem Blackout nicht in der Lage sind, da jedes von ihnen Strom aus dem Netz ziehen, oder mit Notstrom versorgt werden muss, um Elektrik und Mechanik für die Verstellung der Rotorblätter zu versorgen. Außerdem brauchen deren Wechselrichter einen Taktgeber zur synchronen Einspeisung in das Netz. Dies sind die konventionellen, synchron laufenden Kraftwerke die durch Windkraft ersetzt werden sollen. Weiter seinen nur Stichworte genannt, um aufzuzeigen, dass Stromversorgung komplexer ist als über den Anteil von Energie zu reden. Dies wären, Frequenzhaltung (50 +/- 0,2 Hz), phasensynchrone Einspeisung, positive und negative Regelleistung, Blindleistung und Sekundenreserve. Als letztere dienen die Turbinensätze und Generatoren welche die Netzfrequenz dank ihrer schweren rotierenden Massen bei abrupten Lastwechseln im Netz für Sekunden in Grenzen hält, bis weitere Regelmaßnahmen greifen. All diese Systemdienste können nicht oder nur eingeschränkt von Windrädern ausgeführt werden. Auch daran sollte einen Gedanken verschwenden, wer über Windkraft redet. Vieles davon trifft übrigens auch auf Photovoltaik zu.

Die zunehmende Destabilisierung des Stromnetzes erkennt man an der Anzahl und den Kosten für ungeplante Regeleingriffe (Redispatch). Diese beliefen sich 2022 auf 2.69 Mrd. EUR. Dies ist eine Steigerung um 2.345 % (in Worten Zweitausend-DreihundertFünfundvierzig Prozent) gegenüber 2013. Steigende Kosten durch Redispatch Zu weiteren Informationen über die Grenzen der Physik auch der anderen „Erneuerbaren“ dient mein Fachartikel. Woher kommt der Strom – die Grenzen der Erneuerbaren

Infraschall – die unhörbare Gefahr

Mit Infraschall von Windrädern macht es sich die Politik ganz einfach. Das Vorsorgeprinzip (GG Artikel 2/2) wird ausgehebelt, indem erklärt wird a) es gäbe keine Studien, die eine Gefahr belegen würden und b) es gäbe auch Infraschall aus anderen Quellen, wie Verkehrslärm und Blätterrauschen. Zitiert wird dabei gern eine Studie der LUBW aus 2016. Darin wurden Schalldruckpegel im Bereich 1 – 80 Hz bis ca. 75 dB gemessen und mit anderen Schallquellen verglichen, und daraus geschlossen, dass (Zitat) „Auswirkungen durch Infraschall von Windkraftanlagen nach den vorliegenden Erkenntnissen nicht zu erwarten sind.“ Doch heißt, dem Stand der damaligen Messtechnik und Bewertungskriterien (also nach den vorliegenden Erkenntnissen) entsprechen etwas nicht zu „erwarten“ gerade nicht, dass dies „auszuschließen“ ist. Damit wird dem Vorsorgeprinzip nicht Genüge getan. Auch wurden keine weiteren Studien an größeren Windrädern nach „neuesten“ Erkenntnissen durchgeführt. Man ging von einer „Wahrnehmungsschwelle“ aus. Für akustischen Schall (20 Hz -20 kHz) ist das menschliche Ohr der „Empfänger“. Doch Infraschall (etwa < 20 Hz) kann das menschliche Ohr nicht hören. Folgt man der Argumentation, „wenn man etwas nicht hören kann, kann es nicht gefährlich sein“, so müsste man auch Radioaktivität als ungefährlich betrachten, weil man sie mit keinem Sinnesorgan wahrnehmen kann. Dies würde jeder als absurd bezeichnen, nur beim Infraschall wird „Wahrnehmung“ mit „Hören“ gleichgesetzt. Dabei ist der Begriff „Wahrnehmung“ nicht auf die bekannten menschlichen Sinnesorgane beschränkt und auch nicht auf die von Tieren. Denn „Wahrnehmung bezeichnet jenen Aspekt des psychischen Geschehens und Erlebens, der sich auf die Kopplung des Organismus an funktional relevante Aspekte der physikalischen Umwelt bezieht. Hierzu gehören nicht nur die haptische, visuelle, auditive, ……Wahrnehmung.“ Man macht es sich mit dem Thema Infraschall sehr einfach, wenn es um Windräder geht, die einem politischen Narrativ folgen und für die es milliardenschwere Geschäftsmodelle gibt.

Doch was sind die neuesten Erkenntnisse, nach denen man Studien ausrichten sollte? Zum einen sind es Windräder mit größeren Rotoren, die größere Druckstöße bei niedrigeren Umdrehungszahlen und damit niedrigeren Frequenzen bei 1 Hz und darunter verursachen. Zum anderen ist es die spitze Form der Druckimpulse (hier im Frequenzbereich < 20 Hz), die zwangsläufig Oberwellen (vielfache Harmonische der Grundfrequenz) erzeugen. Diese bestimmen das Klangbild welches nicht mit simplen Druckmessgeräten erfasst werden kann, weil dazu neben Frequenzfiltern zur Unterdrückung von Hintergrundrauschen auch eine Fourier-Analyse des Messsignals notwendig ist. Jeder Elektrotechniker kennt dies von Impulsformen, die keine Sinusfunktionen sind.

Allein aus gesundem Menschenverstand ergibt sich die Frage, ob der Schalldruck (in dB) das alleinige Kriterium, sein kann? Wirkt nicht eine quietschende Tür oder ein tropfender Wasserhahn trotz niedrigerem Schallpegel weitaus störender, als ein Blätterrauschen? Wäre es nicht angemessen, außer dem Schalldruck auch das „Klangbild“ (Frequenzspektrum) des Infraschalls zu prüfen? Man kann bei offenem Fenster und Meeresrauschen gut schlafen, nicht aber bei einem tropfenden Wasserhahn, obwohl der Schallpegel hier viel geringer ist. Verkehrslärm, Blätterrauschen und Meeresrauschen erzeugen diffusen Infraschall, während Windräder periodischen Infraschall inkl. Oberwellen erzeugen, dies ist der wesentliche Unterschied.

Es gibt aktuell ein weiteres beliebtes Argument, welches den Windkraft-Gegnern medial entgegenschlägt. Dies ist ein Rechenfehler in einer Studie der BGR (Bundesanstalt für Geowissenschaften und Rohstoffe Hannover). Nur ging es in dieser Studie mit keinem Wort um Gesundheitsschutz vor Infraschall, sondern um den Schutz von Geräten zur Detektion von Kernwaffentests, für welche die BGR in ein weltweites Messnetz eingebunden ist. Der Rechenfehler wirkte sich so aus, dass er keine Auswirkungen auf den Mindestabstand von Windrädern zu den Messstationen der BGR hatte. Doch wird dieser Fehler nun den GegenWind BI vorgehalten. Dies leider auch vom ÖR-Rundfunk, was dessen Auftrag zur allseitigen Berichterstattung widerspricht. Dabei wird sich ausschließlich auf Messungen des Schalldruckes bezogen. Windkraft-Gegner haben keine Lobby, schon gar nicht beim ÖRR.

Fazit: Dem Freistaat Thüring wird vorgeschlagen, Studien unter den o. g. Aspekten in Auftrag zu geben, um seine Bürger und die gesamte Umwelt vor Infraschall zu schützen. Denn auch Flora und Fauna sind Infraschall ausgesetzt. Und um diese Folgen hat sich wohl noch niemand gekümmert? Zumindest einen Hinweis könnten die Probleme mit getöteten Pelztieren in der Nähme von Windrädern Dänemark geben. Das Vorsorgeprinzip gilt für Mensch und Natur.

Windkraft – ein ökologisches Desaster

Wurden bisher die Gesundheitsgefahren durch Windkraft für Menschen allein in Bezug auf hörbaren Schall bewertet und Tiere hatten (so zynisch es klingt) noch einen gewissen „Vorrang“, so fährt nun, eine von der Gesetzgebung in Gang gesetzte, „Dampfwalze“ über die Landschaft. Nichts scheint mehr „heilig“, nichts ist unmöglich, um die Windkraft mit Brachialgewalt an jeden Ort, einschließlich in den Wald zu bringen. Getötete Flugtiere, ca. 1000 Tonnen an den Rotoren klebende Insekten (gem. Studie DLR), von den Fundamenten durchstoßene Grundwasserschichten, die Rodung ganzer Waldflächen einschließlich Berggipfeln, Tausende Tonnen Stahlbetonfundament je Windrad, Schall und Infraschall im Wald ohne Rücksicht auf Flora und Fauna, wohl in Unkenntnis der komplexen ökologischen Zusammenhänge und deren Folgen. Tausende Tonnen Abrieb von Mikro- und Nanoplastik von den Rotoren mit anhaftender „Ewigkeitschemikalie“ BPA (Bisphenol A) und die Verwendung der „Ewigkeitschemikalie“ SF6 (Schwefelhexafluorid) in den elektrischen Schaltanlagen. Ungeklärte Fragen zu Rückbau und Entsorgung, wie der Fundamente oder der Rotorblätter. Massive Entnahme von kinetischer Windenergie aus der Atmosphäre, Austrocknung und Erwärmung der Landschaft – und dies alles unter dem Marketing-Begriff „Erneuerbare Energie“ für „Ökostrom“.

Windkraft braucht keinen Vergleich zu scheuen, wenn es um die ökonomische Zerstörung einer Volkswirtschaft und um die umfassende ökologische Zerstörung der Natur und Kulturlandschaft geht.

All dies ist nur mit gebetsmühlenartiger Propaganda (= einseitige Information) Pro Windkraft möglich. Das ganz große Narrativ ist die Rettung vor der vorgeblichen Klima-Katastrophe durch Verringerung von CO2-Emissionen mittels einem ominösen 1,5-Grad-Ziel. Dabei reicht ein Blick in das Pariser-Klimaabkommen, um den ganzen Schwindel zu begreifen. Denn dieses unterscheidet entwickelte Länder (wie Deutschland) und Entwicklungsländer (wie lt. UN, China und Indien). Das Pariser-Klima-Abkommen

Artikel 4/4: “Developed country parties should continue taking the lead by undertaking economy-wide absolute emission reduction targets. Developing country Par2es should continue enhancing their mitigation efforts, and are encouraged to move over time towards economy-wide emission reduction or limitation targets in the light of different national circumstances.”

Zunächst wird hier zwischen Industrieländern (Developed country parties) und Entwicklungsländern (Developing country parties) unterschieden. Industrieländer (wie Deutschland) sollen Ziele formulieren, um ihre Emissionen (in absoluten Zahlen) zu senken. Entwicklungsländer (China, Indien, usw.) werden „ermutigt“, ihre Anstrengungen zu erhöhen, um entspr. ihren „nationalen Umständen“ und „mit der Zeit“, ihre Emissionsziele zu senken. Dafür erhalten sie übrigens aus einem 100-de Mrd. Fond Geld, in den Industrieländer (wie Deutschland) einzahlen. Mit anderen Worten, Deutschland betreibt „Klimaschutz“ wegen einer angeblich drohenden „Klimakatastrophe“ und senkt seine CO2-Emissionen (von ca. 0,7 Gt/a), während China seine CO2-Emissionen von ca. 11 Gt/a erst mal erhöhen kann. Um dann mit der Zeit und entspr. der Umstände seine Ziele zu senken. Und so kann China fast jede Woche ein neues Kohlekraftwerk in Betrieb nehmen und 300 Kohlekraftwerke auf dem Globus bauen, wozu die selbsternannten „Klimaschützer“ schweigen. So unmittelbar ist also die Bedrohung durch eine vorgebliche Klima-Katstrophe, dass weltweit Maßstäbe angelegt und Maßnahmen durchgeführt werden sollen, die im Vergleich absurder nicht sein könnten. China baut 300 neue KohlekraJwerke auf dem Globus – und die Klimaschützer schweigen

In Deutschland klebt sich der grüne Nachwuchs in der Vorstellung, die „Letzte Generazon“ zu sein, an die Straße. Gern gesponsert auch on Aileen Ge|y, der Erbin des Getty-Öl-Imperiums. Amerikanische Öl-Milliardärin finanziert Klimaradikale in Deutschland

Währenddessen baut China nicht nur Kohlekraftwerke, sondern auch Kernkraftwerke und kann, wenn die Kohlekraftwerke in Jahrzehnten abgeschrieben sind, damit ggf. seine CO2Emissionen in aller Ruhe senken. China approves construcNon of six new reactors Auf diese Weise profitiert China von der „Klima-Katastrophe“, indem es (unter hohen CO2 Emissionen) Roheisen und Stahl für deutsche Windräder produziert, die dann in Deutschland die „CO2-Bilanz“ viel besser „gestalten“. Denn der Stahl wird woanders produziert, und man kann deshalb verkünden, „wir müssen Vorbild“ sein für China und die Welt. So jedenfalls lauteten die Antworten von Politikern, die ich darauf angesprochen habe. Sehenden Auges wird unser Land ruiniert. In China weiß man natürlich, dass CO2 das Lebensgas für die Photosynthese ist, ohne das Leben auf der Erde nicht möglich wäre, da C3-Pflanzen unterhalb von 150 ppm (0,015 %) die Photosynthese einstellen. Man weiß dort auch, dass (lt. IPCC) etwa 97 % der CO2-Emissionen natürlichen Ursprungs sind (Vulkanismus, Verwitterung, etc.) und nur ca. 3 % anthropogen (menschengemacht) sind. Wovon auf die „Entwicklungsländer“ China und Indien etwa die Hälfte davon entfällt und auf Deutschland weniger als 2 %. Mit anderen Worten, Deutschland betreibt „Klimaschutz“ mit Windrädern, um seinen Anteil an den gesamten CO2-Emissionen von 0,06 % (= 3*2/100) auf NULL zu senken. Wer bis Drei zählen kann, erkennt das Geschäftsmodell. Es stimmt, China hat mehr Windräder als Deutschland. China hat aber auch ca. das Dreifache der Stromversorgung etwa der EU. Dies relativiert die Sichtweise.

Zum Schluss ein Schwank – aus dem Klima-Tollhaus

Dr. John Clauser, Physik-Nobelpreisträger 2022, hatte in einer Arbeit die Unzulänglichkeit der Klima-Modelle des UN-Weltklimarates IPCC thematisierte „How much can we trust IPPC climate predictions“ (Wie weit können wir den Klima-Vorhersagen der IPPC vertrauen)? Daraufhin wurde von einem Vortrag vom IMF (International Monetary Fund) ausgeladen, denn er hatte gesagt: „Ich glaube nicht, dass es eine Klima-Krise gibt“ (I don’t believe there is a climate crisis). Nobel Laureate Silenced Erkennt man daran nicht, wie „der Hase läuft“? Ein Physik-Nobel-Preisträger, der zur Wissenschaft zur Interpretation der „Klima-Krise“ durch Verbesserung der Klima-Modelle betragen könnte, wird von Bankern von einem Vortrag ausgeladen, weil er „das Falsche“ gesagt hat. Hier erübrigt sich wohl jeder Kommentar.

Fazit von Dr. John Clauser:

„Das populäre Narrativ über den Klimawandel spiegelt eine gefährliche Korruption der Wissenschaft wider, die die Weltwirtschaft und das Wohlergehen von Milliarden von Menschen bedroht. Die fehlgeleitete Klimawissenschaft hat sich zu einer massiven schockjournalistischen Pseudowissenschaft ausgeweitet. Diese Pseudowissenschaft wiederum ist zum Sündenbock für eine Vielzahl anderer, nicht damit zusammenhängender Missstände geworden.“ Dr. John Clauser – Es gibt keinen Klimanotstand Original-Website: Nobel Physics Laureate 2022 Slams ‘Climate Emergency’ Narrative as “Dangerous Corruption of Science” Dr. John Clauser ist nun Mitglied bei der CO2Coalition in den USA. https://co2coalition.org/ Dieser gehören auch andere Physiker an, wie Prof. Dr. Richard Lindzen, der zusammen mit 300 namentlich und mit Qualifikation genannten Wissenschaftlern die Petition an Donald Trump gerichtet hatte, das Pariser Klima-Abkommen zu verlassen. Unseren Leit-Medien haben darüber nicht berichtet. Petition von Dr. Richard Lindzen an Präsident Trump: „Ziehen Sie sich aus der UN Convention on Climate Change zurück!“ Mit Link zum englischen Original inkl. Liste der Unterzeichner. Doch Petitionen von Physikern oder gar noch Nobelpreisträgern gefallen der UN (und ihrem IPCC) gar nicht, denn „Uns gehört die Wissenschaft“ (we own the science) beansprucht die Leiterin für Globale Kommunikation der UN. Muss man noch mehr wissen, zur KlimaKatastrophe, dem Green New Deal der EU und zu Windrädern? Und zum Ort des Vortrages? “We own the science” – UN Under-Secretary for Global Communication, Melissa Flemming at WEF-Davos (02:00) Bestätigt wurde dies von Susan Diane Wojcicki, CEO von Youtube, ebenfalls beim WEF-Davos. Desinformation werde durch Algorithmen ganz nach hinten geschoben. Besonders genannt wurde dabei auch das Thema Klimawandel. WEF – YOUTUBE CEO SUSAN WOJCICKI PROUDLY ADMITS TO CENSORING INFORMATION ON COVID AND DEMONETIZING So wird durch Zensur sichergestellt, dass wir zum Thema Klimawandel durch BigTech-Media nur das erfahren, was uns die UN, der angeblich die Wissenschaft gehört, sagen möchte, aber keinesfalls das, was ein Physik-Nobelpreisträger, der die Klima-Modelle der UN-IPCC kritisiert, zu sagen hat. Darum muss sich schon jeder selbst kümmern. Denn wie sagte doch Immanuel Kant, dessen 300. Geburtstag am 22.04.2024 begangen wird

„Habe Mut dich deines eigenen Versandes zu bedienen.“

Mit freundlichem Gruß

Dieter Böhme Dipl.-Phys.

Disclaimer:

Sollte ein Link nicht öffnen, diesen bitte kopieren und direkt über den Internet-Browser aufrufen. Der Autor hat keinen Einfluss auf verlinkte Dokumente und kann deshalb für deren Inhalte keine Haftung übernehmen.

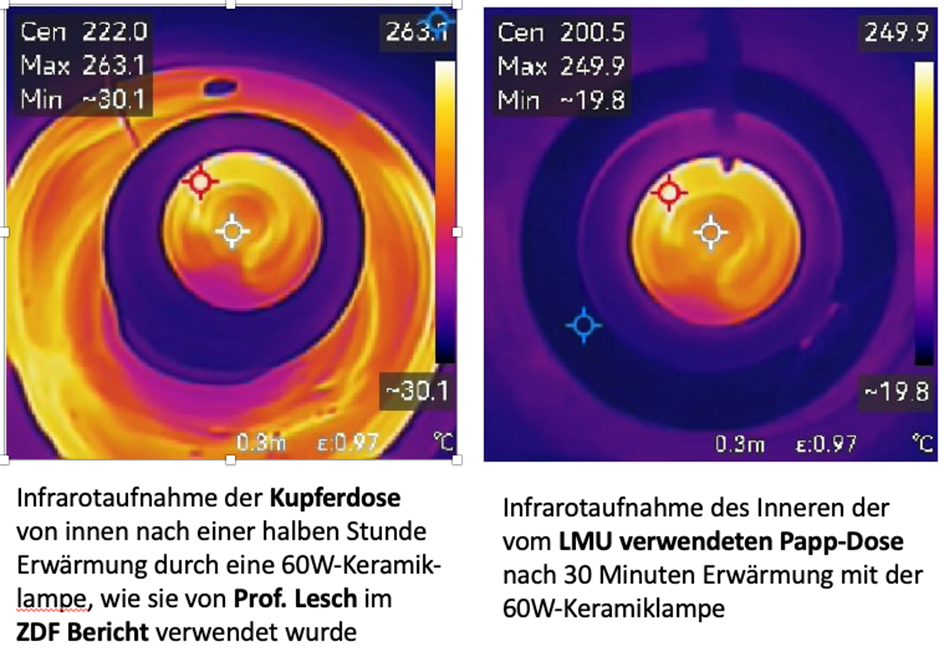

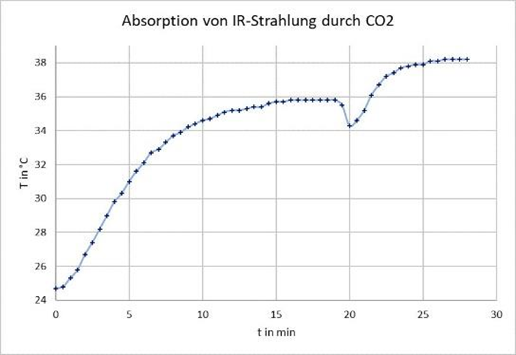

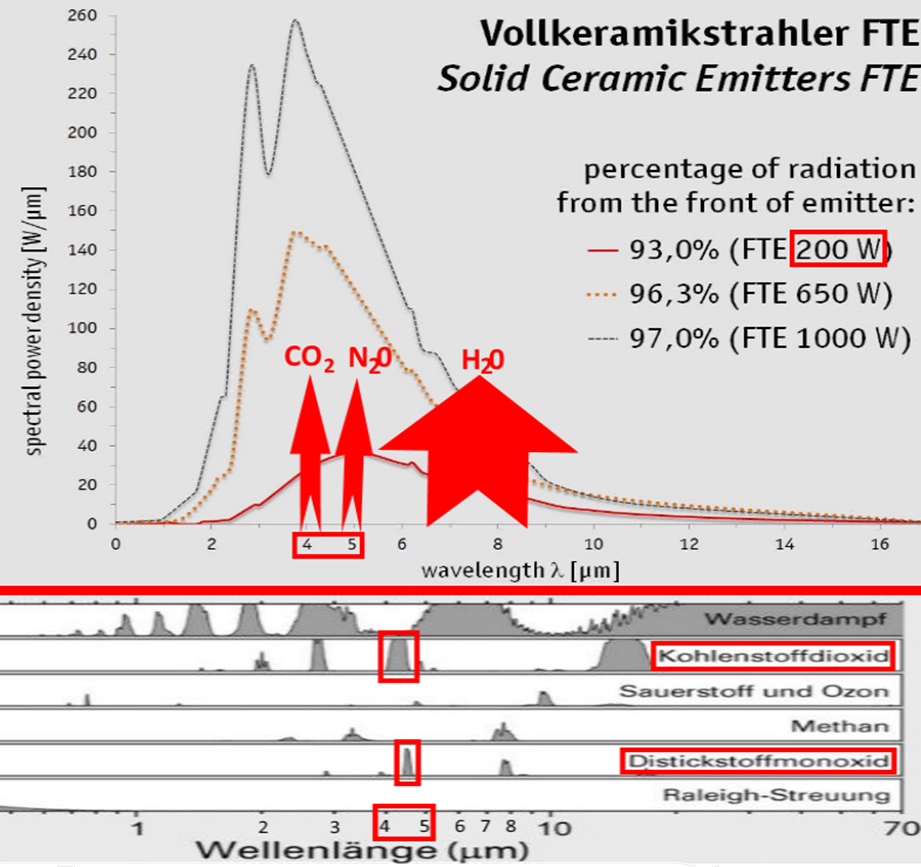

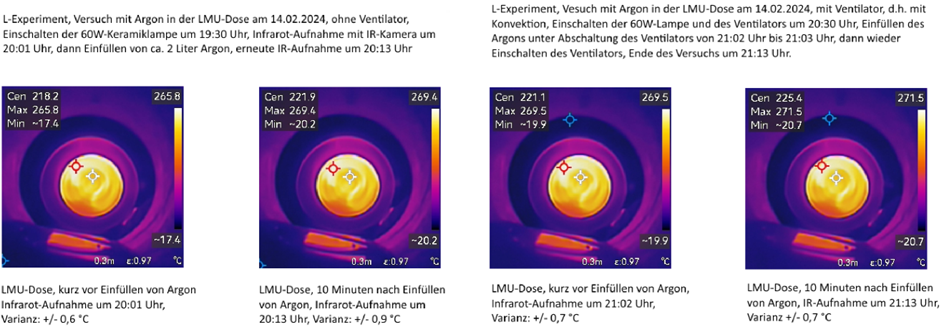

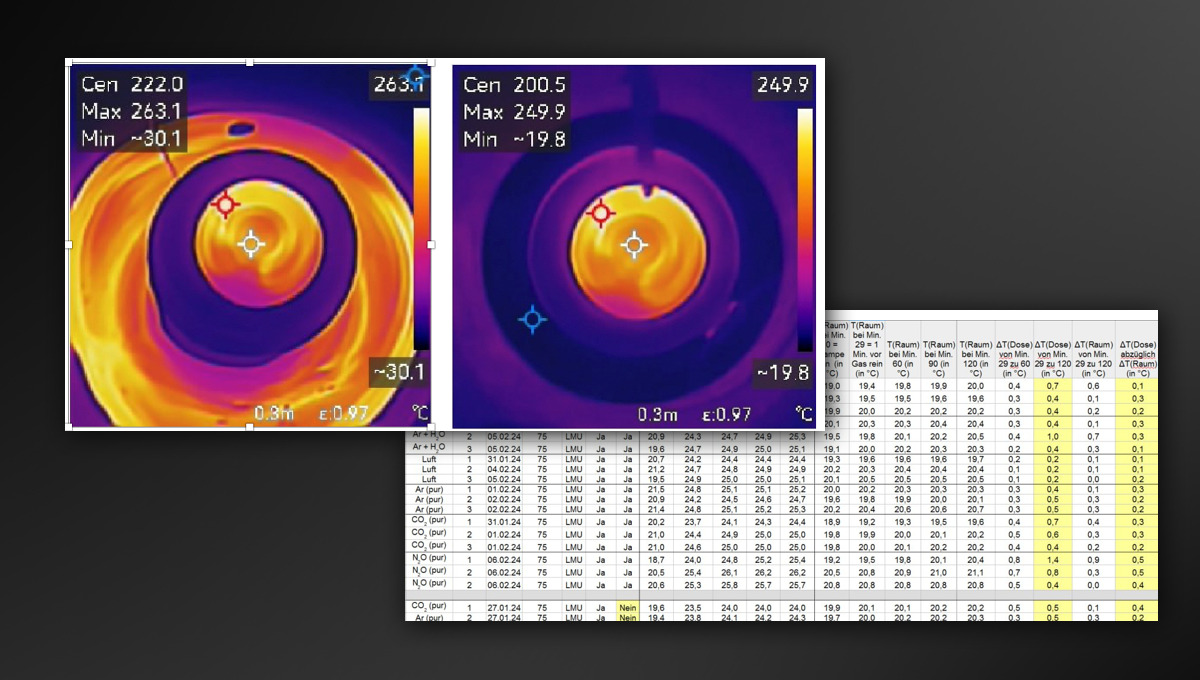

Die früher sehr angesehene Ludwig-Maximilians-Universität München stellt einen „Klimakoffer“ für Schulen zur Verfügung.

Die früher sehr angesehene Ludwig-Maximilians-Universität München stellt einen „Klimakoffer“ für Schulen zur Verfügung.